- Что с этим делать?

- Только массовые методы

- Пассивные и активные меры

- Возможные методики

- Пассивные. Аудит как обычно?

- Аудит как надо

- Анализ ниши

- Анализ работы с быстровыдачей

- Анализ работы с частотниками

- Анализ индексации

- Анализ трафика

- Анализ брендового трафика

- Анализ хвостовой семантики

- Максимизация индекса

- Проработка шаблонов

- Аналитика на коленке

- Наращивание брендового трафика

- Построение системы тегирования под частотники

- Получение трафика со страниц пагинации тегов

- Поиск трендов

- Сканирование прямого эфира

- Генерация посадочных под быстровыдачу

- Стимулирование наращивания ссылочной массы

В этой статье публикуем доклад Дмитрия Шахова об особенностях продвижения больших многостраничных сайтов. Дмитрий уже делал доклад на эту тему, но с тех пор прошло больше года. За это время в данной сфере появились новые аспекты.

Сразу отметим, что классическими методами такие сайты не продвигаются. Например, новостник, занимающийся трансляциями. Если посмотреть его структуру, то мы увидим огромное количество запросов. По ним, в основном, выдает быстровыдачу. Также каждый из них по отдельности генерирует малое число переходов. Соответственно, заниматься семантическим ядром для такого сайта не имеет смысла.

Стандартный подход (аудит, семантика, генерация посадочных и т.д.) для больших новостных сайтов или UGC не годится.

Проблематика:

- много запросов;

- очень много запросов;

- эти запросы, как правило, микроНЧ;

- контент: UGC или привязан к повестке дня (нужно попадать в быстровыдачу);

- нет задачи конверсии, все сводится к максимизации трафика.

Что с этим делать?

На таких сайтах от 1 до 16 миллионов посадочных страниц. Занимаясь на них точечными работами, вы сможете набрать максимум 1-2% трафика. Поэтому они не имеют смысла.

Также порой за сутки выгрузить все ключи нереально. На одном из мамских сайтов, с которым мы работали, за день набралось больше полумиллиона ключей. Из той же метрики можно выкачать только 10 тысяч.

И, допустим, вам даже удалось выгрузить весь этот массив. Но что дальше с ним делать? Проанализировать такой объем информации нереально. Соответственно, заниматься этим бесполезно.

Точечные работы бессмысленны. Даже выгрузить ключи за сутки порой нереально, а иногда и бесполезно.

Только массовые методы

Работают только массовые методы. Здесь есть свои плюсы и минусы. Например, меняя дизайн сайта, вы воздействуете на сразу на все страницы - удобно. Однако переиндексация будет проходить достаточно долго: от 1 до 3-4 месяцев. Да и индексироваться скорее будут новые материалы в новом дизайне.

Все это затрудняет аналитику. Вы не будете видеть точный результат ваших изменений: помогли они или нет, стало лучше или хуже. Перед вами будет некая усредненная статистика, на которую еще накладывается посещаемость старых непереиндексированных страниц. Доля новых еще неизвестна, проанализировать ее практически нереально.

Можно, конечно, попробовать проверить на индексацию миллион страниц, но это потребует больших расходов и заниматься этим ежесуточно также нереально.

Поэтому действуйте массово. При этом учитывайте, что аналитика будет носить усредненный характер. Смотреть ее надо на большом периоде времени - только так вы сможете заметить все последствия ваших изменений.

Только массовые методы - все, что действует на наборы страниц или весь сайт целиком.

И такая же аналитика. Меряем средние показатели, строим графики и ловим отклонения.

Пассивные и активные меры

- Пассивные меры нацелены на изменение уже существующих посадочных страниц. Они не дают серьезного эффекта, но очень нравятся владельцам этих сайтов.

- Активные меры направлены на создание новых посадочных страниц. Они являются основным драйвером роста трафика на таких проектах.

Возможные методики

К пассивным мерам относятся:

- аудит. Практически бесполезная мера по отношению к таким сайтам. Максимизация индексации. Более полезная мера, но все равно носит вторичный характер, потому что основной объем посещаемости приходится на новые страницы;

- проработка шаблонов вывода информации. Может дать хороший эффект, но аналитика будет затрудненной. Понять результативность ваших действий вы сможете только через длительный период времени;

- наращивание брендового трафика. Серьезного драйвера здесь нет, но работать над этим не помешает.

Активные меры могут существенно помочь, но они имеют свои трудности. К ним относятся:

- cоздание посадочных под частотные запросы - тегирование. Драйвер небольшой, но можно получить рост на 5-7%;

- gоиск трендов и посадочные для быстровыдачи. Главное в нашей работе, разберем это чуть позже;

- cтимулирование появления внешних ссылок. Эффект этого метода проявляется на длинной дистанции. Заниматься им важно. А если времени на это нет, узнайте, как покупать ссылки для продвижения сайта.

Разберем все по отдельности.

Пассивные. Аудит как обычно?

Классический аудит:

- найти дубли, битые - устранить;

- найти технические ошибки верстки - устранить;

- добавить микроразметку, где ее нет;

- проверка битых ссылок, вернуть 404 с трафиком в 200 статус или поставить 301

- анализ обратных сслыок и чистка ссылочного профиля;

- решения задач технической оптимизации сайта;

- и т. д.

Действий много, но эффекта почти нет. Причина в смещенности фокуса посещаемости на таких сайтах в сторону новых страниц. А ошибки зачастую находятся на старых страницах, которые поиском игнорируются в силу низкого качества или неактуальности информации. То есть аудит для таких сайтов бесполезен.

Однако он хорошо действует на их владельцев. Видя составленный вами список ошибок, они радуются и готовы платить. Поэтому стандартный аудит для таких сайтов, который легко можно сделать с помощью Screaming Frog Seo Spider или любого другого софта, подходит только для личного заработка.

Аудит как надо

Какой же аудит можно сделать? Я называю его аудитом по поиску точек роста. Им редко занимаются на рынке, т.к. автоматически здесь сделать практически ничего невозможно. Нужно понимать, как сайт работает в нише, какой трафик он получает и где можно найти точки роста. Его составляющие:

- анализ ниши: ищем насколько портал ее охватил. Возможно есть лакуны, в которых можно создать новые посадочные страницы;

- анализ работы с быстровыдачей. Она является основным источником притока трафика на такие сайты;

- анализ трафика по высокочастотным запросам: есть или нет, какие позиции запросов, суммарно какой процент от общего трафика на сайт. Например, бухгалтера делают некоторые запросы по несколько десятков раз в месяц. Если вовремя занять по ним хорошие места в поиске, то можно собирать значительный объем трафика. Это даст нам немногое, но почему бы не сделать?;

- анализ индексации сайта: падает, растет, от чего это зависит;

- анализ трафика;

- анализ брендового трафика: где сайт не витальный по ним, где сниппет не расширенный;

- анализ хвостовой семантики.

Разберем каждый пункт.

Анализ ниши

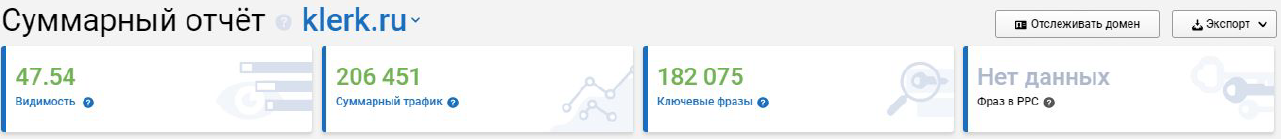

Лучший способ проанализировать нишу - использовать сервисы видимости. Там можно сделать сравнительный анализ по числу ключевых фраз. Выявляем пересеченье и смотрим, подходит ли это нам.

Сначала найти того, у кого больше трафика или ключевиков. А потом убедиться, что вам эти направления роста тоже подходят.

Например, в Serpstat видно, что у klerk.ru 182 тыс. ключевых фраз, а у glavbukh.ru 110 тыс.

Также там видно не охваченные другими сайтами фразы. Не факт, что вы там что-то найдете, возможно это будут какие-то специфические наборы фраз, но поковыряться в этом стоит.

Да, нужно начинать с анализа конкурентов. Но не всегда это возможно.

Например, моя бывшая ученица работала с компанией, не имеющей прямых конкурентов. Весь выпускаемый ею софт являлся лишь одним из элементов продукции у других компаний. В итоге только сравнительный анализ позволил выявить еще не охваченные по ключевым запросам лакуны. Собрать семантику классическим методом из-за отсутствия конкурентов не получалось.

Пример такого отчета.

Анализ работы с быстровыдачей

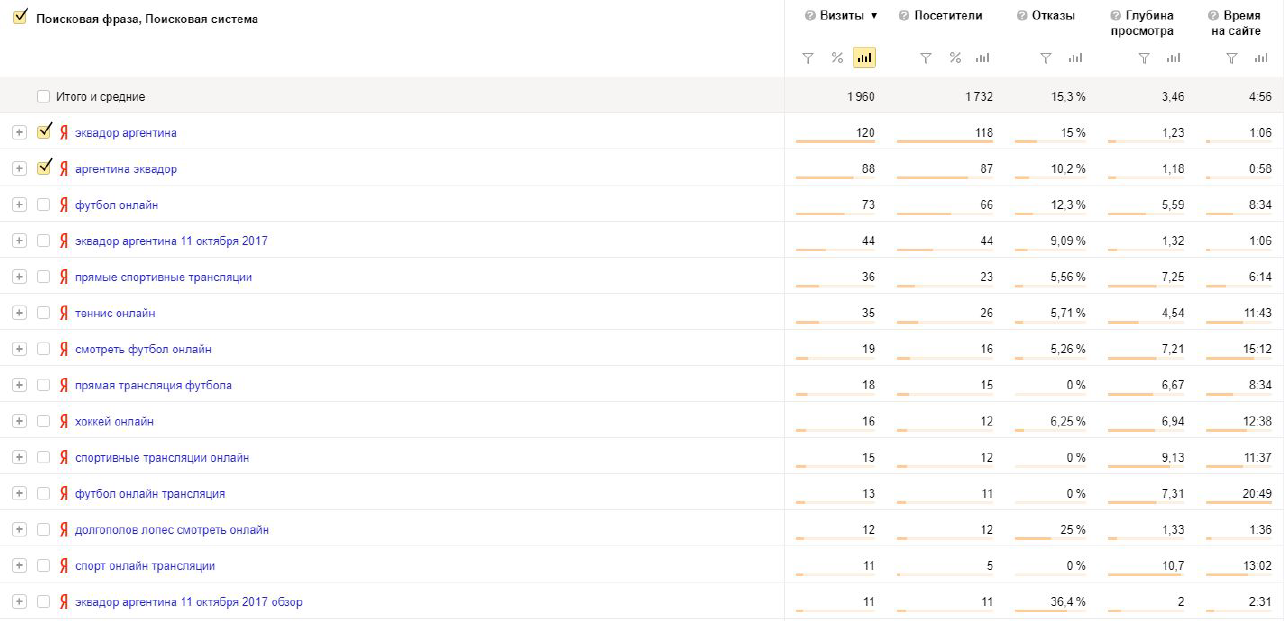

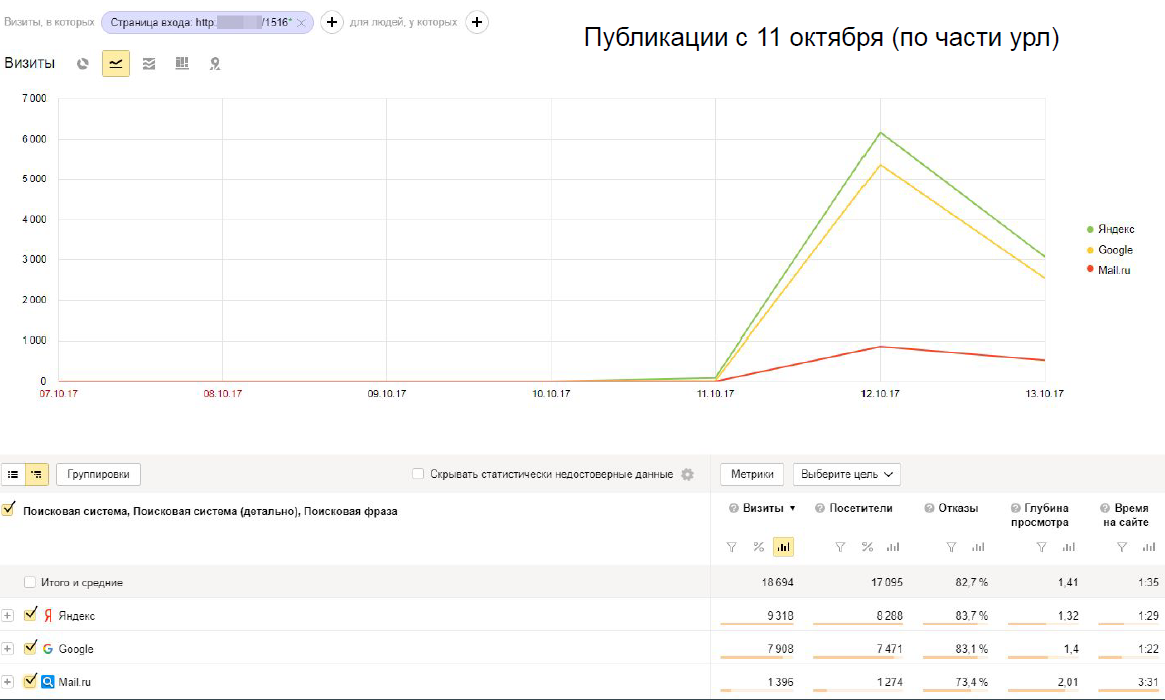

Как понять, что основной объем трафика идет из быстровыдачи? Необходимо посмотреть документы, по которым у вас идет большинство трафика на сайт. Скорее всего окажется, что они создаются в течении первых трех дней. То есть нужно в отчете по трафику посадочных страниц посмотреть наличие трафика с быстровыдачи.

Особенно это важно делать молодым сайтам, работающим с высокочастотниками. Ребята могут писать там статьи, но не получать трафика. Причина в высокой конкурентности по запросу. У нового сайта нет траста, пытаться зайти в топ по суперчастотнику - наивно. Выдача по ним в поиске уже давно сформирована. Выстрелить под ней трудно даже для давно существующих сайтов с большим трастом.

Поэтому всегда смотрите, за что вы боритесь. Следите за трафиком, который идет на новые страницы.

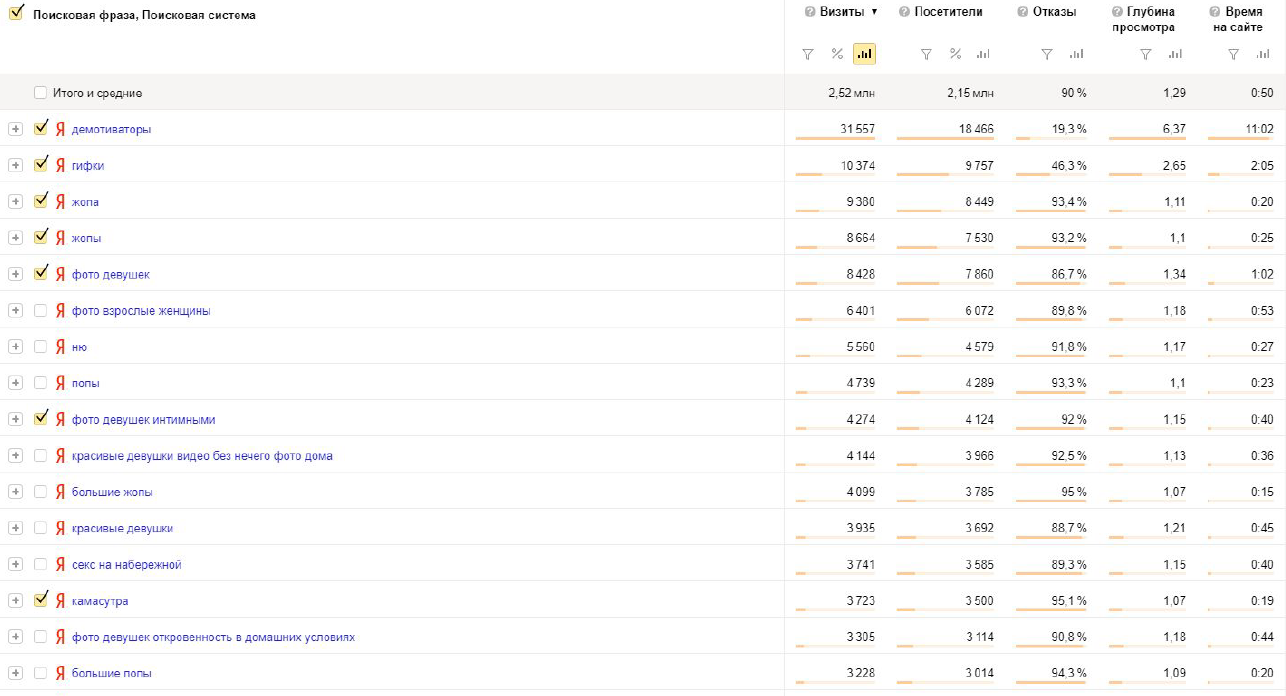

Например, это анализ одного из развлекательных порталов. Он собирает мемы, фото, подборы фото и т.д. У них не было никакого анализатора. Мы выполнили фильтр по хвосту и выявили, что на новые страницы приходится большая часть трафика.

Обязательно нужно узнавать, есть ли работа с быстровыдачей, идет ли оттуда трафик и дальше его максимизировать. Как это сделать - обсудим позже.

Анализ работы с частотниками

Из частотников особо много вы не вытащите. Причина в загрязненной выдаче посадочными страницами с отдельными статьями. Это даже не обязательно быстровыдача. Люди могут искать какой-то конкретный материал.

Например, пытаться создать тематическую страницу по рецепту борща бессмысленно, потому что уже существуют отдельные статьи, где расписаны эти самые рецепты. Генерировать такой тег или такую страницу практически бесполезно. Но все-таки бывают прострелы. Поговорим о них чуть позже.

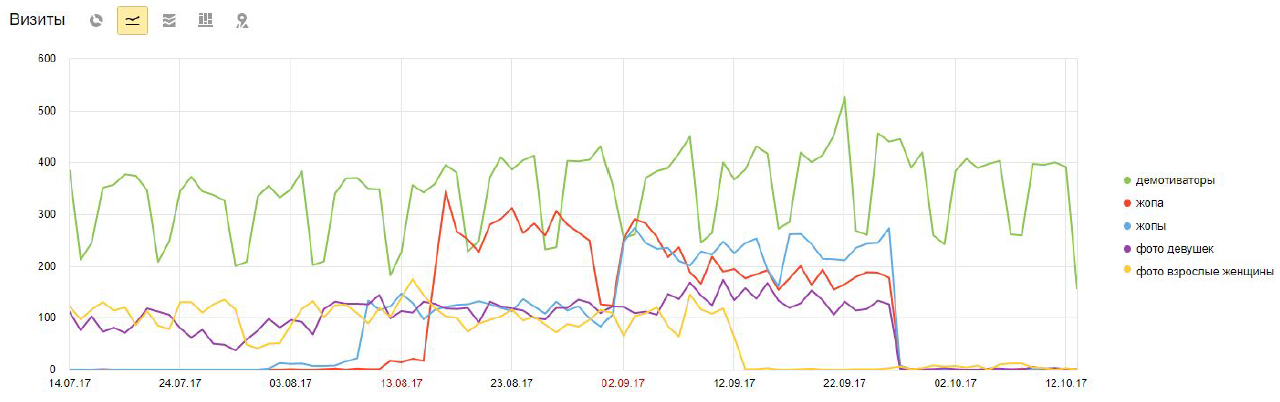

Это хорошо выявляется через анализ посещаемости сайта. Например, посещаемость того же развлекательного сайта. Смотрим график трафика по частотным запросам.

Далее мы видим, что по словам «жопа» и «жопы» трафик быстро выходит на плато. Затем, в течении двух недель, падает. Дальше, выявив такое плато, стоит найти эту страницу и посмотреть, что это была за статья или набор статьей.

Также можно отметить зеленую линию, обозначающую трафик по слову «демотиваторы». У этого сайта был тег, по которому собирались все связанные с этой темой мемы. В итоге они закрепились на выдаче и получают стабильный постоянный трафик.

Отдельной страницы по «жопам» у них не было. Был лишь набор периодических статьей на эту тему. Заходя в топ, они получали трафик в течение пары недель: сначала из быстровыдачи, затем просто как статья, висящая в выдаче. Позже схожие материалы на других развлекательных сайтах из выбивали.

В данном случае можно создать теговую страницу по такому частотнику. Это даст вам лишних 100-200 переходов в сутки. Довольно неплохо.

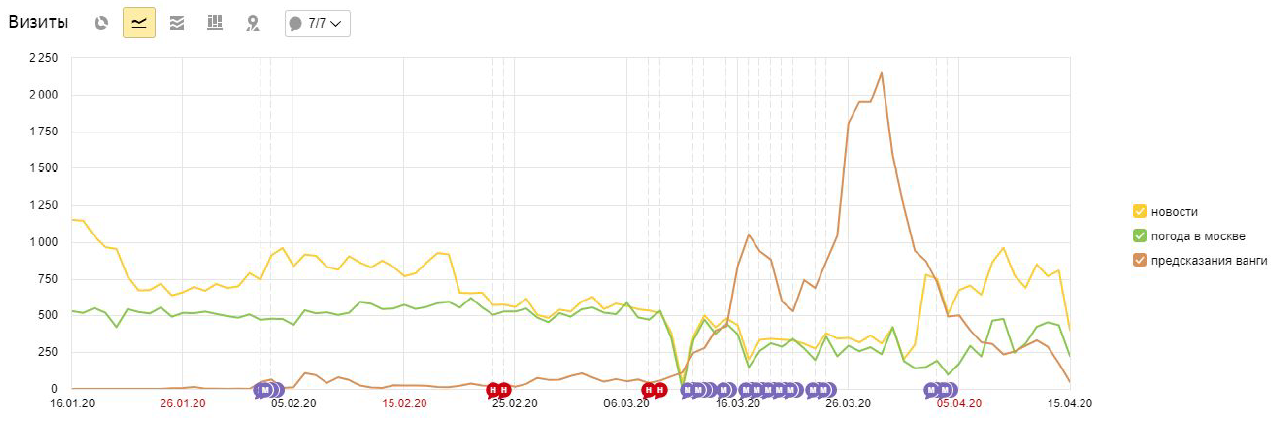

Другой сайт. Картина здесь схожая: по ключам «новости” и «погода в Москве» трафик почти равномерный с привязкой к сезонности. Под них есть отдельные тематические страницы, на которых располагается эта информация. Именно оттуда выхватываются статьи для топа выдачи.

По «предсказаниям Ванги» у них была отдельная статья. Ее актуальность со временем упала, но они получали по ней в течении двух недель (можно сделать вывод, что срок жизни в выдаче статьи - две недели) неплохой трафик.

Анализ индексации

Как уже говорилось, срок жизни актуального материала - порядка двух недель. Тем не менее, по копеечке, хвост из миллиона страниц все-таки приносит трафик. Нужно стараться его поддерживать и максимизировать.

Поэтому важно следить за индексом страниц, но все же с ремаркой на актуальность для нас. Например, у одного из анализируемых нами порталов количество загруженных страниц (расширенный индекс) было 16 миллионов, а в фактическом индексе - 1 миллион. То есть 15 миллионов страниц у них просто были на сайте. Возникает вопрос: “Стоит ли их вообще хранить? Будет ли у них посещаемость?”.

Проанализировать все 15 миллионов страниц - нереально. Проще загнать их в индекс и дальше смотреть, какие из этих материалов могут иметь актуальность, а от каких можно избавиться.

Был раньше хороший сервис от Леши Трудова - bez-bubna.com. Он, в том числе, анализировал такие огромные порталы. Можно было найти страницы, получающие большое количество трафика. Дальше можно было залезть на них и решить, стоит ли возвращать их в индекс.

У Константина Солодянникова был один интересный кейс. В нем он сделал дополнительную перелинковку информационных материалов между собой. Подъем трафика составил порядка 20%. Из массы просевших ниже топ-5 страниц, переставших получать трафик, примерно 20-30% имеют условно вечную актуальность, они еще могут вернуть себе трафик. Остальные - мусор, с которым не стоит заморачиваться.

Ваша обязанность как оптимизатора и аналитика - найти уже бесполезный мусор, на которые можно не тратить время, и вполне актуальные материалы, с которыми стоит работать: разгонять их ротаторами, выполнять перелинковку и т. д.

Анализ трафика

Можно с этим заморочиться, но большого смысла это не имеет. Этот пункт мы проскочим.

Анализ брендового трафика

Вещь важная, но, как правило, у подавляющего числа порталов с этим все впорядке. Тем не менее проверять стоит. В местах, где вы не топ-1 по одному из вариантов написания бренда, нужно найти и устранить проблему.

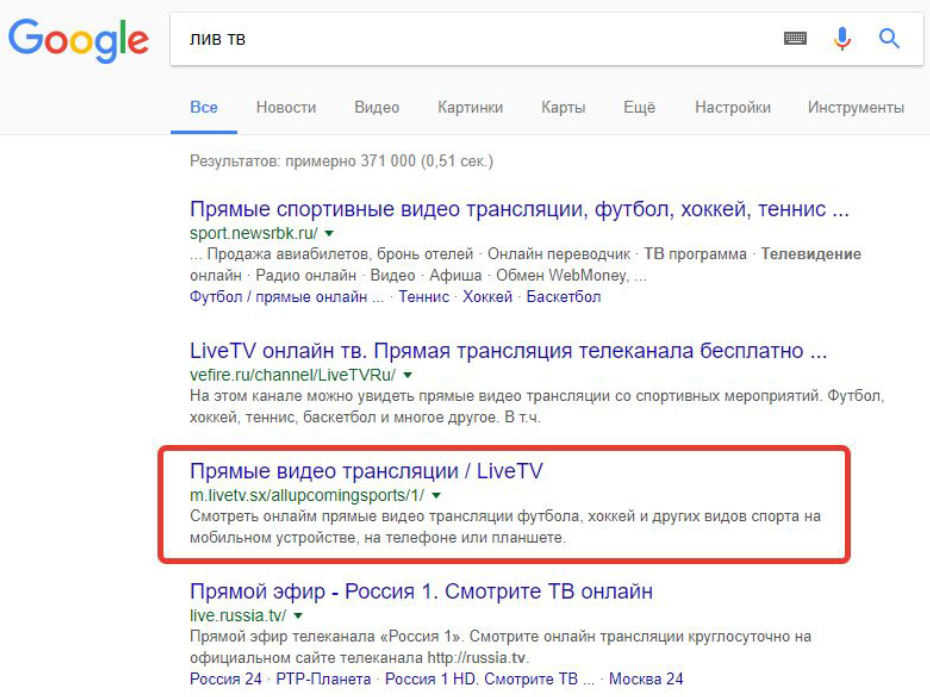

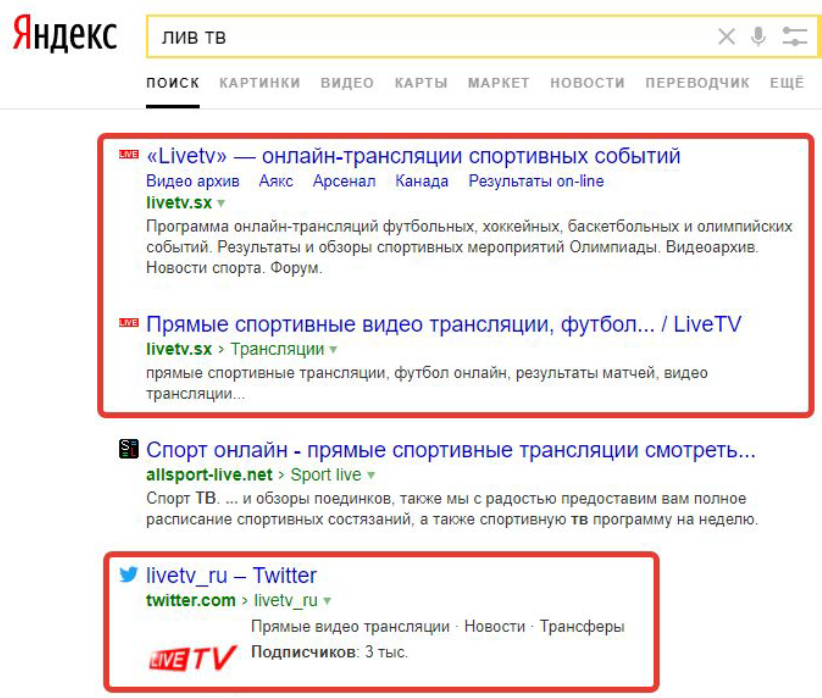

С одним из анализируемых порталов я обнаружил, что в Гуле у них все в целом неплохо: по своему бренду они худо-бедно в топе стоят. Однако они не на первом месте. По запросу «лив тв» (их бренд) они располагались лишь на 3 месте.

Правда это было связано с их политикой монетизации, из-за которой у них были проблемы и им приходилось постоянно переезжать с одного домена на другой. Соответственно, они могли потерять трафик по некоторым вариантам написания своего бренда.

В Яндексе все получше. В гугле они проиграли двум новостных сайтам, здесь же у них все нормально.

Выяснить варианты написания вашего бренда можно следующим образом: в Гугле смотрите ключевые фразы в панели WebMasters, в Яндексе используйте Метрику. Уверяю, там вы найдете от 20 и больше вариантов. У «лив тв», например, порядка их порядка 50. Хотя, казалось бы, всего 6 букв. Кто-то ошибается, кто-то пишет как попало. Отсюда и такое разнообразие.

Поэтому нужно всегда следить за всевозможными вариантами написания. Ведь возможно, по какому-то из них уже появился паразит.

Один из способов паразитизма - захват брендовых ключей и установка сайта витальным ответом. То есть некие товарищи находят ваши брендовые запросы и создают под них отдельные сайты с, порой, случайной информацией. Например, по фразе авиасейлс есть сайт, созданный под их партнерку, не имеющий никакого отношения к авиабилетам. Почему он еще существует - неясно.

Мы так работали с гостиницами, у которых была одна управляющая компания. Соответственно, вся информация о них была на одном ресурсе. Делали сайты под их названия и выбивались в топ. Витальным ответом на их брендовые запросы становилось наше творение. Получалось собирать хороший конверсионный трафик в коммерческой нише.

То есть с этого можно неплохо агрегировать и некоторые мастера этим занимаются. Поэтому обязательно проверяйте свои брендовые запросы.

Анализ хвостовой семантики

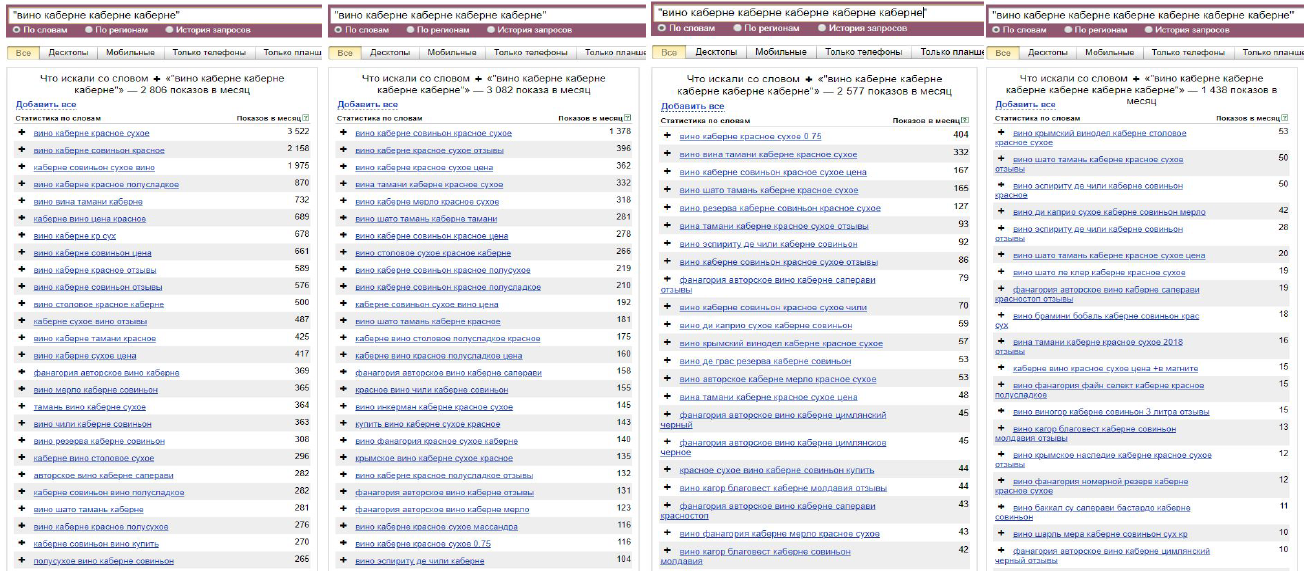

В информационных нишах важную роль играет богатство хвоста у выбранного вами запроса для создания посадочной страницы. Рассмотрим это на примере коммерческого запроса «вино каберне», недавно анализируемого для одного винного сайта.

Если в Вордстате вы повторяете одно из слов, то он начинает подбирать запросы с дополнительными словами: трехсловники, четырхсловники и т. д.

Здесь мы видим следующее: двухсловник «вино каберне» запрашивают по фразовой частотности 880 раз, трехсловников с «вино каберне» уже 2300, четырехсловников - 2800, пятисловников - 3000, шестисловников - 2500, семисловников - 1400. То есть мы видим достаточно богатый хвост, с которым еще можно работать.

Смотря дальше можно найти хвост и побогаче: даже запросы из 15 слов все равно имеют 92 показа в месяц. Все они информационные. Понятно, что вы не сможете работать с такой семантикой при оптимизации конкретной посадочной страницы. У вас не получиться дать такие запросы при написании статьи по причине их незнания.

Но давая некие условия самому автору вы сможете добиться своего нахождения по ним в топе. Сделайте прохождение по кворому - это означает, что поиск будет выдавать результат, в случае отсутствия данной фразы в тексте хотя бы в частичном виде, по меньшему количеству слов из этой фразы. То есть выдача будет сформирована не по 15, а по, допустим, 7 словам.

Вы должны добиться насыщения статьи хвостами. Также они должны находиться рядом. Тогда блочный анализ покажет эти совпадения и повысит шанс попадания в выдачу вашего сайта по таким длинным запросам.

Этот пример показывает, что умение работать с хвостом поможет вам найти запросы, которые могут принести вам трафик просто за счет наличия на них статьи.

Максимизация индекса

Я уже упоминал 15 миллионов страниц, находящихся вне индекса. Их можно вернуть. Вопрос тут в количестве трафика, который они дадут.

Как вернуть страницы вне индекса? Здесь мы уже находимся за рамками анализа «нужно ли их возвращать?», потому что, когда у вас из 16 миллионов страниц 15 вне индекса, вы имеете всего 2 пути:

- принять, что там есть всего 1-2 миллиона страниц, которые принесут нам трафик если мы вернем их в индекс. Затем перейти к самой максимизации индекса;

- забить на них и не заморачиваться.

Заморачиваться все же стоит, так как это почти не требует особых усилий. Фактически все сводится к созданию иных способов перелинковки.

Сначала нужно проверить, есть ли у вас «хлебные крошки» или иная схема перелинковки, сокращающая путь до документов. Часто обнаруживается, что на многих порталах перелинковка реализована в стиле пагинации: статьи расположены одной длинной колбасой. Материал пятилетней давности можно найти только на 100-х и более страницах. Соответственно, там уже не людей, не ботов. До этих статьей никто не добирается, поэтому они выпали из индекса.

Это можно решить либо заморачиваясь с картой сайта, либо реализуя любую другую схему перелинковки, которая будет минимизировать количество переходов до старых статьей. То же самое помогает в крупных интернет-магазинах и агрегаторах. Поэтому заниматься этим надо.

Есть более простое решение - создание ротатора ссылок. Это инфоблок ссылок под материалом или в сайдбаре: знаменитые «Самое свежее», «Лучшие материалы» и т. д. Ваш программист должен сделать стак всех URL вашего сайта, загрузить его в отдельную базу и дальше рандомно выкидывать из него 5 любых ссылок. Эта пятерка будет появляться на 15 миллионах страниц. Если у вас в индексе всего 1 миллион, то вы получаете 5 миллионов (1х5) внутренних ссылок на вашем сайте. Боты их видят и начинают по ним переходить. Соответственно, какая-то часть этих страниц, за счет возникшей перелинковки, вновь станет актуализирована и вернется. В среднем возврат составляет 5-10%, иногда достигает 20%.

На эту тему есть старенький доклад от Виктора Карпенко. Там рассматривался сайт, на котором посещаемость увеличилась в 2-3 раза после внедрения этого ротатора.

Можно заморочиться с более сложной версией ротатора - Ловец ботов. Но мой пыл в его отношении поугас. Причина в неготовности реализации программистами ловца на том уровне, при которым он мог бы работать автоматически и максимизировать свою собственную эффективность.

Разница между ротатором ссылок и ловцом ботов в том, что последний показывает ссылки на непроиндексированные страницы только ботам. Обычные же пользователи видят ссылки только на проиндексированные страницы. На основе этого реализуется более сложная и эффективная схема работы с ботами. С ротатором же вы полагаетесь исключительно на удачу: увидит ли бот непроиндексированные страницы или нет? Это снижает эффективность.

Внедрение таких ротаторов дает в том числе рост краулингового бюджета. Многие на таких сайтах беспокоятся о лишних затратах на краулинг. Не стоит волноваться: основной объем трафика (80-90%) сосредоточен в области быстровыдачи, тематического трафика мало. Поэтому краулинг не играет здесь такого принципиального значения.

Также с помощью ротатора можно запихивать новые страницы. В этих случаях краулинг может растянуться в 2-5 раз за счет получения ботами через ротатор ссылок на новые страницы. Произойдет вспышка обращений ботов, они набегут тысячами и быстро все это дело проиндексируют.

Таким образом, ротатор это мощный инструмент, который можно использовать при проблемах с индексацией.

Проработка шаблонов

Один из самых неочевидных методов. Причина в следующем: после изменения шаблонов должно пройти много времени, чтобы все это проиндексировалось и вы смогли зафиксировать рост от ваших действий.

Шаблонов вообще не много. На сайте-новостнике только 2 основных: категории и статьи. Они и приносят трафик. Возможно могут быть еще какие-то теговые фильтры и спецпроекты, но шаблонов, в любом случае, будет в районе 10. При работе с одним новостным портал мы едва собрали 20.

Дорабатывайте и исправляете ошибки в шаблонах при необходимости. Контент на вашем сайте должен быть читаемым и приятным на вид для пользователя. Устраняйте неудобства: лишний скроллинг из-за большой шапки, реклама прямо в статье, маленький или крупный размер текста и т.д. Не помешает анализировать конкурентов, возможно получится извлечь что-то для себя полезное.

В проработке шаблонов есть и плохая сторона. Вы можете не угадать: ваши изменения не только не дадут роста, но и ухудшат ситуацию. А узнаете вы это только через 3-4 месяца. Хороший момент - вы действуйте сразу на весь сайт. Это может помочь кардинально улучшить посещаемость.

Здесь есть свои ножницы. Суть их в том, чтобы делать сначала MVP. Вы берете какой-то объем посадочных страниц и внедряете изменение шаблона только там. Это не всегда возможно на топорных движках, но хорошая программистская команда сможет добиться изменения шаблона для отдельной категории. Далее, после пары месяцев, смотрите посещаемость. Если она выросла, то масштабируете эти изменения на весь сайт.

Сегодня для такой аналитики серьезных инструментов нет. Тут вы либо работаете головой (метрика, analytics), либо используете seowork.ru, так как ничего лучше на рынке попросту нет.

Аналитика на коленке

При построении аналитики смотреть трафик по отдельным фразам бессмысленно. Но вы можете выполнять корреляционный анализ. Вам понадобиться составить 4 графика:

- график трафика из поисковых систем;

- график видимости от 1000 фраз разной частотности. Анализируется это в seowork или в вашем собственном написанном анализаторе (если есть);

- график числа поисковых фраз, по которым переходили на ваш сайт из поиска. Это потребует некой надстройки над метрикой или analytics, но оно того стоит;

- график числа посадочных страниц, получивших поисковый трафик.

Все 4 графика у вас должны коррелировать. Например, вы получили прирост посещаемости, но не получили прироста по поисковым фразам. Это может быть следствием становления одной из поисковых фраз, по которой заходили на ваш сайт, суперчастотником. Если вы не создавали посадочные под именно этот частотник, то это не ваша заслуга, а скорее изменения в самой ниши.

Если же показатели всех 4 графиков растут одновременно, то это результат уже ваших действий.

Успех вашей работы с такими сайтами зависит от умения рисовать эти графики.

Наращивание брендового трафика

Способы нарастить брендовый трафик:

- коллаборация с другими изданиями;

- акции и конкурсы;

- интервью и прочий PR;

- крауд-маркетинг в промышленных масштабах или точечно в трафиковые места.

То есть уже скорее работа вашего pr-менеджера, а не ваша. От вас требуется в режиме консультации передать ему все необходимое и дальше следить за ходом работы.

Рост популярности бренда приведет к росту type in, а это один из самых мощных драйверов роста поискового и тематического трафика.

Построение системы тегирования под частотники

В конце статьи на любом новостном сайте есть теги. Перейдя по ним, вы получите подборку материала по этой теме. Зачастую эти теги носят бессмысленный характер, так как они создавалась ничего не понимающими в поисковом продвижении редакторами.

Раньше мне казалось, что путем упорядочивания можно убрать нечастотные теги и пустышки, за счет чего увеличится трафик. Но на деле получается насобирать где-то 5-7% дополнительного трафика.

Крайне редко бывает больше. Это должна быть какая-то странная ниша, по которой в выдаче стоят тематические подборки.

Поэтому находя частотники, необходимо проверять выдачу. Если там стоят отдельные статьи, то выкидывайте эти ключи из ядра и больше не заморачивайтесь насчет них как тегов.

Разметка под ключи, если ее до этого не было, создается с помощью информационного поиска (сфинкс, эластик). В дальнейшем контент будет подбираться под эти теги сам. Но эффективность всего этого невысокая, т.к. по большинству ключей стоят отдельные материалы и с тематической подборкой вы туда не пробьетесь.

Проверяем, что по тэгу в выдаче. Если статьи, то выкидываем такой ключ.

В основном, приносящие эффект ключи, это имена собственные: названия, ФИО. Например, на одном новостном сайте справочник персон дает 20-30% от общего трафика. Создание контента именно под тематические и общие запросы, как правило, эффекта не дает.

В некоторых нишах могут срабатывать справочные термины, но это нужно проверять по выдаче.

Получение трафика со страниц пагинации тегов

Закрывать пагинацию не имеет смысла. Делающие это на информационных сайтах обычно считают, что вторые и далее страницы пагинации будут считаться дублями. Но на деле поиску неважно, открыта она или нет. На страницах, которые он сочтет дублями, он и так выполнит эвристическую склейку.

Зато пагинацию можно использовать. На первой странице строите шаблон «ОсновнойКлюч - Бренд». На второй и далее - «ОсновнойКлюч Хвост_N - страница N - Бренд».

Вторые и далее страницы получают от 3 до 10% поискового трафика. Закрыв пагинацию, вы их потеряете.

Трафик на эти страницы попадает по содержащемуся на них контенте: цепляется за микрочастотные ключи из сниппетов статьей. Поэтому вполне имеет смысл показать их поиску. Вы сможете это усилить добавив в пагинацию хвосты - так вы максимизируете эффект от нее.

Поиск трендов

Ключевой момент в работе с большими сайтами. Тренды приносят основной объем трафика. Найти их помогут:

- график событий. Все, что будет происходить в будущем;

- появление новых терминов и умение вовремя их выявить;

- сканирование прямого эфира.

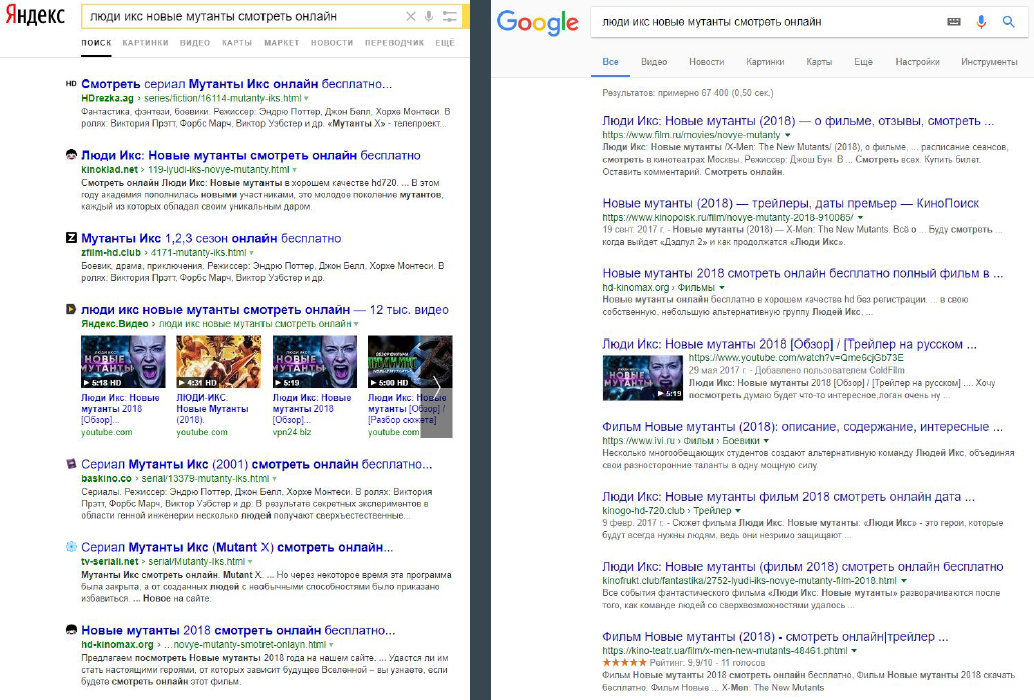

Например, под еще не вышедшие фильмы уже создаются посадочные страницы.

Также вы можете выявлять новые фразы. Например, на момент 2017 года по «блокчейну» уже было поздно влезать, а вот по «poloniex» можно было вполне преуспеть. Выявивший вовремя тренд по коронавирусу сейчас собирает на этом немало трафика. То есть умение вовремя поймать тренд существенно поможет в работе.

Сканирование прямого эфира

Выискивать эти фразы можно из:

- подсказок. Парсите по маркерам, ищите ключи, отсутствующие в вашем ядре;

- рейтинга хэштегов. Используете твиттер, инстаграм, ютуб и т.д.;

- парсинг прямого эфира Liveinternet: http://www.liveinternet.ru/stat/ru/queries.html;

- мониторинг поисковых фраз из своей метрики, трафика по которым не было.

Работа везде выглядит так: все найденное за сегодня собирайте в отдельную базу. На следующий день делаете то же самое и складывайте это с базой предыдущего дня. Добавляйте все новое. Базу третьего дня складываем с накопленным за два предыдущих. Через две недели у вас накопятся ежедневно появляющиеся ключи. Далее, каждый раз вычитая из базы за сегодняшний день все накопленное за предыдущие, вы будете получать 5-10, максимум 100 новых ключей. Они и могут являются нарождающимися трендами.

Что это значит? На следующий день вы опять снимайте всю доступную базу, сравниваете ее с предыдущей. Возможно, вы увидите повторение инкрементации. То есть, например, в 101 день у вас появился новый ключ. Он остался в 102, затем в 103, 104 и 105 днях. Соответственно, это уже устойчивый тренд, можно отдавать его редакторам.

Есть даже компании, которые зарабатывают на продаже трендов.

Генерация посадочных под быстровыдачу

Кто-то, где-то и как-то генерирует контент. Ваша задача подготовить его быструю дистрибуцию.

На средненьких новостных порталах редактор получает материал от автора, проводит контент-менеджмент и публикует статью. На хороших порталах кнопку «Опубликовать» нажимает сеошник после выполнения механизма дистрибуции. Так на статью сразу же появятся ссылки на старых материалах, других сайтах и т. д. Создастся перелинковка. Поиск это заметит и шанс занять самое высокое место в быстровыдаче значительно повысится.

Пример с матчем Штутгарт - Кельн. Мы видим пометки «позавчера», «вчера», «10 минут назад». Это и есть быстровыдача.

Стимулирование наращивания ссылочной массы

Действительно, естественное увеличение ссылочной массы требуется для продвижение любого сайта. Но заморачиваться со ссылками для таких сайтов, по правде говоря, большого смысла нет. Ссылочное на таких порталах активно генерируется само. Но если нет, стоит посмотреть бесплатный курс по линкбилдингу от Игоря Рудника.

Нужно работать по принципу лотерейного билета. Не купив его, лотерею вы не выиграете. Поэтому нужны:

- кнопки репоста;

- контент от лидеров мнений, которые сами его зарепостят. Это дело редакторской команды. Играет важную роль для молодых сайтов;

- попадание в подборки, создание подборок;

- хайповый контент;

- виральный контент: инфографика, тесты;

На графике видно, что даже самые молодые сайты за полгода набирают достаточно большое количество доменов-доноров. На одном сайте мы насобирали таких 350 использую только стимулирующую технику.

Неплохо работает виральная техника. Здесь товарищи создали на своем сайте тесты. На них они насобирали по 2300 ссылок. Довольно крутой результат.

На этом все!