Что такое индексация сайта

Индексация сайта (поисковая индексация сайта) – сканирование сайта и добавление его в базу данных (индекс поисковых систем).

Это если совсем просто и коротко. А если подробнее?

Важно! Если вы хотите получать аудиторию из поисковых систем – сайт должен быть открытым для индексации.

Поисковые системы типа Google сканируют страницы сайтов, чтобы классифицировать их и добавить в Индекс – базу данных. Поисковые роботы – пауки или краулеры – собирают информацию о тексте, видео, изображениях и другом доступном для сканирования контенте. Робот проверяет его на соответствие требованиям, отсеивает спам и добавляет полезный контент в свою базу.

База данных поисковику нужна, чтобы выдавать пользователям верные результаты по запросам. Чем более релевантен сайт запросу, тем выше в списке результатов он находится, а значит и получает больше переходов.

В данной статье мы разберемся с самыми важными вопросами, связанными с индексацией сайта и страниц:

- Как узнать, проиндексирован ли сайт;

- Как проверить количество проиндексированных страниц сайта в поисковой системе Гугл;

- Как проверить индексацию страниц;

- Как ускорить индексацию сайта в Google;

- Какие поисковые операторы можно использовать;

- Как использовать robots.txt и sitemap.xml для быстрой индексации страниц.

Чтобы узнать подробно, как индексировать страницы или сайт и можно ли ускорить индексацию, пройдите бесплатные SEO курсы 2021 для начинающих от Сергея Кокшарова. Курс уже достуен в Академии Коллаборатора.

Как проиндексировать сайт в Google

Чтобы проиндексировать сайт в Гугле, воспользуйтесь инструментом для вебмастеров — Search Console. Поисковики индексируют сайты с разной скоростью. Google обычно «рассматривает» сайт максимум неделю. Но чтобы не ждать, можно самому повлиять на скорость индексации.

Google Search Console

Чтобы добавить сайта в Google Search Console:

- Перейдите на страницу Search Console и войдите в свой аккаунт или зарегистрируйтесь.

- Добавьте сайт в систему.

- Подтвердите права на сайт.

Когда сайт проиндексируется, вы увидите отчет.

Проверка индексации страниц в Google

Как ускорить индексацию сайта в поисковых системах

Скорость индексации зависит от:

- частоты обновления контента;

- внутренних и внешних ссылок;

- наличия трафика на сайт с других источников;

- технической оптимизации сайта;

- корректной настройки CMS системы.

Да, рано или поздно роботы сами найдут ваш сайт и проиндексируют его, но ждать можно долго. Помимо ручного добавления сайта в систему поиска, существуют другие рекомендации.

Как ускорить индексацию в поисковых системах:

- добавляйте новый уникальный контент регулярно;

- упрощайте навигацию по сайту;

- настройте robots.txt;

- создайте карту сайта для поисковых роботов;

- сделайте внутреннюю перелинковку;

- используйте внешние ссылки. Чтобы научиться эффективно наращивать ссылочную массу, смотрите бесплатный курс по линкбилдингу от Игоря Рудника.

Главная рекомендация для ускорения индексации: создайте sitemap.xml на вашем сайте и добавьте его в Google Search Console.

Читайте также: Как проверить и ускорить индексацию страницы в Google, а также как отправить страницу на переиндексацию в Google Search Console

Пропишите правила индексации сайта в robots.txt

Файл robots.txt хранится в корневом каталоге сайта, он может быть только один. Это текстовый файл, в который записывают правила для каждого отдельного поискового бота или для всех сразу. Правилами можно «спрятать» от роботов технические страницы, сделать акцент на важных и т.д.

Проверить файл можно прямо в Search Console.

У пауков ограниченное время на посещение сайта (краулинговый бюджет), и если дать ему обрабатывать все подряд страницы, то он может не успеть проиндексировать самые важные, «застряв» на технических.

Например, если у вас интернет-магазин, в robots.txt стоит закрыть от индексации внутренний поиск, корзины покупателей. Подробнее о работе с файлом можно прочесть в справке Google.

Как закрыть сайт от индексации в robots.txt, читайте в материале.

Создайте и настройте карту сайта sitemap.xml

Sitemap.xml – карта сайта, куда нужно добавить все страницы, которые нужно проиндексировать. Карта поможет определить, где находятся страницы и частоту их обновления, приоритетность в структуре.

- Необходимо создать карту сайта.

- Указать в карте сайту правила индексации страниц: дату обновления страниц, приоритет страниц и другие параметры.

- Добачить карту сайта в панели для вебмастеров Google Search Console.

Файл обычно располагается по адресу https://domain.com/sitemap.xml.

В файле используются специальные теги XML:

- <url></url> – обозначает начало и конец блока страницы;

- <code></loc> – указывает адрес страницы;

- <lastmod></lastmod> – указывает дату последнего обновления страницы;

- <code><priority> – указывает приоритет страницы;

- <changefreq></changefreq> – указывает частоту обновления страницы с помощью:

- never – никогда;

- yearly – раз в год;

- monthly – каждый месяц;

- weekly – каждую неделю;

- daily – каждый день;

- hourly – каждый час.

Для больших сайтов имеет смысл создать несколько карт.

Делайте внутреннюю перелинковку

Внутренняя перелинковка – это ссылки на другие страницы вашего сайта. С ее помощью вы формируете структуру, которая помогает пользователям ориентироваться на сайте.

Внтрення перелинковка ускоряет индексацию страниц, так как роботы сами проходят по ссылкам и проверяют их. Роботы сканируют сначала главную страницу и материалы с высокой приоритетностью. Грамотная перелинковка направит роботов на нужные страницы и значительно ускорит индексацию новых материалов.

Главные рекомендации по перелинковке:

- Не делайте страницы с глубоким уровнем вложенности; идеальный вариант, это чтобы к любой странице сайта можно было добраться в 3 клика с главной страницы.

- Используйте принцип “Википедии” – активно ставьте ссылки внутри статей и других страниц.

Внутреняя перединковка ускоряет индексацию страниц

- Избегайте одиноких страниц, на которые не ссылаются другие страницы.

Получайте внешние ссылки на сайт

Если кто-то ссылается на ваш сайт, значит ему доверяют. Чем больше внешних ссылок (бэклинков) на ваш сайт, тем больше вероятность получить внимание поискового бота. О том, как покупать ссылки для продвижения сайта, мы писали ранее. А если вы только разбираетесь в основах линкбилдинга, советуем почитать статью и посмотреть видео-урок, что такое линкбилдинг.

Чаще остальных ресурсов боты сканируют соцсети и новостные порталы, ведь они обновляются чуть ли не каждую секунду. Ссылки с них на ваш сайт сработают лучше всего.

Сайты с самой высокой скоростью сканирования ссылок:

- Twitter,

- Facebook.

Попробуйте также размещать ссылки на тематических форумах. Чем больше пользователи будут взаимодействовать с постом со ссылкой и самой ссылкой, тем быстрее краулеры обратят на нее внимание.

Постоянно следите за тем, какие появляются внешние ссылки. Узнайте, как проверить обратные ссылки на сайт, как посмотреть внешние ссылки конкурента, какие есть бесплатные и платные сервисы.

Как проверить индексацию сайта или отдельной страницы

Есть несколько способов проверить, как проверить индексацию сайта или отдельной страницы в поисковых системах.

Поисковые операторы

С помощью поисковых операторов можно проверить индексацию сайта, количество страниц в индексе, индексацию отдельной страницы. С помощью поисковых операторов можно проверить количество проиндексированных страниц любого сайта, что очень важно при анализе сайтов конкурентов.

1. site: - оператор для проверки индексации сайта в поисковой системе Google. Введите в строку поиска текст "site:[адрес вашего сайта]", чтобы узнать количество индексируемых страниц.

Обратите внимание! Если количество проиндексированных страниц в поисковых системах сильно отличается, это может говорить о проблемах на сайте, о санкциях поисковых систем.

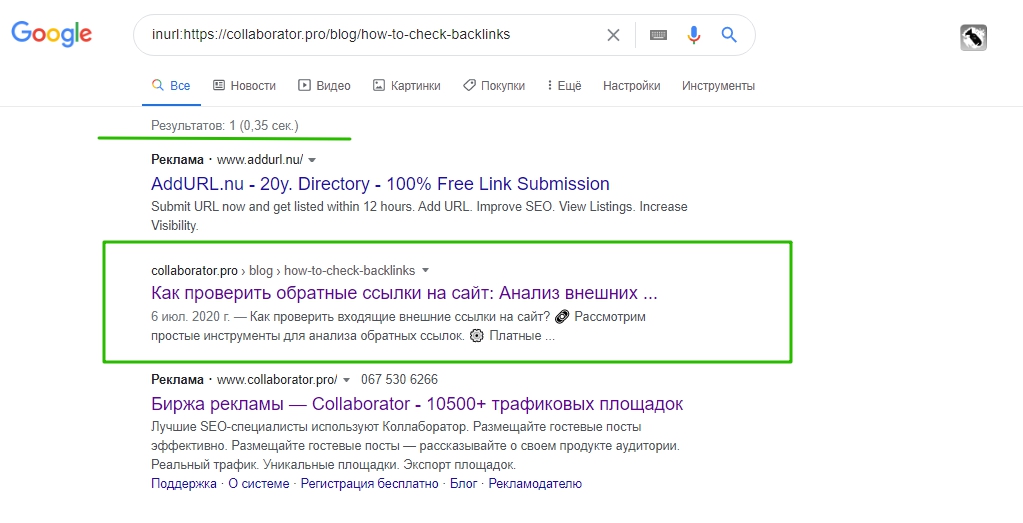

2. inurl: - оператор для проверки индексации страницы в поисковой системе Google. Введите в строку поиска "inurl:[адрес проверяемой страницы]", чтобы узнать, проиндексирована ли эта страница.

Плагины для проверки индексации страниц

Многие SEO-специалисты пользуются плагинами и расширениями для проверки индексации, например RDS Bar. Его можно установить как расширение в браузер и проверить, открыта ли конкретная страница для индексации. Также RDS Bar позволяет проверить метатеги сайта, ИКС, узнать, нет ли запрета на индексацию текста или ссылок на странице, узнать другие важные параметры сайта или отдельных страниц.

Плагин RDS bar позволяет проверить индексацию страницы.

Второй популярный плагин - Seo Magic - также показывает количество страниц в индексе Google. При нажатии на интересующую цифру открывается выдача поисковой системы.

Сервисы для проверки индексации

Также популярны автоматические сервисы, которые массово собирают данные об индексации, такие как Netpeak Spider . Он может просканировать весь сайт, собрать все страницы. А Netpeak Checker выдаст сведения об индексации, информацию об ошибках и порекомендует, как от них избавиться. Софтина платная.

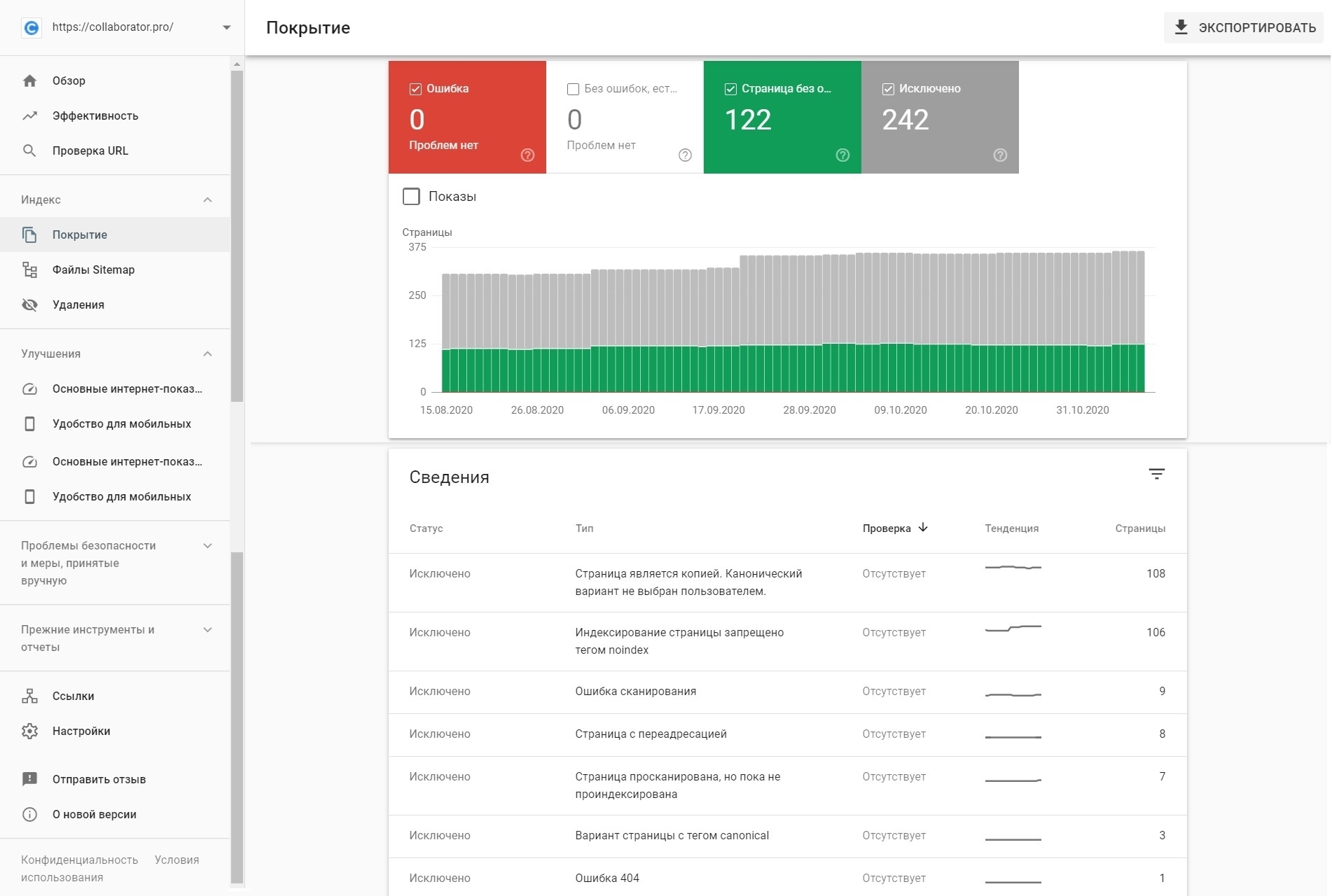

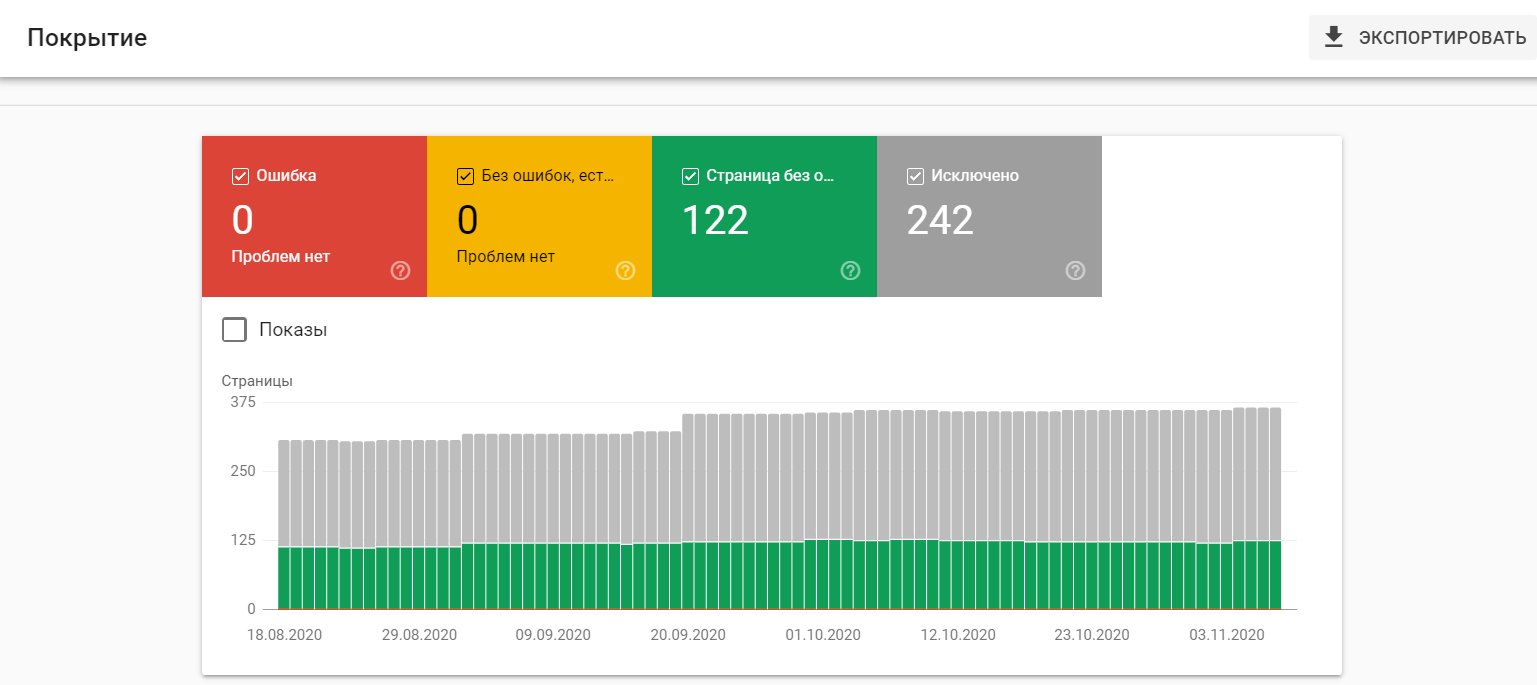

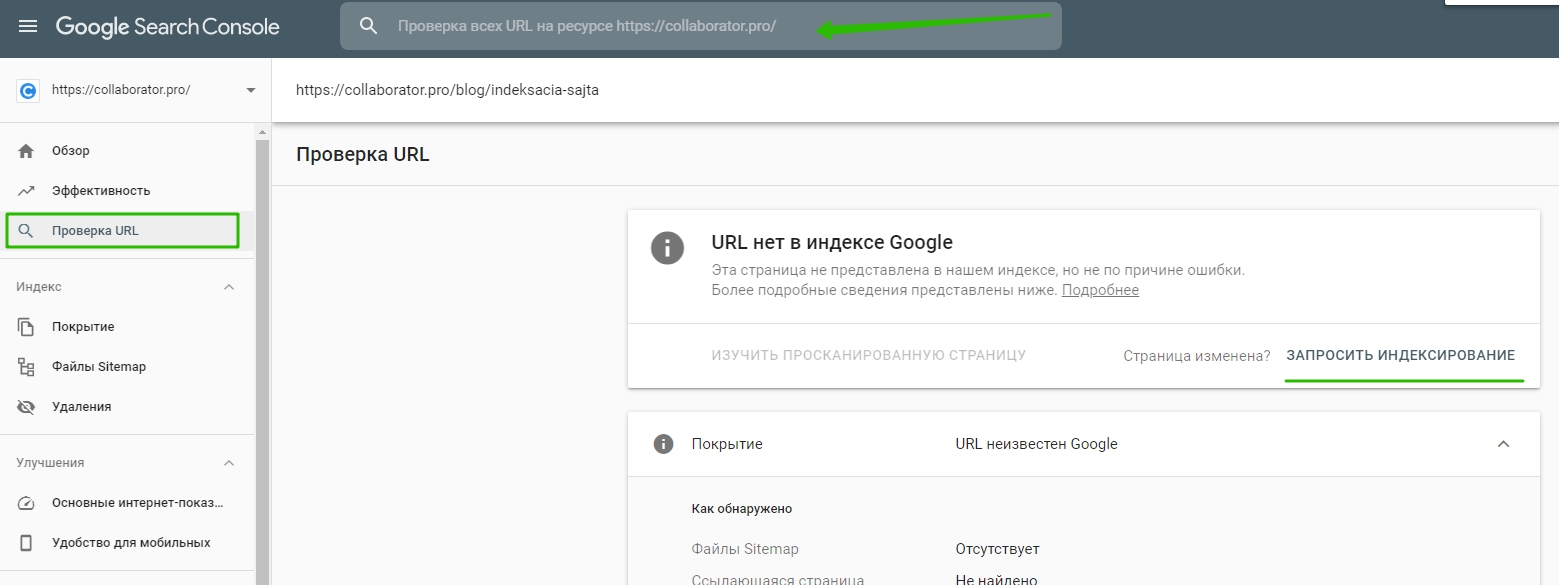

Панель вебмастера Search Console

Проверить индексацию страниц можно и в панеле вебмастеров Google.

Вы можете проверить:

- количество проиндексированных страниц;

- динику индексации страниц поисковыми страницами;

- страницы, которые исключены из поиска;

- причины, почему страницы исключены из поиска.

Для Google зайдите в Search Console и на вкладке «Обзор» выберете график «Покрытие». График отображает разными цветами количество страниц без ошибок, с ошибками. Можно рассмотреть, какие ошибки мешают индексации. Новую страницу или исправленную можно отправить на индексацию кнопкой «Запросить индексирование».

Почему сайт или страницы не индексируется

Сайт или отдельные страницы могут не индексироваться поисковыми системами по ряду причин.

1. Поисковик еще не знает о сайте или странице. Прошло мало времени с момента появления страницы. Стоит подождать минимум две недели, чтобы сайт проиндексировался. Если сайт редко обновляется и на него нет внешних ссылок, поисковой бот просто не сможет узнать о нем.

2. Некоторые разделы закрыты для пауков. Это может происходить по желанию владельца сайта через robots.txt. Также возможно ваш сайт находится в черном списке – он может быть под санкциями или распространять вирусы.

3. Техническая ошибка на странице или сайте. Возможные ошибки:

- некорректные HTTP-заголовки;

- некорректные редиректы;

- неверно указанная кодировка, которую робот увидит как набор бессмысленных символов;

- ошибки сканирования, на которые указывают сами поисковики в панелях для вебмастеров;

- отсутствие или некорректная настройка sitemap.xml.

4. Плохое качество документов. Неуникальный контент, внутренние дубли, малый объем уникального текста, шаблонность в документах раздела, медленная скорость загрузки.

Как ускорить индексацию сайта или страниц

Чтобы проиндексировать новую страницу сайта или отправить на переиндексацию страницу, которую вы изменили, воспользуйтесь инструментом вебмастера Search Console.

Как ускорить индексацию страниц сайта в Гугле

1. В Google Search Console перейдите в раздел "Проверка URL".

2. Введите страницу, которую нужно проверить и отправить на переиндексацию.

3. Нажимайте на кнопку "Запросить индексирование".

Данный инструмент также подходит для проверки индексации страниц своего сайта.

Как закрыть сайт от индексации

Через файл robots.txt можно запретить индексацию страниц или всего сайта для конкретного поисковика или для всех сразу, используя директиву Disallow:

Если хотите закрыть конкретные разделы, укажите их:

Disallow: /news

Иногда Google игнорирует такой запрет, проверьте это через кабинет вебмастера. Если страницы все еще индексируются, переходите к следующему способу.

С помощью метатега Robots можно не дать роботам просканировать контент и закрыть текст от индексации. Для этого нужно в раздел <head> страницы добавить строку:

<noindex>[текст]</noindex>

Закрыть всю страницу от индексации можно, добавив строку

<meta name="robots" content="none"/>

Перед закрытием сайта от индексации желательно проверить методы в панелях вебмастеров.

Итоги

Если вы понимаете принцип индексации и для чего она нужна, вы легко сможете правильно настроить сайт для поисковиков. Корректно настройте в robots.txt и карту сайта, избавьтесь от технических ошибок и позаботьтесь о качественном контенте, чтобы поисковики высоко ценили ваш сайт.

Остались вопросы? Задавайте их в комментариях😀