- Работа с сайтом

- Фундаментальные этапы работы поисковой системы

- Краулинговый бюджет и спрос

- Индексация

- Что влияет на индексацию страницы?

- Как отслеживать индексацию

- XML карта сайта

- GSC - данные по запросам

- Пагинация и её цели

- Скорость загрузки сайта

- Внутренний вес страницы

- Изменение алгоритма Page Rank

- Выводы

- Структура сайта

- SILO

- SILO структура

- Перелинковка

- Как соединить блоки?

- Schema разметка на сайте

- Проведение SEO-тестов

- Выбор сегментов

- Продвинутый способ выбора сегмента

- Ответы на вопросы

У Игоря есть собственный сайт - DeepSEO.com.ua со статьями, подкастами и курсами по SEO. Если интересуетесь сферой, то советую заглянуть.

В этом вебинаре Игорь поделился своим опытом, показал приемы, инструменты и точки приложения силы, использование которых хорошо скажется на вашем сайте.

Я не рассказываю о сомнительных лайфхаках, кнопках «бабло» и т. д. К сожалению, в SEO они не работают. По своему опыту могу сказать, что 70% ваших усилий - рутинная работа по копанию, поиску и пониманию всего происходящего. Но тут надо знать, куда прикладывать усилия.

Доклад пройдет следующим образом: сначала я расскажу несколько простых моментов о работе поисковых систем. Эта информация иногда оказывается новостью даже для средних SEO-специалистов, поэтому стоит по ней пробежаться. Затем мы рассмотрим нечто уже более специализированное. Также вы узнаете, зачем нужна внутренняя оптимизация сайтов.

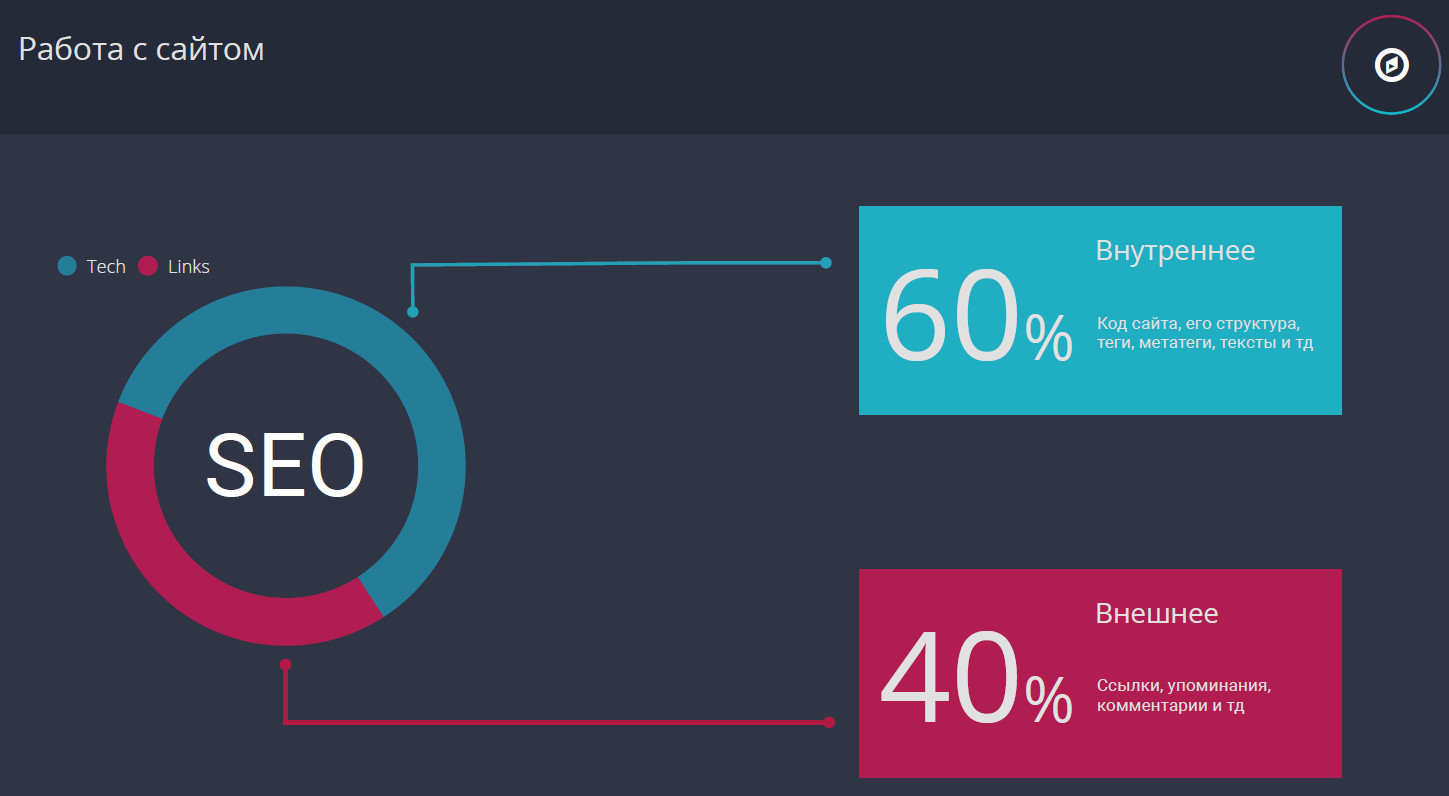

Работа с сайтом

При работе с большим сайтом 60% времени вы занимаетесь внутрянкой: оптимизацией кода, страниц, структуры и т. д. Остальные 40% вы тратите на построение ссылок. Говорить мы будем именно про эти 60%, про построение и увеличение ссылочной массы сайта.

Фундаментальные этапы работы поисковой системы

Следует понимать основные моменты взаимодействия Гугла с вашим сайтом.

- Краулинг. Здесь поисковая система парсит и скачивает ваши страницы.

- Индексация.

- Алгоритмы. Они учитывают множество важных факторов.

- Результаты. При поиске этого запроса вы будете видеть результаты выдачи.

На первых трех этапах могут возникнуть проблемы. Также они могут являться точками роста, с помощью которых вы сможете поднять свои позиции и получить больше трафика.

Поэтому рассмотрим каждый по отдельности.

Краулинг

Стоит помнить, что есть понятия краулер и краулинг.

Краулер - это парсер поисковой системы, собирающий информацию с сайтов.

Любой сеошный краулер (Netpeak Spider, Screaming Frog и т.д.) повторяет функционал гугловского краулера (Googlebot).

Краулинг - процесс сбора информации со страниц сайта.

Мы с вами не можем влиять на краулер. Запускать и отключать его на своем сайте по собственному желанию не получиться.

С краулингом же есть возможность работать. Мы можем внедрить на сайт некие фишки, что-то оптимизировать и т. д. Здесь уже кроются точки роста.

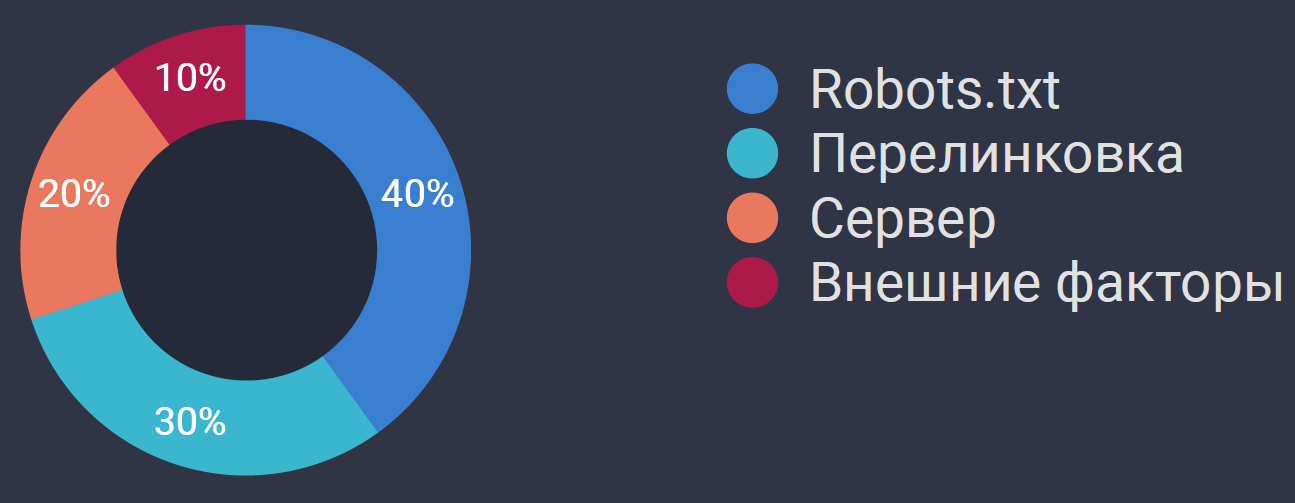

Что влияет на краулинг сайта?

На краулинг влияют:

-

robots.txt;

-

сервер;

-

внешние факторы.

![]() Как отслеживать краулинг?

Как отслеживать краулинг?

Для отслеживания краулинга смотрите за логами сервера. С их помощью вы поймете, как ведет себя Googlebot. Логи можно стримить в соответствующий инструмент (jetoctopus.com, Kibana) или скачивать себе на компьютер и анализировать самостоятельно.

Также мы можем косвенно смотреть на краулинг через Google Search Console. Здесь все быстро и удобно, но мало данных: парочка цифр, позволяющих оценить ситуацию на поверхности, не более.

В логах советую смотреть на такие моменты.

-

Динамку посещения ботом вашего сайта. Смотрите на то, когда бот посещал сайт, как часто он это делает, есть ли провалы в посещении. Постарайтесь определить причины пиков или провалов посещений. Помните, что при введении чего-то нового на сайте, Googlebot может менять свое поведение.

-

Ошибки сервера при сканировании. Это удобный и быстрый способ определить проблему уже сейчас. Смотрите на ошибки каждый день. Обычно этим занимается системный администратор. Если его нет, то придется делать это самому.

-

Время, требуемое боту для переобхода ваших страниц. Допустим, он зашел на страницу 1-го числа. Затем он посетил эту же страницу 15-го числа. Значит на переобход требуется 15 дней. У вас может быть своя усредненная цифра на весь сайт. Можете отдельно выяснить количество дней, требуемых на преобход, для разных типов страниц, категорий и т.д. Посмотрите, как и почему меняются эти цифры, сравните их. Стремиться нужно к наиболее быстрому переобходу.

-

Типы страниц, посещаемые и непосещаемые ботом.

-

Сколько страниц бот обошел и сколько их всего. Бот может не обходить весь сайт (на крупных он никогда это не делает). Эти показатели могут меняться после каких-либо изменений на сайте, имейте это в виду.

В GSC смотрите на старый и новый отчет по сканированию: количество страниц и скорость в первом, и сколько просканировано и какие ошибки во втором.

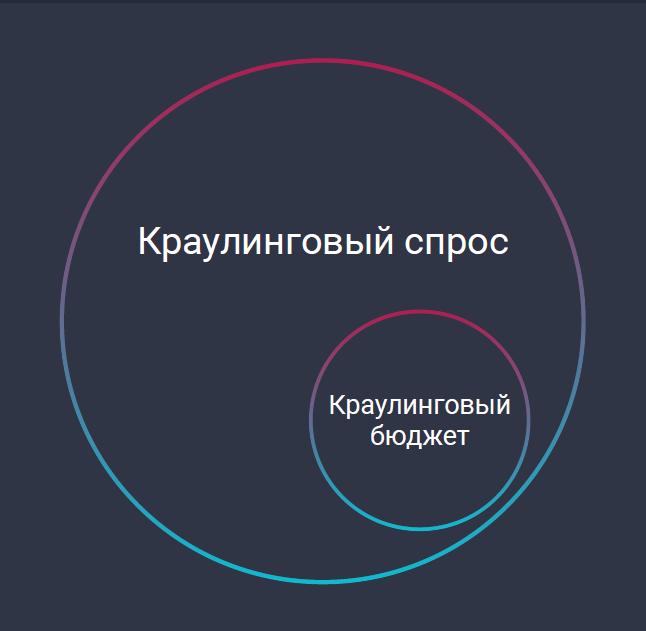

Краулинговый бюджет и спрос

О краулинговом бюджете говорят часто, но про краулинговый спрос вспоминают редко. Что это такое?

Допустим, есть сайт со 100 страницами. Краулинговый бюджет у него - 10 страниц за день. Столько Googlebot может обойти за сутки.

Краулинговый спрос - это то количество, которое он хотел обойти. Это может быть, например, 90 страниц.

Краулинговый бюджет надо постоянно увеличивать. Нужно, чтобы он максимально соответствовал спросу. Бюджет может быть низким по причине неправильной перелинковки, ошибок сервера, неправильной структуры, закрытых папок в Robots.txt и т. д.

При возникновении проблем с переобходом мы:

-

меняем перелинковку;

-

проверяем сервер. Смотрим на его скорость и ошибки;

-

обращаем внимание на дубликаты страниц;

-

анализируем качество контента;

Первые три пункта для нас приоритетны. Качество контента и внешние ссылки проверяем в последнюю очередь.

Краулинговый бюджет не является фактором ранжирования. Следует это помнить. Допустим, есть два одинаковых сайта на тысячу страниц. У первого краулинговый бюджет 10 страниц, у второго - 100. Казалось, у второго больше, значит он должен получить бонус от Гугла. И он получит его, но не из-за этого.

Краулинговый бюджет не является фактором ранжирования.

Преимущество ему даст то, что Googlebot прошелся по этим 100 страницам, проиндексировал их и теперь пользователи могут на них зайти. На первом же сайте таких страниц только 10.

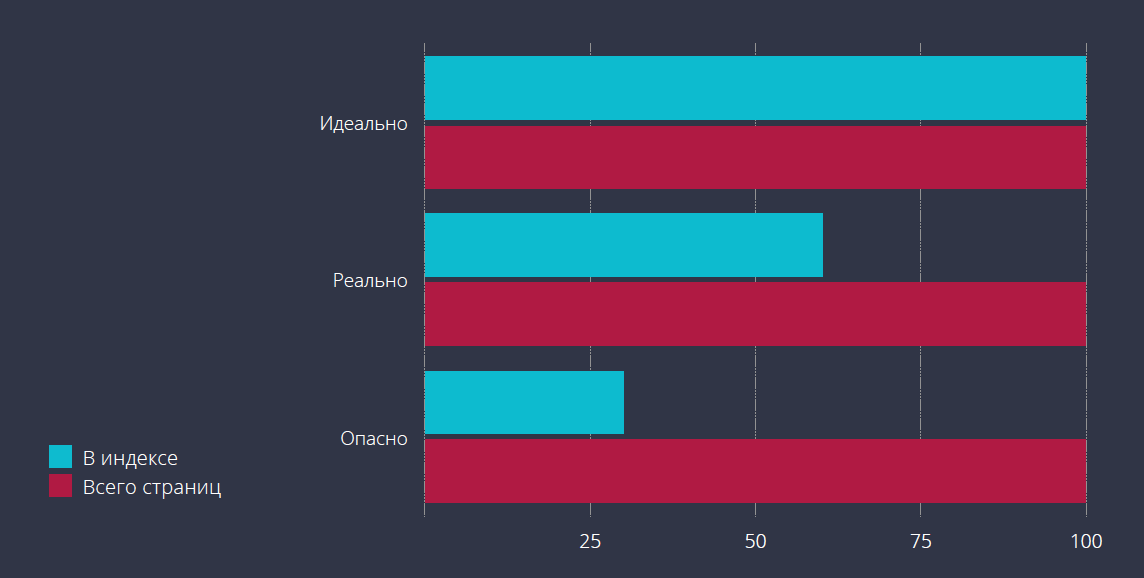

Индексация

Индексация - процесс анализа и добавления страниц сайта в индекс поисковой системы.

Всегда смотрите на то, сколько у вас страниц в индексе и сколько их всего.

Идеально, если они проиндексированы все. Такое встречается редко. Обычно 60-70% страниц в индексе - хороший результат.

Плохо, если проиндексировано только 20-30%. Это значит, что поисковик считает большинство ваших страниц некачественными и плохими для демонстрации пользователям. Проверьте их и исправьте все недочеты.

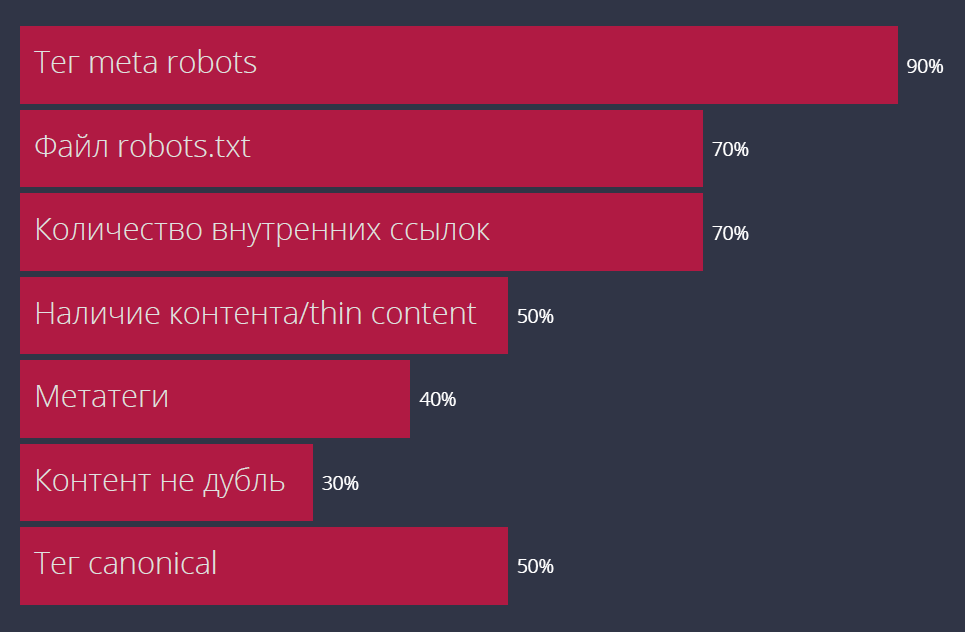

Что влияет на индексацию страницы?

На индексацию страницы влияют:

-

тег meta robots;

-

файлы robots.txt;

-

количество внутренних ссылок на страницу. Чем их меньше, тем меньше шанс на индексацию. Не ссылаясь на страницу, мы словно сами говорим поисковику о ее некачественности. Желательно иметь больше 10 внутренних ссылок;

-

наличие контента/thin content. Если контента мало или он некачественный, то шанс на индексацию невелик;

-

дубликаты;

-

тег canonical. Он немного выделяется, т.к. это тег для борьбы с дубликатами. Но на индексацию он влияет.

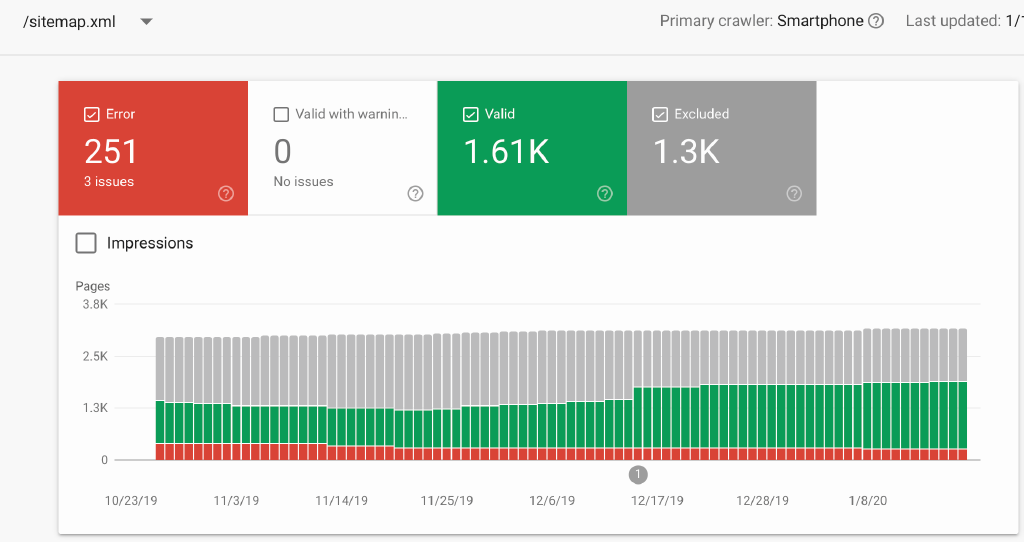

Как отслеживать индексацию

Любые команды в поисковую строку по типу site: не показывают реальную картину. Они годятся для проверки сайтов, к которым мы не имеем доступа по GSC (например, к конкурентам).

Можно в сторонних инструментах по типу Ahrefs, SemRush и т.д. посмотреть количество ранжируемых по какому-либо запросу страниц. Тоже способ.

Но самый лучший вариант - использовать Google Search Console. Здесь мы напрямую видим количество проиндексированных страниц. Данные сразу показываются с имеющимися ошибками и предупреждениями.

Записывайте себе полученные данные. Лучше всего составить таблицу. Это нужно, поскольку GSC информацию долго не хранит. Возможно, вам захочется сравнить индексацию сегодня и полгода назад. Но вы не сможете это сделать, если не сохранили данные.

Поэтому всегда записывайте в таблицу количество страниц в индексе, количество исключенных из индекса, дубликаты, важные ошибки. Делайте это раз в неделю. Много времени это не займет, но даст немало полезной информации.

XML карта сайта

XML карта сайта используется только для увеличения краулинга страниц. На индексацию она не влияет.

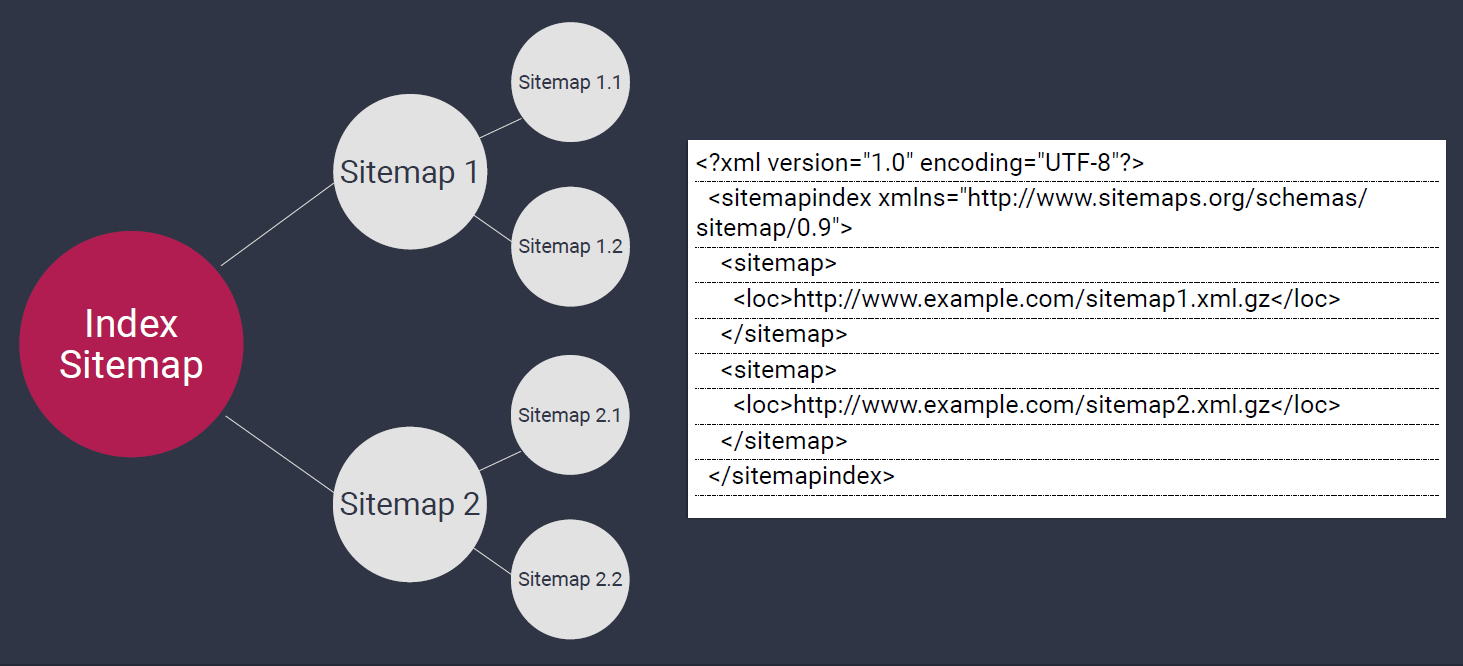

Index XML

Советую вам создавать индексные карты больших сайтов.

Эта карта выглядит как папка, в которую вложены карты сайта поменьше - тоже папки (в них можете вкладывать еще папки, создавая матрешку из карт сайта). Они содержат страницы определенного типа: товары, категории, товары из определенной категории и т. д.

Делите исходя из структуры вашего сайта. Сильно не перебарщивайте. У вас должно получится несколько логических кусков, с которыми будет удобно работать.

Карты позволяют проанализировать показатели индексации конкретного раздела сайта. У каждого из них свои данные, поэтому делите и анализируйте их по отдельности. Смотреть карты можно в GSC.

При анализе карт сайта задавайте себе следующие вопросы:

-

сколько страниц определенного типа попало в индекс? Почему это произошло? Чем попавшие страницы отличаются от не попавших?

-

какая категория сайта лучше краулится боттом? Почему это происходит?

-

каких ошибок при индексации больше всего и на каких страниц?

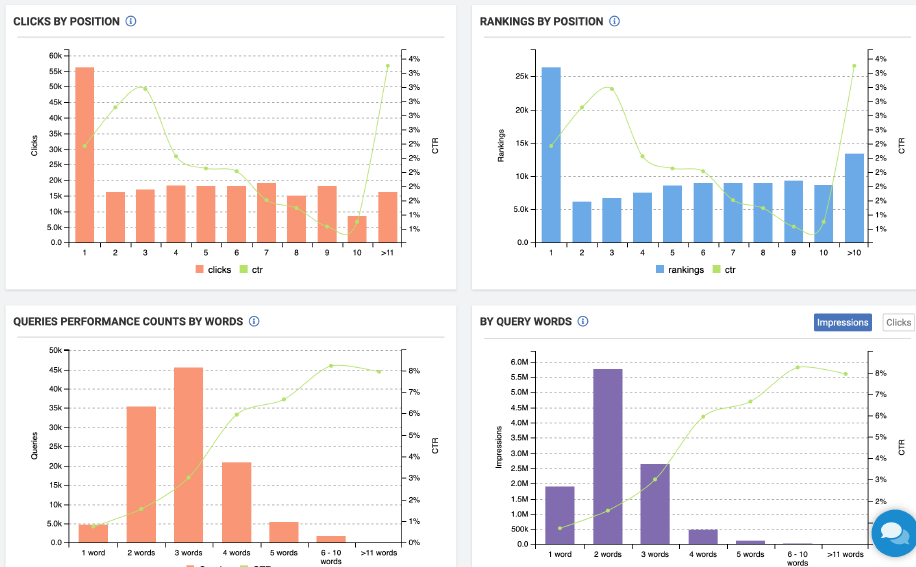

GSC - данные по запросам

Не советую смотреть на данные из GSC в формате интерфейса. Это не даст вам полной картины.

Используйте бесплатное дополнение для Google Таблиц. Оно позволит вам подключить Google Sheets к GSC и тянуть оттуда данные по API.

Если у вас больше тысячи страниц, то в интерфейсе GSC увидеть все данные не получится. С помощью же Google Sheets эта проблема решается.

Еще плюс. Эти данные вы затем сможете как угодно фильтровать, сохранять, делать сводные таблицы и т. д.

При анализе данных из GSC по страницам задавайте себе такие вопросы.

-

Ранжируются ли разные страницы по одному ключевому слово (каннибализация)? Плохо, если это так. Вы будете сами себя перебивать. Такое часто встречается на больших сайтах. Но нужно понимать, насколько это явно и является ли это действительно проблемой для важных страниц. Однако старайтесь все же избегать такой ситуации. Так вы сможете отфильтровать себе один запрос на разные страницы и посмотреть: насколько они друг друга перебивают, можно ли что-то исправить для избежания такой ситуации и т. д.

-

Какие разделы сайта/типы страниц получают больше кликов/выше позиции? Почему страница товаров одного типа ранжируется выше страницы товаров другого? Это реальный спрос или есть проблема?

-

Какова динамика для важных страниц? Конечно, вы можете отслеживать позиции по вашим запросам через любой удобный инструмент. Но вы можете следить за конкретными страницами, показами их в выдаче, кликами, средней позицией по данным GSC. Он всегда даст вам больше информации.

-

Какие ключи потеряли клики по сравнению с предыдущим периодом? В GSC вы также можете смотреть изменения кликов и показов по ключам. Плюс это всегда кладезь для новых ключей. Можете искать такие и внедрять в тексты или переоптимизировать их.

Можно, опять же, пулить эти данные в другие инструменты и строить там таблицы.

Например, в левом верхнем блоке показан график зависимости кликов от позиций для вашего сайта. Можете то же самое смотреть для отдельной категории.

В правом нижнем у нас деление по количеству слов в поисковом запросе. Показано, как меняется CTR, impression, клики в зависимости от количества слов.

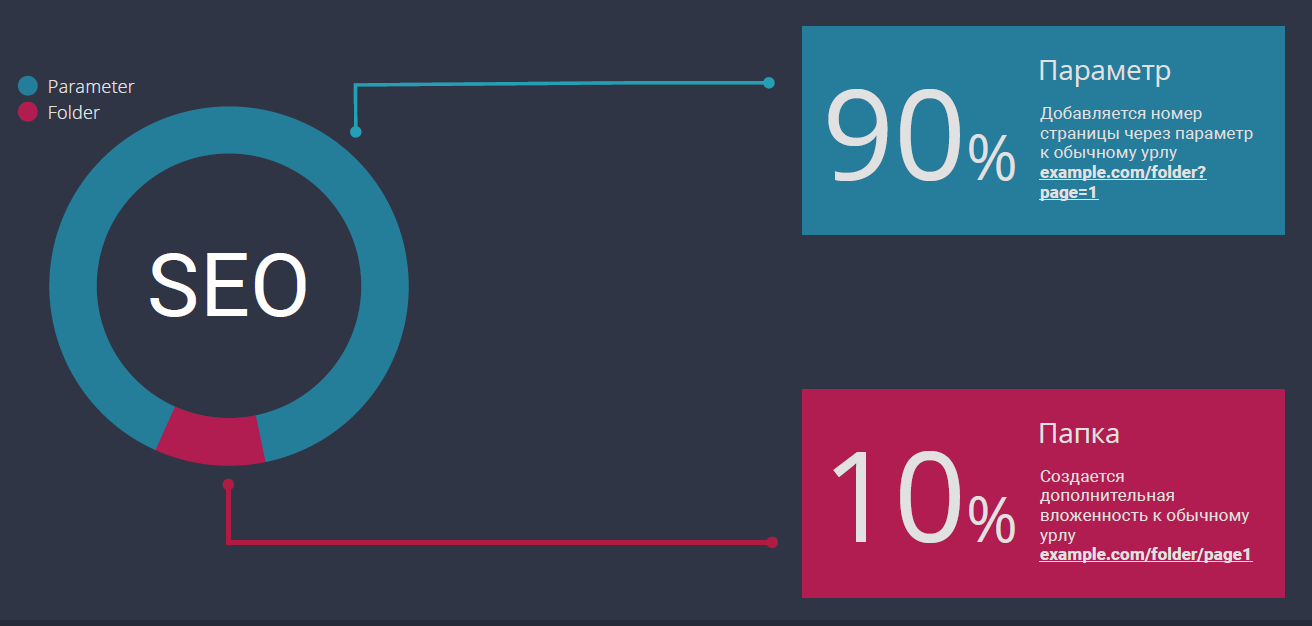

Пагинация и её цели

Сегодня она есть на всех больших сайтах. Хотя в будущем она явно отступит на второй план, поскольку пагинация все меньше влияет на краулинг и индексацию. Но пока что она все же это делает, поэтому надо обращать на нее внимание.

80% случаев пагинации - для пользователей, 20% - для индексации.

В 80% случаев мы делаем пагинацию для пользователей. Нам надо, чтобы увеличилась конверсия, люди скроллили, видели больше товаров или переходили по блокам/страницам.

Лишь в 20% случаев мы изначально делаем пагинацию для индексации.

В 90% случаев пагинация создается с помощью Parameter. Это правильно. Параметрические урлы удобнее обрабатывать, открывать и закрывать.

Пагинация в виде папки создает дополнительные проблемы.

Чтобы пагинация нормально работала уникализируйте мету даже если она закрыта от индексации.

Также в GSC URL parameters укажите, как поисковый бот должен обрабатывать параметры: краулить или не краулить какой-либо параметр, добавлять или не добавлять какие-нибудь страницы в индекс.

Не ставьте Canonical на пагинации. Вместе они работают плохо. Страницы пагинации будут ранжироваться, иногда даже перебивать основные страницы выдачи.

Canonical слабый тег. Он является не директивой, а рекомендацией для поискового бота, который не всегда его воспринимает.

Если нужно закрыть, то используйте robots noindex. Если открыть - ничего.

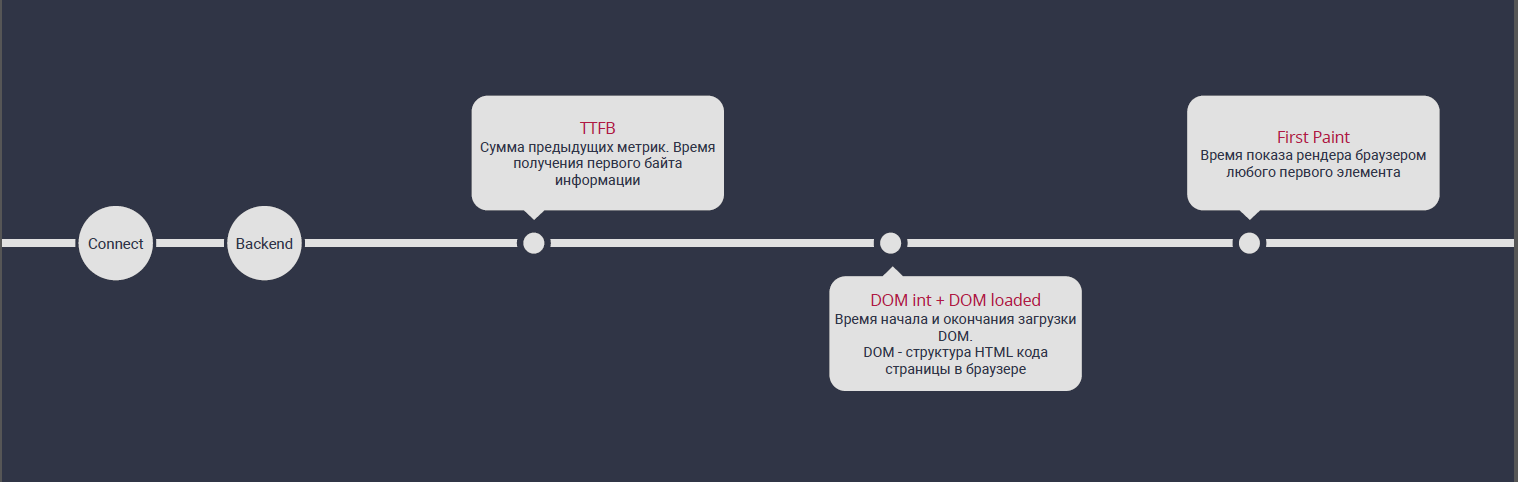

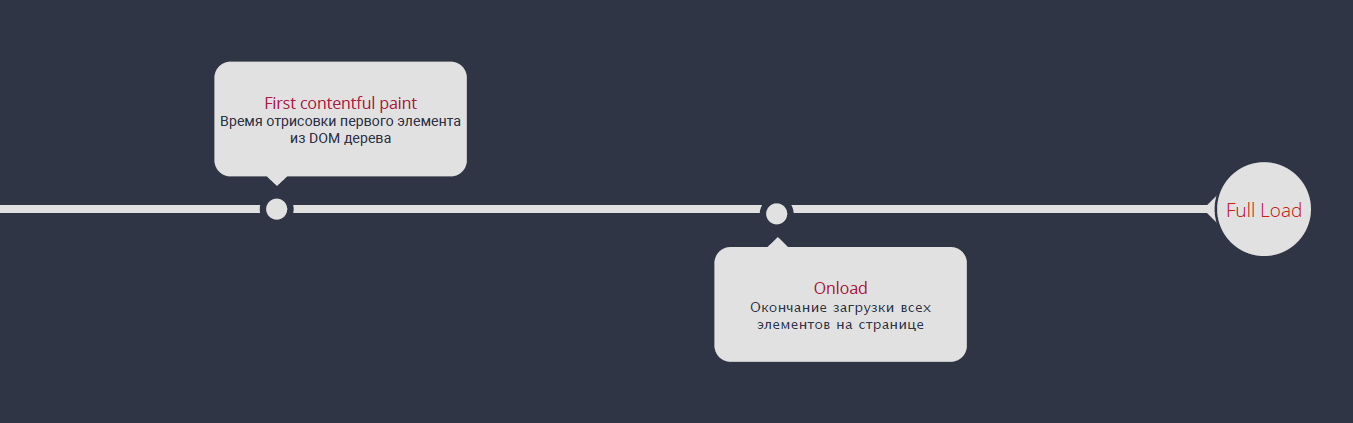

Скорость загрузки сайта

Вы должны знать все этапы при загрузки страницы. Они изображены на слайде. Каждый из них можно отдельно отслеживать, поскольку они влияют на ранжирование.

Реальная скорость загрузки != лабораторные данные.

Реальная скорость загрузки далеко не всегда равна «лабораторным» данным, которые вы отслеживайте через PageSpeed Insights, аудит в Lighthouse или другой инструмент.

Для составления более реальной картины скорости загрузки надо:

-

использовать внешние инструменты: GTmetrix и Pingdom;

-

в Google Chrome запустить Lighthouse аудит. Он все же хороший, не стоит им пренебрегать;

-

тестировать на максимально приближенном к пользователям сервере. Мобилку тестируйте на скорости 3G;

-

помнить, что не все метрики одинаково важны.

Метрики по важности

Отсортированы от самой до наименее важной. Оптимизацию скорости загрузки стоит проводить в таком порядке.

Внутренний вес страницы

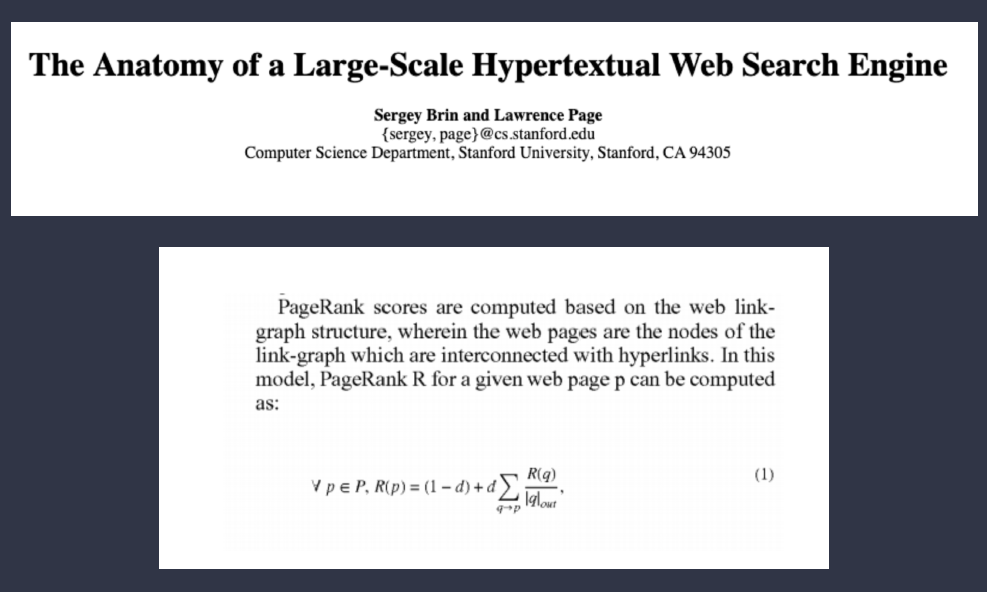

Pagerank (PR) - это число, означающее популярность страницы по сравнению с другими страницами в группе.

Многие до сих пор воспринимают его всерьез. Хотя, например, Toolbar PageRank в Гугле уже не существует. PR сейчас это скорее некое эфемерное число.

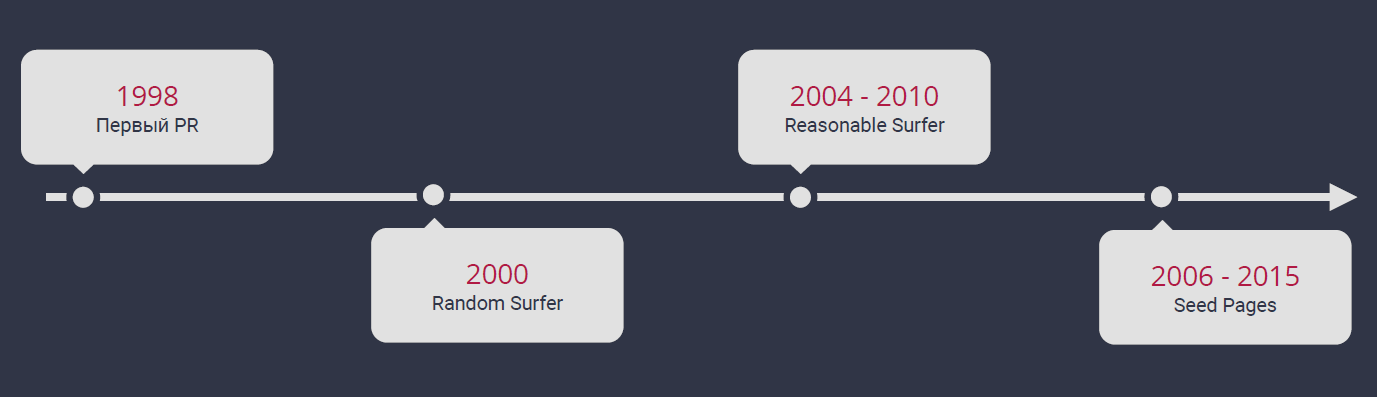

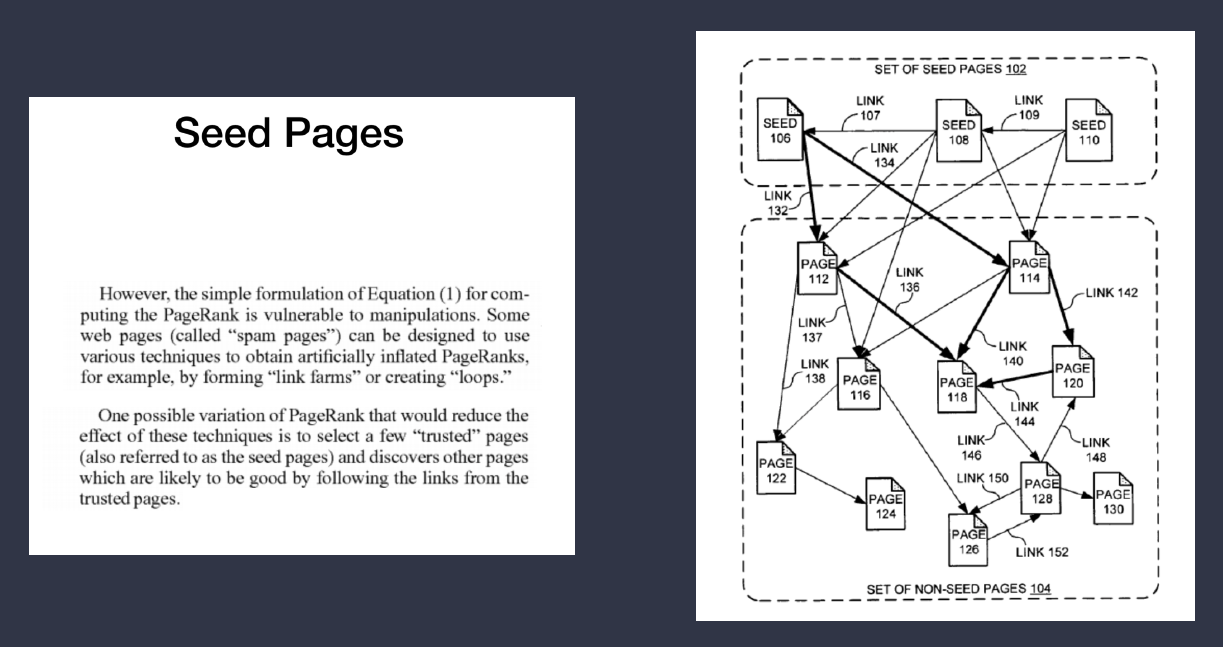

Изменение алгоритма Page Rank

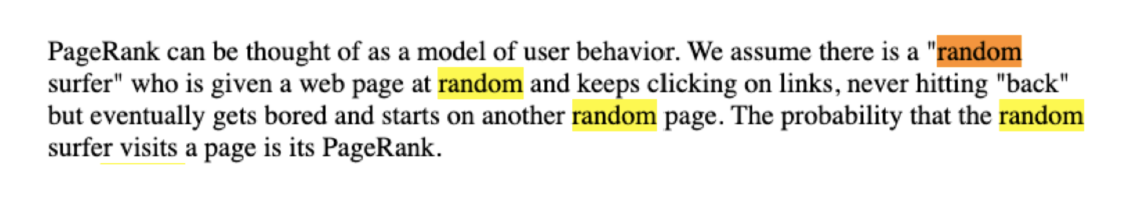

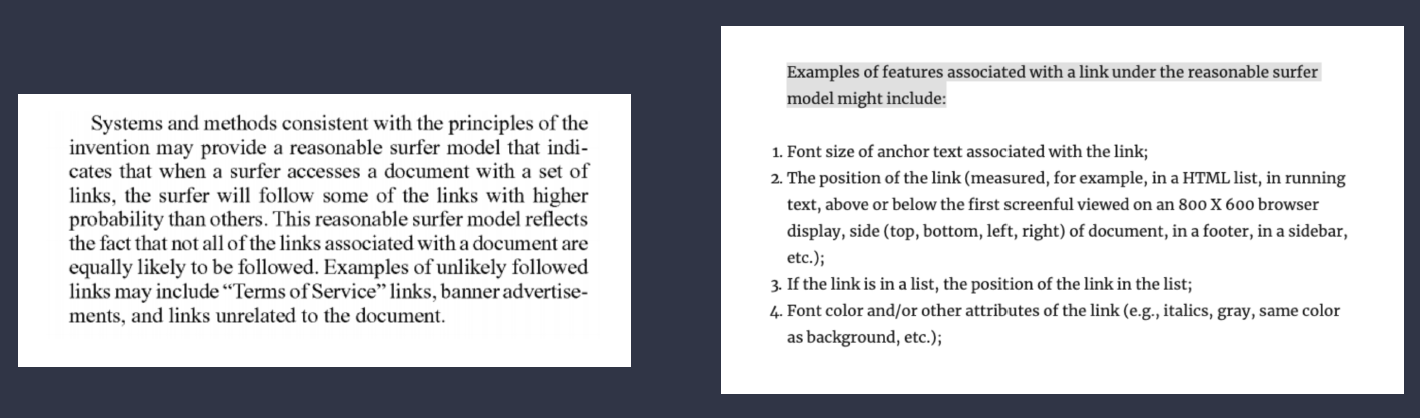

Алгоритм подсчета веса страницы постоянно менялся.

Когда-то мы могли утверждать о существовании некой формулы подсчета.

Но дальше это все усложнялось, Гугл разрабатывал новые алгоритмы, накладывал один на другой.

В итоге у нас получился хаос, в котором, как иногда говорят, не могут разобраться сами инженеры Гугла. Там уже подключено машинное обучение, искусственный интеллект обрабатывает огромное количество информации и под это нет единой формулы. Нельзя просто маркером написать что-то на доске и сказать: «Вот так считается PR». Существует много факторов и зависимостей, которые не уместить в одну формулу.

Выводы

Из всего этого можно сделать такие выводы:

-

точный внутренний вес посчитать невозможно;

-

мы можем использовать любые инструменты для его просчета. Но это будет лишь субъективной оценкой сервиса, не более;

-

можно обойтись подсчетом количества внутренних ссылок. Это будет приблизительно соответствовать внутреннему весу.

Структура сайта

Мы можем ей управлять и строить так, как нам захочется. Менять вы ее можете в любое время.

Структура сайта влияет на краулинг.

Хорошая структура означает хороший краулинг. А это повышает вероятность попадания страниц в индекс и получения трафика. Поэтому старайтесь ее улучшать.

SILO

Принцип SILO означает, что ваш сайт рассматривается не как сборище разноплановых страниц, навроде левой банки с перемешанными шариками.

Работает это так: все страницы сайта вы делите по типам. Затем связываете максимально тематические (на слайде это у нас банки с зелеными, желтыми и красными шариками). Большинство внутренних ссылок идут по таким, связанным между собой, страницам. Сами эти тематические кластеры и блоки также связаны, но минимально.

В итоге вы получаете нечто вроде правой банки, где все шарики отсортированы.

Каждая группа тематических страниц должна характеризоваться внутренней перелинковкой между страницами. Ссылки связывают эти страницы. Затем данные тематические сегменты складываются между собой.

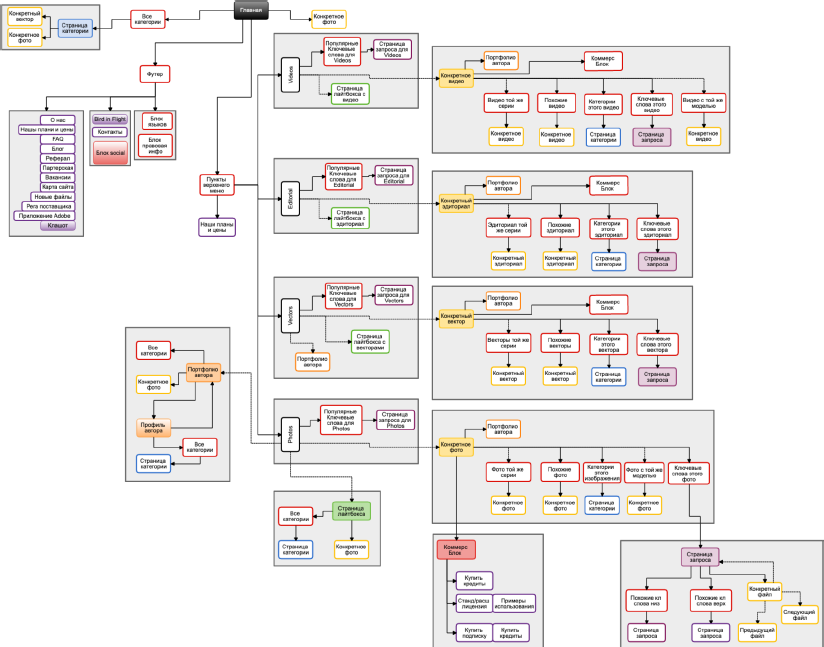

SILO структура

Рисуйте и анализируйте схему структуры вашего сайта. Смотрите, как у вас связаны страницы между собой. Находите и исправляйте проблемы.

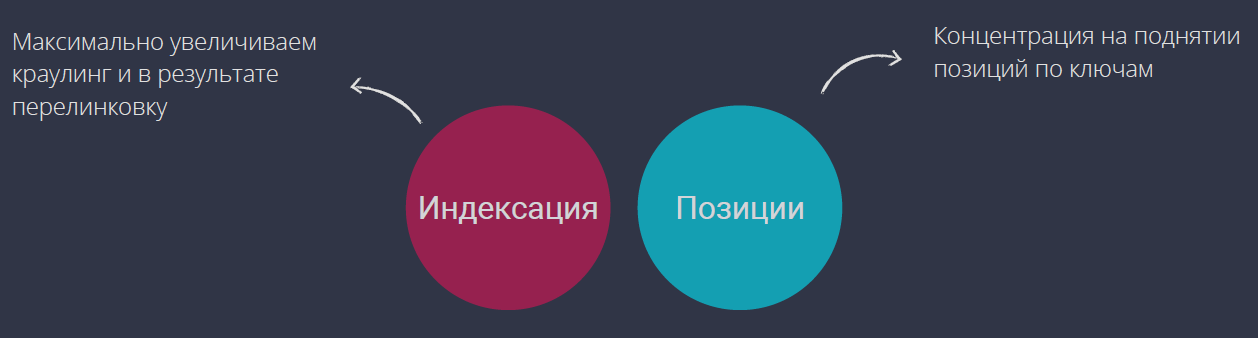

Перелинковка

Существует 2 вида перелинковок: направленная на индексацию и направленная на позиции. Они по-разному выглядят и размещаются в разных местах.

Если мы делаем перелинковку для индексации страниц, то:

-

делаем ее без повторяющихся ссылок;

-

ставим хотя бы одну ссылку на страницу, чтобы бот туда зашел;

-

нам не важно количество ссылок на странице. Просто поставьте футер и блочок. Он поможет боту попасть на давно забытые страницы и прокраулить их.

Если мы делаем блоки для позиций, то:

-

располагаем их в максимально видимой зоне контента: сайдбаре, тексте и т.д.;

-

смотрим на кликабельность ссылок;

-

обращаем внимание на анкор. Он здесь, как и в случае с внешними ссылками, имеет значение;

-

смотрим на количество ссылок. Помните, что это один из факторов внутреннего веса на странице. Количество внутренних ссылок влияет на популярность и позиции.

Ссылаться нужно с нижнего уровня на верхний. Например, на сайте у вас есть категории, подкатегории и товары. Товары здесь - самый нижний уровень, с него вы должны ссылаться на подкатегории, оттуда на категории и т. д. Таким образом верхние уровни получат больше веса.

Все эти уровни должны находится в одном SILO сегменте. В нем вы и строите ссылки.

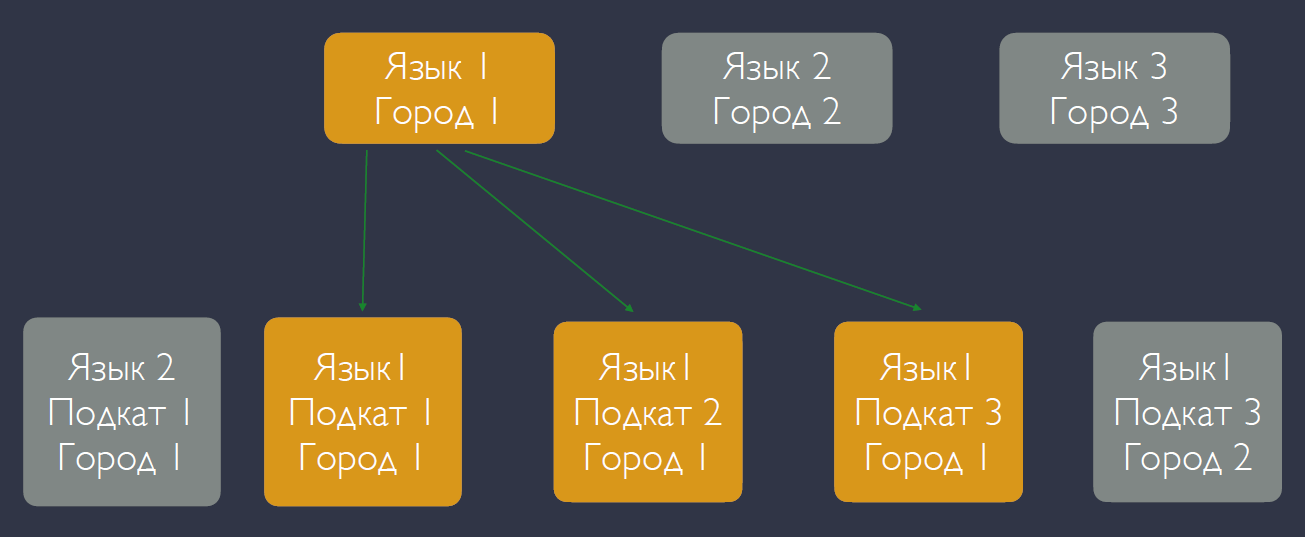

Как соединить блоки?

Если мы разделим наши страницы на тематические блоки, то, помня о SILO, ссылки надо строить как на слайде - между желтыми квадратами. Нижние уровни с Языком I и Городом I должны ссылаться на верхние уровни с Языком I и Городом I, поскольку это одна тематика. Для этого вам и нужно строить схему сайта.

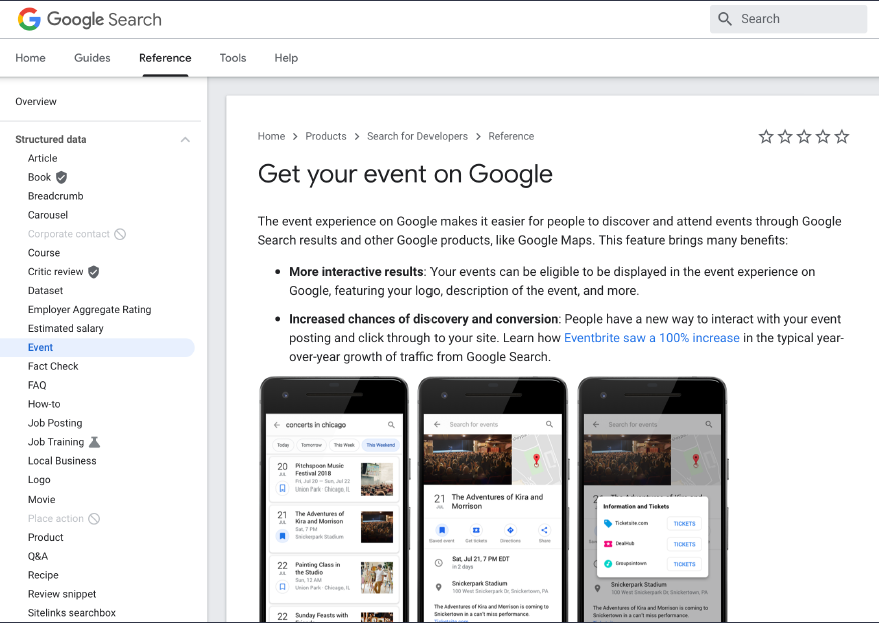

Поэтому делите ваш сайт на такие блоки и ищите тематическую связь между ними. Внимательно смотрите на типы страниц, которые вы связываете перелинковкой.

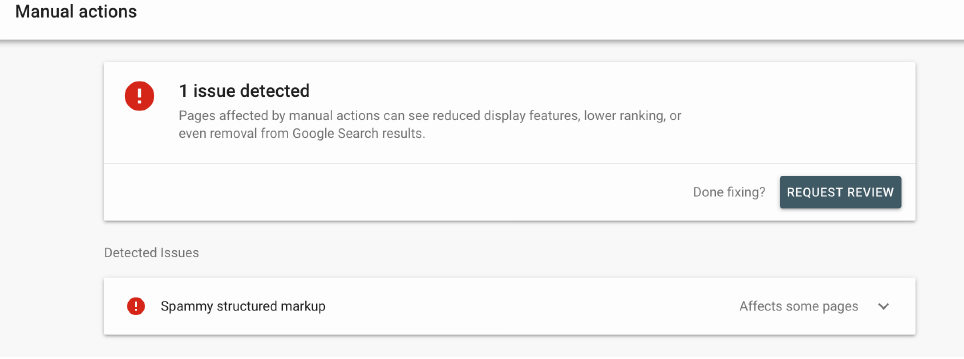

Schema разметка на сайте

Разметить можно хоть весь контент. Но в первую очередь лучше размечать все влияющее на сниппет вашего сайта в выдаче. Это даст буст в кликах и возможность получать больше трафика, что приведет к улучшению поведенческих и росту в позициях.

Помните, что есть санкции за разметку. Не пытайтесь обмануть поисковик. Не размечайте отсутствующий контент.

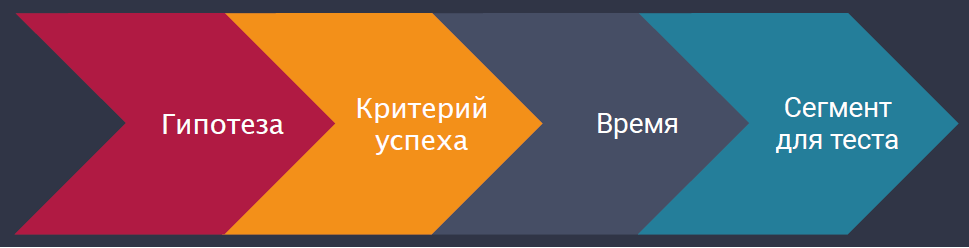

Проведение SEO-тестов

Всегда тестируйте новые идеи.

SEO-тест это не стандартный A/B тест, который мы используем при работе с конверсией. Поэтому те же инструменты нам не подойдут.

SEO-тест != A/B тест.

Зато подойдет такой алгоритм.

-

Мы формулируем гипотезу.

-

Определяем, что для нас является критерием успеха.

-

Прикидываем время, которое мы потратим на тест.

-

Выбираем сегмент страниц для теста.

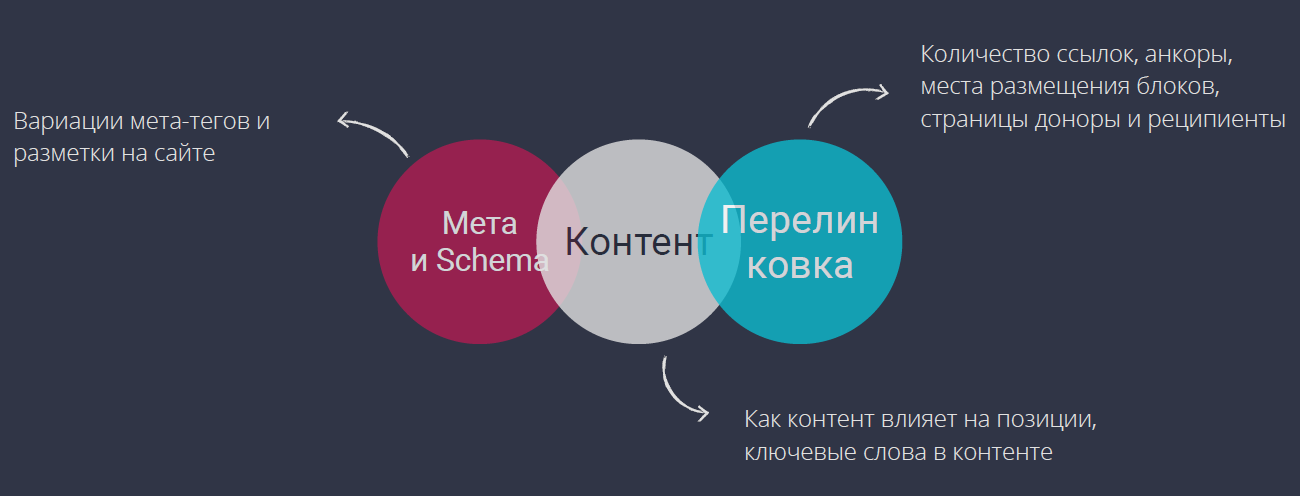

Тестируем в первую очередь:

-

мета элементы и Schema разметки;

-

контент;

-

перелинковку.

Выбор сегментов

Сегменты мы выбираем по:

-

маске урла. То есть мы что-то тестируем на урлах, которые отвечают определенной категории;

-

региональности;

-

типу контента;

-

позициям в топе. Для этого нужно выгружать данные из GSC;

-

среднему CTR. То есть делим на равноценные группы страницы исходя из их позиций в выдаче (нужно чтобы в каждой группе были страницы и с высокими, и с низкими позициями). Делаем на одной из групп тест и сравниваем результаты с другой.

Продвинутый способ выбора сегмента

Повторюсь:

-

данные можно собирать из GSC: клики, импрешены и типы страниц;

-

делим на группы, чтобы в них были страницы с одинаковыми показателями по всем метрикам;

-

данные можно собирать самостоятельно: брать программистов и делать свой инструмент или воспользоваться сторонним. Я рекомендую Distilled ODN.

Ответы на вопросы

Вопрос: Как найти условные дубли страниц на сайте, когда их контент, размещенный в основной части страницы, совпадает не на 100, а на 80-90%? Желательно бесплатно.

Ответ: Можно взять краулер и настроить там кастомную выгрузку по CSS или какому-нибудь тегу. Затем смотрите выгрузки и сравнивайте тексты между собой. Краулер часто показывает дубликаты контента.

Также можно воспользоваться сторонними инструментами, но краулить, я считаю, лучше.

Вопрос: Назовите топ-3 платного софта, без которого не может существовать крутое SEO.

Ответ: Мне нравится краулер JetOctopus. Он хорош на больших сайтах, где десктопного решения недостаточно.

Далее Ahrefs. Здесь можно хорошо следить за конкурентами и типами страниц в выдаче. Хоть это не напрямую связано с техническим SEO, но помогает понять, какие страницы нужно оптимизировать.

Третий платный назвать затрудняюсь. Все остальное бесплатное: SQL database, Excel (его и так все ломают). Если сайт у вас небольшой, то можете использовать Screaming Frog, Netpeak Spider (они платные).

Вопрос: Как можно разделить для поисковика страницы одинаковых товаров, если их отличие только в цвете или артикуле? Возможно ли это на большом проекте?

Ответ: Максимально уникализируйте метатеги. Добавляйте туда любые уникальные для товара параметры: цвет, размер и т. д.

На главных страницах товара можете писать уникальный текст. Можете сделать спин-текст и размножить его на эти страницы. Можете написать несколько заготовок текста с уникальными параметрами, которые будут внедряться в шаблоны. Затем эти шаблоны множить по товарным страницам. Это более правильный вариант.

Для примера можете посмотреть на интернет-магазины. Они живут с дубликатами. Многие товары там имеют одинаковые характеристики, но описаны они по-разному: таблицей, списком, добавлены инструкции, видео, отзывы и т. д. То есть дополнены контентом. Делайте так у себя.

Вопрос: Стоит ли использовать расширенный формат карты сайта с тегами, картинками, видео учитывая, что Гугл любит, а другие поисковики нет?

Ответ: Зависит от того, где вы хотите получить больше трафика. Также никто не запрещает создать отдельные карты для Гугла и других поисковиков.

Вопрос: Про влияние на краулинговый бюджет посредством robots. С перелинковкой понятно, а что с сервером? Брать ли для сайта отдельный сервер вместо общего? Я, как соло вебмастер, беру сервер shared hosting и минимально его настраиваю в соответствии с советами в сети или самого хостинга. Есть ли какие-то фишки? Влияет ли HTML карта сайта на краулинговый бюджет?

Ответ: HTML карта сайта уже давно ни на что нормально не влияет. Про сервер. Тут все зависит не от самого сервера, а от его скорости отдачи страниц поисковому роботу. Нет прямо крутых или плохих серверов. Поэтому тестируйте.

Размещайте ваш сайт как можно ближе к пользователям (если возможно). Если работаете на Москву, то размещайте в Москве, если на Киев, то размещайте в Киеве. Если не получается в Киеве, то разместите в Украине или в ближайшем к городу регионе соседних стран.

Платные сервера предлагают больше функционала и лучше работают. Поэтому на большой проект придется потратиться.

Вопрос: Что делать с 302 и 303 редиректами? Убирать полностью или переводить в 301? Пример: установила переадресацию одной страницы на другую, но в новостях осталась ссылка на старую страницу. Такие переадресации лучше убрать?

Ответ: Чем меньше редиректов, тем лучше. У вас могут быть внутренние ссылки, которые редиректят в другое место. Если вы можете от них избавиться, то сделайте это. Замените их на конечный URL, на который потом перейдет бот и пользователь.

Если хотите, чтобы бот помнил о переезде вашей страницы, то используйте 301. Только так все факторы ранжирования перейдут на новую страницу. 302 используется при временных переездах, лендинге и т. д. Читайте подробный гайд: Как правильно настроить 301 редирект, в котором описаны все возможные способы настройки перенаправления.

Вопрос: Мы с коллегами собираемся выкатывать интернет-магазин автозапчастей с большим количеством товаром. На часть из них мы прописали уникальные мета теги, но хотим выкатить на сайт весь ассортимент. При этом пользователям мы хотим показывать сразу все товары, а поисковикам только те, где заполнены мета теги. Как для бота лучше всего закрыть страницы с не прописанными мета тегами?

Ответ: Я бы не выкатывал все сразу. Если это все же необходимо, а вы можете закрыть эти товары через регулярное выражение в robots.txt или другим способом, то закрывайте.

Если вы не можете это сделать, то придется ставить тег robots noindex. Проблема этого решения в следующем: бот будет ходить по внутренним ссылкам и попадать на страницы с этим тегом. То есть краулинговый бюджет будет тратиться.

Вопрос: Есть новостной сайт. В последние пару недель возникла проблема: новости отдаются в Google News, но не попадают в выдачу. Попытки заново переиндексировать не увенчались успехом. Судя по логам, мобильный бот стал реже заходить на сайт. PageSpeed плохой, но у конкурентов еще хуже. За последнее время меняли только разметку хлебных крошек с json на микроданные. Могло ли это стать причиной? Если не это, то что?

Ответ: Замена на микроданные кажется странной, поскольку json лучше воспринимается Гуглом. Возможно, проблема действительно в этом. Хотя точно сказать нельзя. С Google News я не работал, поэтому здесь мне сложно что-то утверждать.

Касательно редких заходов бота на сайт. Не сравнивайте слишком часто себя с конкурентами. Оценка PageSpeed, например, в 20 маленькая, даже если она лучше, чем у конкурентов. Они могут выигрывать за счет других факторов. Обращайте на это внимание.

Неделю назад было обновление алгоритмов Гугла. Возможно, там есть что-то для вас. Почитайте.

Вопрос: Нужно ли закрывать пагинацию?

Ответ: Про пагинацию я рассказывал в докладе. Пересмотрите. Тут все зависит от сайта и ваших целей, которые вы хотите достигнуть с помощью пагинации.

Часто ее закрывают. На больших сайтах она остается открытой. Порой не полностью. Например, открыта только на первых пяти страницах.

Вопрос: Количество ссылок для внутренней перелинковки это какой порядок? 10, 100, 1000? Что значит мало хлебных крошек для крошек для категории?

Ответ: Про хлебные крошки. В докладе я говорил, что нужно ссылаться с нижнего на верхний уровень. Эту цель преследуют хлебные крошки. Этого недостаточно, потому что получается только одна ссылка на категорию/подкатегорию верхнего уровня.

Поэтому старайтесь ссылаться на другие категории из текста, характеристик и т. д.

Про количество. Вы должны смотреть на количество внутренних ссылок, идущих на какую-то страницу. Если она меньше 10, то это проблема. Нужно наращивать.

Идеально - 10 и больше на каждую страницу. Такое встречается редко, но стоит к этому стремиться. Можете начать с главных страниц, затем перейти на все остальные.

Вопрос: Что думаете о продвижении по городам с помощью поддоменов?

Ответ: Это нормально для некоторых поисковиков. В Гугле оно не работает.

Вопрос: Хотел бы узнать мнение по внутреннему весу страниц. В GSC есть блок - страницы, на которые чаще всего ссылаются. Есть ли смысл с этим работать?

Ответ: Этот отчет неплохо обновился за последнее время. Теперь он показывает более актуальные данные.

Но он считает не внутренний вес, а количество внутренних ссылок. То же самое вы можете посчитать прокраулив свой сайт. Так вы получите более точные данные.

Этому отчету я бы полностью не доверял. Но если нет краулера под рукой, то можете им пользоваться.

Вопрос: Может ли внутренняя перелинковка с анкорами быть опасной? Есть ли риск санкций со стороны Гугла?

Ответ: Нет. Даже если тысяча ссылок с одним анкором.

Вопрос: На текущий момент имеет ли защищенный протокол https существенное преимущество в ранжировании перед http? Может ли это быть причиной существенного спада видимости позиций?

Ответ: Насчет существенного влияния не знаю. Но это точно фактор ранжирования.

Вопрос: Как быстро Робот Новости передает инфу Googlebot? И общаются ли они вообще?

Ответ: Про скорость передачи не знаю. Я не работал с новостями.

Про общение ботов. Смотря что вы под этим подразумеваете. У Гугла есть несколько Googlebot, каждый из которых парсит что-то свое: кто-то картинки, кто-то видео, кто-то новости, кто-то страницы и т.д. Они собирают информацию и скидывают ее в единый «мешок».

Узнает ли поисковая система обо всей собранной разными ботами информации? Если вы это подразумеваете под общением, то да - узнает. Но прямой связи между самими ботами нет.

Вопрос: Крутить ли PF на пятнадцати страничном сайте услуг?

Ответ: Я таким не занимаюсь и не люблю. Где-то в какой-то момент это сработает, но долгосрочная перспектива не лучшая.

Все зависит от ваших целей. Если у вас проект на 2 месяца, то можете попробовать. Но если планируете долго существовать, то не советую.

Вопрос: Что обычно делаете с 404 страницами? Оставляете как есть?

Ответ: Да, оставляем. 404 страница - нормальная ситуация на сайте. Просто не ссылайтесь на них, если можете.

Вопрос: АМП улучшают индексацию?

Ответ: Не замечал.

Вопрос: Передается ли вес от донора через двойной редирект? То есть донор ссылается на страницу А, ее 301-м на страницу Б, С и т. д. Сработает ли передача веса?

Ответ: Я думаю, что сработает. Но нужно проводить исследования и тестировать.

Вопрос: Стоит ли разделять карточку на коммерческую (цена, купить, заказать) и информационную (описание, характеристики)?

Ответ: Не стоит.

Вопрос: Влияет ли на SEO атрибут lang? Правильно ru или ru_ru?

Ответ: Пожалуй, lang не влияет.

ru_ru - это страна и язык. Соответственно, вы себя ограничиваете себя одной страной, а информация с сайта может понадобиться и в других. Поэтому я бы не ставил такое ограничение, если это не слишком необходимо.

Но lagn точно должен быть правильным. Поставить на русском контенте lang_en - синтаксическая ошибка. А они влияют на сканирование ботом вашей страницы.

Вопрос: Где можно посмотреть краулинговый бюджет сайта?

Ответ: Нужно понимать, за какой период вы хотите знать: день, неделя, месяц.

Самый нормальный вариант - в GSC посмотреть старый отчет по количеству страниц, которые краулятся в день. Просмотрите так пару дней и выведите среднее значение.

Более точные данные можно получить в логах. Так вы увидите количество посещаемых ботом страниц.

Вопрос: Как быстрее всего скомпоновать несколько карт сайта?

Ответ: Я не пользуюсь онлайн-сервисами, потому что не один из них не переварит тысячи страниц.

Поэтому лучше воспользуйтесь каким-нибудь модулем, работающим с большим количеством страниц и формирующим карты сайта, если есть CMS. Просто поищите их.

Можете напрячь программиста, чтобы он сделал этот скрипт. Задача несложная. Он будет работать и постоянно обновляться. Сделать нужно так, чтобы скрипт работал сразу на весь сайт.

Как отслеживать краулинг?

Как отслеживать краулинг?