- Самый дорогой релаунч в моей практике

- О том, как я хотела подтолкнуть вверх, но уронила

- Как мы спустили 20к$ на эксперимент, который не дал результатов

- Антикейс: когда ошибки, совершенные не тобой, оказываются твоими ошибками

- Google убивает органический трафик своими же инструментами

- Не послушал SEO-специалиста — убил сайт за пару дней

- Антикейс. Как отпустить разработчиков в свободное плавание и получить -70% органики

- Как я убил бизнес по продаже бытовой техники

- 2 истории, после которых появляются свои правила

- Если ваши методы работают, то может не нужно на 100% доверять советам других?

- Антикейс: благими намерениями вымощена дорога в ад

- Ошибки начинающего специалиста

- Как из-за невнимательности можно удалить сайт из индекса Google на 3 дня

- Как промахнуться с PBN и чуть не уничтожить десяток сайтов, но успеть выжать максимум и выжить

- Антикейс по покупке ссылок или Никогда не покупайте их за свой счет!

- Про околонулевой сайт из-за некачественных ссылок

Любой неудачный опыт делает нас мудрее. А это уже повод о нем рассказать.

Поэтому мы попросили практикующих SEO-специалистов поделиться факапами из реальной жизни, которые стали хорошим опытом для них, и могут показать «проблемные точки» другим

У одних из-за своих же действий упал трафик и позиции, другие заказывали некачественные ссылки, кто-то забыл про редирект. В итоге — бюджеты сливались, а сроки нарушались 😥

Мы благодарны коллегам за активность. Читаем — и делаем выводы. Готовы учится на чужих ошибках?

Самый дорогой релаунч в моей практике

Релаунч сайта frankfurt.de, над которым работало несколько агентств и все работы стоили около 1.4€ млн.

После того, как органическая видимость стала сильно проседать, таки выяснилось, что подрядчики указали 302 редирект вместо 301.

Итог: https://www.frankfurt.de/.. находился в индексе и был лишь 302 перенаправлен на https://frankfurt.de, т.е на вариант без www. Эта версия отдавала 404 ошибку — так что чуда не случилось.

О том, как я хотела подтолкнуть вверх, но уронила

Это было в самом начале моей карьеры в 2009 году. До конца этапа выдвижения у проекта оставалась неделя. Запросы застряли на второй странице (12-15 места). Думаю, как их подтолкнуть, что еще сделать. Как раз пошел тренд на ЧПУ.

Переименовала все адреса. А про редиректы просто не знала)) Апдейт — а все позиции вниз. Страницы просто вылетели из индекса.

Не сразу поняла, что случилось. В итоге, редиректы настроили, позиции вернулись. Но гарантии по проекту выполнились на 3 недели позже срока. проблемные точки»

Как мы спустили 20к$ на эксперимент, который не дал результатов

Несколько лет назад был в моде метод продвижения от Шакина, который назывался «Удар шершня». Мы взялись его проверять, пробовать, дополнять и так увлеклись, что начали работать по нему на постоянной основе.

Целый год мы упорно ставили ссылки на свои же ссылки, в несколько уровней, в перехрест, на разные домены, на одинаковые домены, с поддоменов на поддомены и т.д. У нас были отдельные группы копирайтеров на разные уровни. Даже отдельные агентства, которые владеют пачками сайтов (50+ штук), уже знали, чего мы хотим и самостоятельно составляли нам план продвижения на следующий месяц по нашей методике.

Если говорить про саму методику без особых деталей, то она в основном выглядела примерно так: Мы брали 15-20 крупных сайтов с посещаемостью до 20 миллионов по SimilarWeb и на каждый из них ставили до 40 ссылок с сайтов попроще.

Загруженность была на 150%, работа кипела, ссылочный профиль наполнялся мощными ссылками. Но в какой-то момент мы решили, что для эксперимента, наверное, этого достаточно и вернулись к стандартной методике.

Поработав 3-4 месяца мы увидели те же показатели роста, те же графики с ключевыми показателями и тот же общий результат. Стало понятно, что эффективность обоих методов одинаковая (для нас). При этом нам уже не нужен был такой большой бюджет (мы смогли его уменьшить), значительно сократилось количество времени на организацию и закупку ссылок, а копирайтеры выдохнули с облегчением.

Это был наш самый большой и самый неудачный эксперимент.

Антикейс: когда ошибки, совершенные не тобой, оказываются твоими ошибками

У меня есть 2 истории, которые мне особенно запомнились.

На тот момент я была Head of SEO.

1 история:

К нам пришел сайт, который ранее нигде не продвигался. SEO-специалист сделал аудит, из которого было очевидно, что проблем с продвижением не возникнет. По анализу, уже после базовых работ сайт должен был выйти в ТОП (у него была не самая конкурентная тематика). После первых пары недель рост и правда пошел и достаточно стремительно.

Но потом все страницы резко выпали за ТОП 100. SEO-специалист перепробовал, как казалось, все, что мог, провел множество аудитов, проверил на все возможные фильтры поисковых систем, но проблему найти не удавалось.

Спустя несколько недель мучений и нарастающего отчаяния у всей команды я полезла в код сайта и обнаружила там скрипт, который должен был защищать от парсинга сайтов, а в итоге он запретил индексирование для поисковых систем. Данный скрипт добавил программист со стороны клиента из лучших побуждений и не сказал ничего нам об этом.

В данном случае ошибку допустил не кто-то один:

- Программисту следовало посоветоваться с нами или хотя бы сообщить о внедренном скрипте;

- SEO-специалист должен был смотреть на сайт как на новый при поиске ошибки;

- Я должна была направить SEO-специалиста в поиске ошибки.

2 история:

Продвигали сайт уже 2 года. У него постоянно рос трафик и конверсии, а позиции держались в ТОП 3-5. А потом резко сайт начал падать. Что привело к снижению трафика и потере клиентов.

Ошибку нашли достаточно быстро. Оказалось, что почти у всех страниц сайта появились дубли. Сложнее было найти причину и исправить ее. И вот тут мы зависли больше, чем на месяц. Ни SEO-отдел, ни программисты не могли найти причины появления дублей. За это время наши позиции уже оставляли желать лучшего, а трафик упал в 2 раза.

Но проблему все же удалось найти. Сайт был создан на CMS Joomla и там был установлен плагин, с помощью которого и создавалось большинство страниц. В какой-то момент Joomla самостоятельно обновилась и у всех страниц, созданных с помощью этого плагина, появились дубли.

Вывод: как бы вы не пытались все сделать идеально, есть сторонние факторы, которые могут привести к различным последствиям. Самое важное — скорректировать работу так, чтобы подобные проблемы больше не возникали.

Google убивает органический трафик своими же инструментами

В Google Search Console есть инструмент ручного удаления страниц из индекса. На нём и будет завязана моя история.

Пришел в компанию сайт на продвижение и при постановке задач мною были выявлены страницы «Для печати», которые генерировала ЦМС. Они имели отдельные урлы и прекрасно индексировались поиском.

Мы выпилили ссылки на этот функционал (он был и со слов заказчика не нужен), закрыли по маске эти страницы в robots.txt и я поставил задачу ручками удалить из индекса Google эти страницы.

На первый раз я сам не знал, что в Серч консоли тоже можно по маске удалить урлы и не мучиться с удалением каждого. Поэтому показал стажеру, как удалять урлы и он сел этим заниматься.

Приходит время отчёта и мы видим, что трафик по Google — 0. Хватаюсь за голову, но быстро нахожу решение проблемы: сайта вообще нет в индексе. Как же так вышло? А всё просто: стажёр не корректно ввёл урл в инструмент и система спросила «Удалить весь сайт из поиска Google?» Ну он на автомате, не читая, нажал «Да» и продолжил дальше делать свою задачу.

Я удивился, что из поиска Google в 1 нажатие можно просто «выпилить» весь сайт. Но больше такие задачи просто-так не давал другим.

Но самое смешное в том, что именно этот сайт попал под такую ошибку второй раз! И опять меня подвел человек, которому ставилась такая задача, но он уже был опытнее первого.

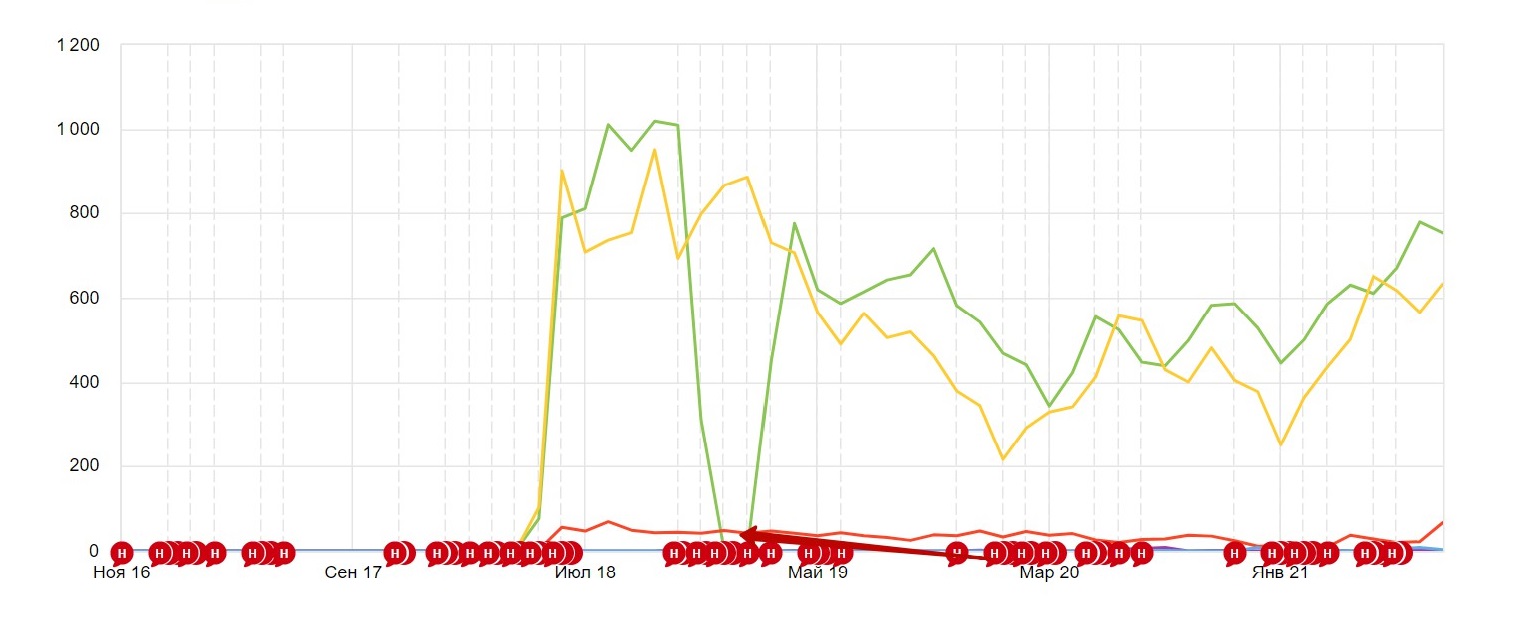

К сожалению метрика сохранилась не вся и есть факап только второго раза

Причём пару лет после этих манипуляций не удавалось нормально ранжировать сайт в Google. Но сейчас вроде всё хорошо и сайт ползёт вверх.

Не послушал SEO-специалиста — убил сайт за пару дней

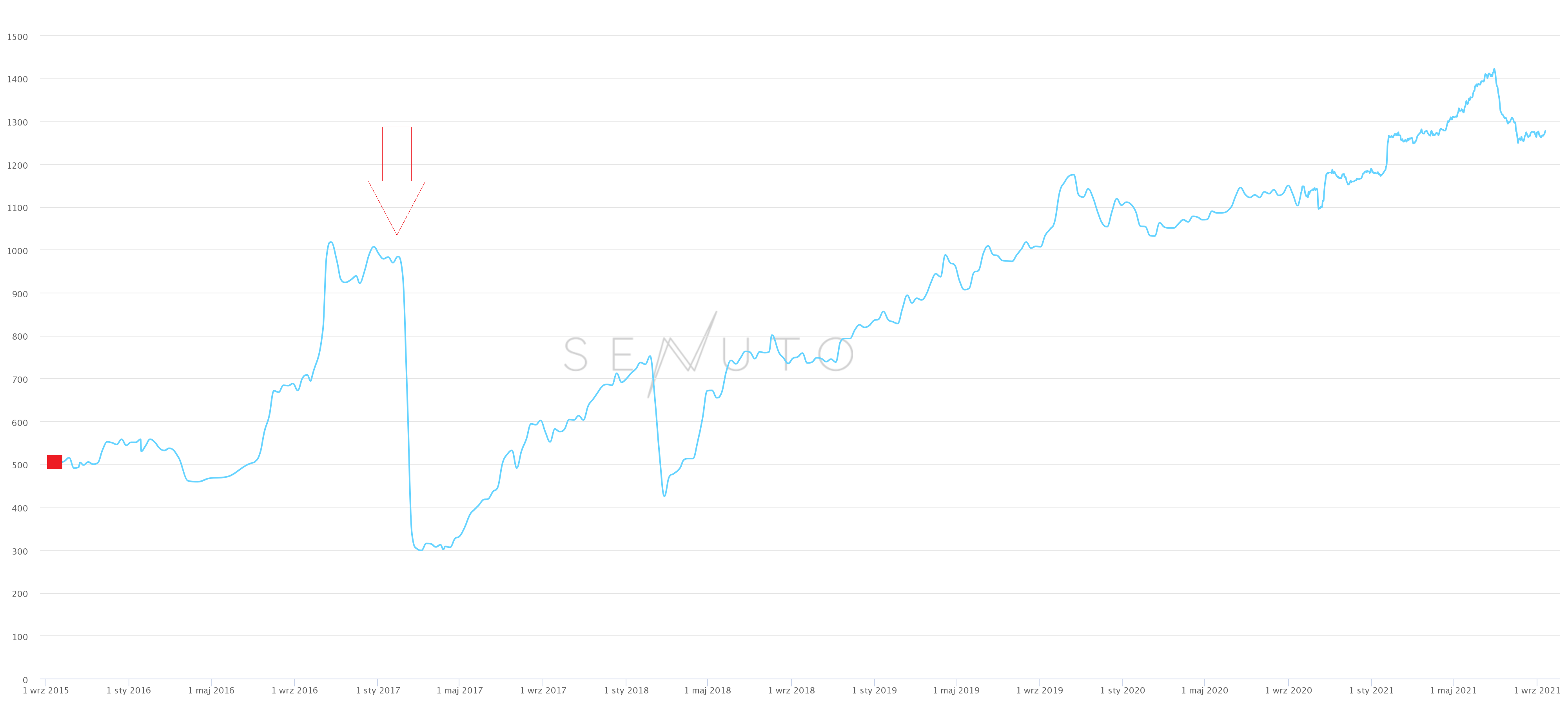

Это худший случай, который у меня был. На этом сайте все пошло не так: с редизайном, 301 редиректом со старого на новый, структурой URL-адресов и техническими моментами (например, результатами загрузки страницы).

Когда новый макет был готов, мы (отдел SEO) сообщили о проблеме с новой структурой URL-адресов. Это один из наиболее важных факторов генерации органического трафика, была замена динамическими отфильтрованными результатами. В этой конфигурации мы могли потерять статическую посадку. Более того, у нас не было места, куда мы могли бы перенаправить старые URL-адреса (только в одну из верхних категорий, чего было недостаточно).

Большинство рекомендаций SEO по конкретным страницам не были выполнены, а результаты по производительности и скорости загрузки страниц в то время были действительно низкими.

Из-за этой проблемы мы потратили много времени на встречи, написание электронных писем и попытки представить потенциальные убытки клиенту и агентству, которое выполнило редизайн. В конце концов, хотя агентство клялось, что все будет хорошо, но этого не произошло.

Чтобы исправить ошибки на сайте, клиенту пришлось снова заплатить другому агентству, и потребовалось 2 года, чтобы восстановить связанные ключевые слова и органический трафик.

Мы сообщили об ошибке на этапе макета в процессе редизайна, но из-за недостатка знаний (или других проблем, которые на сегодняшний день мне неясны), никто не услышал наше предложение (пока все не обрушилось).

Таким образом, сайт потерял 69% ключевых слов в топ-3 и половину органического трафика, а компания заплатила дважды за редизайн. Вдобавок команда SEO вместо работы над долгосрочной стратегией была сосредоточена на сокращении убытков.

Антикейс. Как отпустить разработчиков в свободное плавание и получить -70% органики

Когда-то разработчики по реквесту саппорта решили убрать с сайта тег H1, который автоматом генерировался из title с некоторыми ограничениями. Само собой, источник они тоже решили обрубить.

Узнал об этом спустя неделю (проект не текущий), когда несколько сайтов стали получать процентов на 70 меньше трафика.

Причем разработчики были уверены, что согласовывать это не нужно, т.к. h1 не касается seo, а значит и title, с которого он генерируются — тоже.

В итоге сошлись на чек-листе запуска всего, который надо было каждый раз проходить и малейшие нестыковки согласовывать дополнительно со мной.

Как я убил бизнес по продаже бытовой техники

Однажды, когда я несколько лет поработал SEO специалистом и имел существенные успехи с некоторыми проектами, ко мне обратился достаточно крупный интернет-магазин бытовой и встраиваемой техники. На сайте тогда было около 2500-3000 посетителей в сутки. Задача была увеличить трафик и мы начали постепенно успешно наращивать аудиторию и позиции сайта.

В какой-то момент уперлись в техническую составляющую. Все по классике. Программисты буквально не могли обслуживать сайт из-за низкого приоритета подобных задач. Тогда владельцем было принято решение изменить CMS сайта. Ирония истории была в том, что именно в тот период я опубликовал статью в блоге Как удержать позиции при смене CMS и был искренне рад, что изученный мною вопрос мгновенно можно будет применить в жизни.

В команде клиента появился маркетолог, который взял на себя процесс переноса. Было очень много согласований. И все тысячу раз перепроверял. Но в последний момент мне позвонил маркетолог и сказал:

— На нашем сайте сейчас 30 000 товаров, из которых только 7000 в наличии. Наш программист сказал, что надо удалить 23 000 позиций, чтобы все работало быстро и корректно.

— Нет, ни в коем случае. Для этого есть архивация товара. Вы не должны удалять страницы, вы потеряете трафик.

Через некоторое время:

— Михаил, мы окончательно решили удалить страницы. Это согласовано со всеми и нам нужно поменять схему редиректов так, чтобы минимизировать риски.

После длительных прений и убеждений меня в том, что владелец сам хочет удалить товары, я настроил редиректы c удаленных товаров на релевантные категории.

После выкатки трафик начал резко падать. Я сразу начал просить своего сеошника вернуть старый сайт, таким образом еще можно было вернуть позиции, как мне казалось. Но меня убедили что позиции вернуться, что наблюдаются положительные сигналы и т.д.

Итог. Было 2500 в сутки. Стало 250 в сутки. Начал звонить владелец. Ругаться. Я ему пересылаю переписку с маркетологом. Тот все отрицает. Виноват я и все. Не помню как разошлись. Полгода мы продвигали его бесплатно, довели до 500 в сутки, но новый программист существенно не был лучше старого и внедрялось все не очень хорошо.

В итоге клиент закрыл этот бизнес.

Через 5 лет я случайно встретил молодого парня на конференции. Мы приятно пообщались про его стартап и тут он говорит, а ты помнишь моего папу, ты продвигал ему сайт. Я побледнел. Так вот, у него новый бизнес, не хотел бы ты помочь ему с SEO? Я отказался. Я думал он шутит, но на вид так не казалось. Благо он понимал в SEO и разобрался в этой ситуации. Тем не менее сейчас в нашей компании если у клиента меняется CMS, мы очень сильно следим за этим. С тех пор у нас не было подобных случаев и мы даже научились менять CMS и сразу увеличивать трафик.

Но рубец, как говорится, остался.

2 истории, после которых появляются свои правила

Первая история произошла в моей практике давно, еще в расцвет ссылочного, т.е. в то время, когда для продвижения сайта в ТОП было достаточно закупить ссылок на SAPE.ru на продвигаемые запросы.

К нам пришел Заказчик, но не на продвижение, а на редизайн сайта.

Сайт был достаточно устаревший с точки зрения дизайна и со сложной замудренной навигацией. Не скажу, что это была наша прям ошибка-ошибка, но недосмотр – да: заказчик дал добро на «снести» все лишнее на наш взгляд, но не рассказал, что проект давно и успешно продвигается ссылками по всем скрытым от пользовательского взгляда страницам.

В процессе работы, мы сделали понятную дружественную пользователю структуру, убрали все лишнее, перенесли проект и... не прописали 301 редиректы со старых URL, которые в процессе исключили из структуры сайта.

Благодаря этому кейсу, появилось правило: ВСЕГДА 1) составлять карту текущих URL, 2) формировать на ее базе карту редиректов, 3) анализировать текущие методы продвижения проекта. И не важно, что сказал Заказчик :)

Вторая история произошла около 3-х лет назад.

Был в работе проект по SEO. Проект большой, сложный технически. Называть сферу напрямую не буду, просто скажу – финансы. По причине большого объема конфиденциальных данных, мы сотрудничали не напрямую, а в формате рекомендаций. То есть, мы со своей стороны готовили подробные ТЗ на внесение правок, начиная с написания рекомендаций по формированию URL, карты сайта и шаблонов META-, и заканчивая записью скринкастов по правкам в контент; инхаус специалисты должны были наши рекомендации внедрять.

Что мы вынесли из сотрудничества по такой схеме? «Сторонние сеошники» ВСЕГДА во всем виноваты. Даже не смотря на строгое соблюдение «сторонними сеошниками» дедлайнов по подготовке рекомендаций / ТЗ.

Мой совет всем, кто планирует работать по схеме: стороннее ТЗ — наши внедрения: строго прописывайте не только обязательства для тех, кто готовит ТЗ, но и для тех, кто их внедряет. В противном случае, результатов от SEO можно не ждать.

Если ваши методы работают, то может не нужно на 100% доверять советам других?

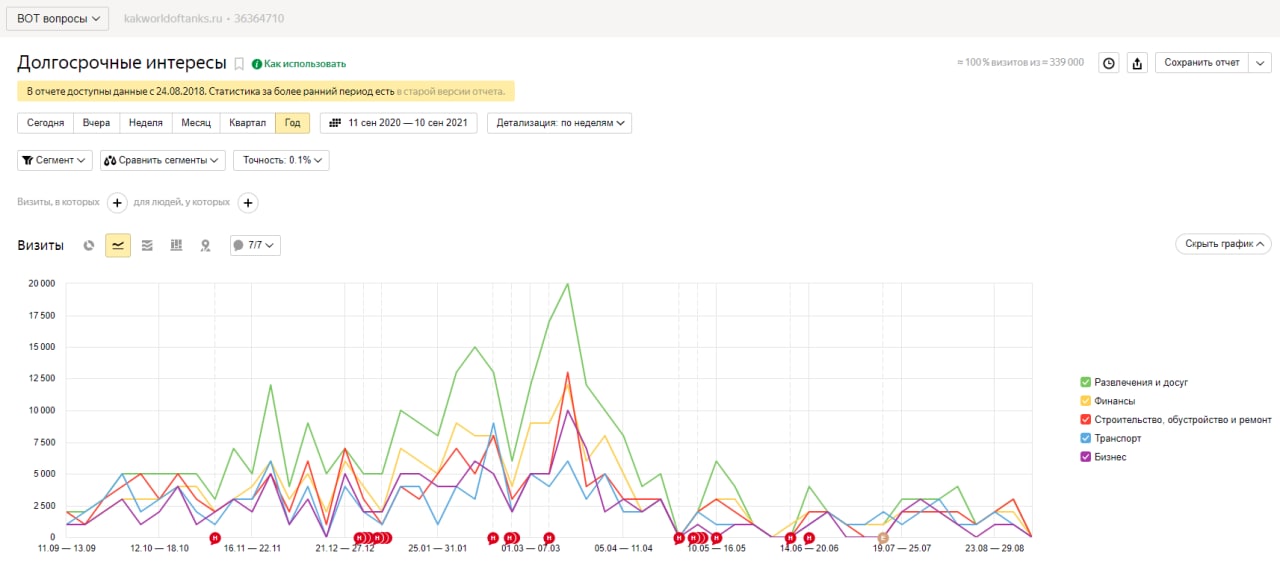

Я подписан на многие SEOшные каналы в телеге, в том числе, на самых крупных, типа Деваки или Шакина. Ну и начитался как-то, что, мол, сайты хуже ранжируются и вообще находятся глубоко в... пещере, если у них урлы смешанные, типа site.ru/статья-про-wordstat/ вместо каноничного единственно правильного и эталонного site.ru/statya-pro-wordstat.html.

Занялся я вопросом, послушав Гуру. Нашел плагин, который, вроде как, меняет урлы по шаблону и делает редиректы автоматически. Как думал я. Но нет. Установил плагин, натыкал нужные настройки, жмякнул «погнали» и... Получилась полная хрень (можно увидеть на скриншотах).

После переиндексации и просадки позиций, я увидел всю... глубину совершенного облома. Так как я не супер профессиональный SEOшник, я не делал бэкапы. Да и по основной работе были завалы и сайт некогда было восстанавливать. Плюс, как позже выяснил, еще и ссылки на картинки в статьях тоже побились и их тоже нужно было как-то переименовывать.

Спустя какое-то время добрался до работы над сайтом, спарсил как мог 404 урлы, сделал редиректы 301, переименовывал картинки. Ну, получилось что-то чуток получше, но все равно, изначальных результатов по трафику так и не вернул.

Потом руки как-то опустились (проект был флагманом), не публиковал новый контент месяца на 3, из партнерки, которая приносила основную прибыль, исключили (рекламодатель). Итог: вместо заработка 30к+ рублей ежемесячно и стабильно, проект стал приносить около 50 баксов (есть пара-тройка других партнерок и адсенс с РСЯ).

В общем, к чему это я? Вы, конечно, не отписывайтесь от супер пупер молодцов и красавцев, но если ВАШИ методы работают, то может и не нужно на 100% доверять советам других? Ну, и бэкапы делать не забывайте.

Проект пока не продан, что с ним делать дальше — не особо понимаю. Возможно кому-то нужен под гемблу какую или типа того? Цены шлите в личку 🤣

Антикейс: благими намерениями вымощена дорога в ад

Была эта история несколько лет назад. Зашел проект на продвижение. Это интернет-магазин, у которого уже были неплохие позиции и надо было просто дотянуть все до ТОП-1. На сайте была cms-система Bitrix. Если честно, не часто она у моих клиентов, но особых проблем я в этом не видела. Была также достаточно большая проблема с точки зрения распределения внутреннего веса — это жестко закрытая пагинация мета-тегом noindex, follow. Скажу честно: когда дело касается этого момента, то у SEO специалистов разных стран нет однозначного ответа, как делать правильно.

Ранее (2017-2018) у Google была четкая рекомендация по этому поводу. Но как раз в период этого кейса были внесены правки в алгоритм Google и все рекомендации по пагинации были убраны из справки работниками компании с идеей типа: «Наша поисковая система достаточно умная, что бы самой разобраться в этом вопросе». Я не знаю, появились ли эти рекомендации опять или нет, так как в последний раз, когда я искала, их так и не было.

Лично мое мнение по этом вопросу: если сайт продвигается в Google, я стараюсь открывать пагинацию для индексации, делаю автоматическую подстановку в начало Тайтла «Страница 2, Страница 3» и в конце Дискрипшина, чтобы релевантность этих страниц была ниже по запросам категории, убираю текст с этих страниц и только лишь показываю там товары. Я не использую канониклы на первую страницу, или закрытие от индексации, так как лично по моему опыту первый вариант решения непонятно влияет на распределение ссылочного веса внутри сайта, а второй оказывает негативное влияние на данный вопрос. В обоих случаях, на мой взгляд, для достижения аналогичных позиций надо влить больший бюджет в ссылочную.

Исходя из этого, было принято решение страницы открыть. Соответственное ТЗ было составлено программистам, и они его четко внедрили. Но вместо роста позиций пошел, наоборот, их откат по мере переиндексации. В Search Console ошибок не было, но позиции снижались по всему сайту целиком. Так, словно в индекс попадала куча мусора.

При сканировании сайта выяснилось, что у проекта глючит модуль, который формирует урлы у пагинации и он некорректно их формирует, в хаотическом порядке. Ранее такая проблема не наблюдалась при сканировании, и это в принципе было замечено. Программисты поправили и достаточно быстро.

Но падение позиций продолжалось, причем по некоторым запросам, где ранее ранжировались в ТОП10, категории товаров начали мелькать либо страницы пагинации на низких позициях, либо какие-то странные дубли страниц пагинации, либо вообще отдельные товары. На этом этапе мы обнаружили, что Битрикс генерирует массу дубликатов пагинации, которые не видны при сканировании. Не было понятно, где именно бот их нашел, но кроме выдачи эти дубли не были нигде более видны. Даже программисты не знали, где именно такое формируется. Это все отслеживалось и быстро закрывалось, но позиции продолжали падать. Так как сайт большой, то чтобы увидеть эффект, приходилось после каждой правки выждать примерно 1 месяц на переиндексацию большой доли сайта, чтобы увидеть, сработало решение или нет.

Через 3 месяца примерно мы поняли, что исправления не помогают. Было решено вместо открытия попробовать склеить всю пагинацию при помощи тега canonical на 1 страницу и так вернуть позиции, не прибегая к жесткому закрытию. Но увы и это решение не сработало. В большинстве случаев алгоритмы поисковой системы проигнорировали данную рекомендацию, и все равно продолжили держать все в индексе и хаотично ранжировать все страницы по запросам. В итоге через примерено 5–6 месяцев было решено вернуть noindex, follow на страницы пагинации, т.е. проект фактически оказался в начальной точке по данному вопросу. И это сработало. Проект начал возвращать позиции, если честно в разгар несезона для данной темы. Но возврат позиций все же шел, и к началу сезона (сентябрю) практически все позиции вернулись к моменту до правок. Вот так проект прошел по кругу и принес много интересного опыта и неожиданных результатов.

Ошибки начинающего специалиста

Был это год эдак 2013, когда я еще был довольно зеленым специалистом. И каким-то образом мне посчастливилось начать общаться с одним из клиентов, который желал, чтобы я оказал ему услуги по SEO-продвижению.

Клиент этот был из Польши. Общались мы на английском. Сайт продвигать нужно было тоже на англоязычные рынки. А опыта у меня на этих рынках было около 0,3. Но были амбиции и желание научиться.

Так вот. Тогда я еще не имел особого опыта работы с аутричем или даже покупкой ссылок у индусов. Все что я знал — это всяческие дешевые прогоны по каталогам и Web 2.0. блоги. И все эти способы построения ссылок я и применял для своего клиента.

Вот только загвоздка была в том, что сайт был в беттинг тематике. Конечно, в том далеком году конкуренция была еще не такая бешеная, как в наше время, но все же — это беттинг. Можете представить, какие бюджеты там были. И я со своими расходами на линкбилдинг в районе 50-100$ в месяц — это, мягко говоря, песчинка на просторах мироздания.

Понятное дело, что мне удалось показать рост только до 4-5 страницы выдаче и на этом наше сотрудничество закончилось.

Как из-за невнимательности можно удалить сайт из индекса Google на 3 дня

Суть антикейса в следующем. Проект Х — это огромный интернет-магазин, который имеет более 50 тыс. товаров. Продвигали по плану, сначала 6 месяцев, позже продолжили сотрудничество. Но в первые полгода работы имели очень стрессовую ситуацию. Суть ее в следующем.

Было изменение товарной группы: некоторые группы товаров уже не планировали продавать, их просто удалили (без редиректа, соответственно с индекса пользователи попадали на 404 стр.) Не было смысла прописывать много редиректов, ведь эти товары не продвигались и внешней оптимизации не было. Но в GSC было сообщение о большом кол-ве 404 страниц (около 500 шт.). И наш джун решил вручную подать на удаление из индекса в GSC каждую из 404 страниц. Но ошибочно (механическая ошибка) сбросил в удаление не полный адрес карточки товаров, а главную страницу.

Это была пятница и дальше было 3 выходных (суббота, воскресенье и государственный). Соответственно за 24 ч. из индекса пропала большая часть категорий и подкатегорий, вместе с главной страницей, которые собственно продвигались и генерировали много органического трафика. Повезло, что у меня есть ярая привычка в конце дня проверять в гугл аналитике результаты проектов (нет ли где заметного проседания).

Ну что ж ... увидела дома где-то в 21 час. Резкое проседание трафика в пятницу. Начали разбираться ... Сделали все возможное, чтобы вернуть эти страницы в индекс. Они вернулись, но только в воскресенье вечером. Клиент не заметил, ведь на выходных как правило, не было много продаж товаров. Но мы то знали, что совершили ошибку. Поэтому привычку проверять результаты аналитики проектов имею до сих пор, и до сих пор вечером. И всех прошу быть внимательными, потому что в SEO надо себя постоянно проверять).

Как промахнуться с PBN и чуть не уничтожить десяток сайтов, но успеть выжать максимум и выжить

В одной из IT-компаний я работала с несколькими десятками сайтов в конкурентной нише на запад. Решили сделать пбн-ки, чтобы усились позиции и ссылочный профиль основных сайтов. Почему — вручную проставить ссылки было нереально физически и долго.

Наполнили контентом сетку (контент уникальный из вебархива). Подождали индексацию, проставили ссылки анкорные. На некоторых пбн-ках ставили ссылки с «морды», на некоторых — с внутренних страниц. Через две недели начался рост, потом позиции по ключам резко повысились. Вроде бы все было ок.

Но через 1,5 месяца все упало, даже ниже уровня «до пбн». В результате большинство ссылок сняли (в этом плюс пбн: можно самому регулировать количество и качество ссылок быстро), привели сайты в божеский вид — нешаблонные темы, разные плагины и т.д.

Вывод: будьте аккуратны с сетками. Если в сетке 500 доменов, начните с 5-6 в неделю, подождите. Потом постепенно добавляйте контент и наращивайте ссылки с пбн-ок. Сейчас я мало использую сетки сайтов, предпочитаю хороший аутрич, крауд (куда без него) и рассылку пресс-релизов.

Crypto ad network Bitmedia.io →

Антикейс по покупке ссылок или Никогда не покупайте их за свой счет!

По форме google «кляуза на компанию» было удалено 2 сайта из поисковой выдачи — абсолютно и безвозвратно.

Суть состояла в том, что заказчик не рассчитался с копирайтерами за ссылки и за работу. В результате все данные со скринами были переданы в корпорацию Google и результат бана сайтов не заставил себя долго ждать. А именно, менее чем за 7 дней оба сайта навсегда были исключены из поисковой выдачи и единственный источник трафика для сайтов стали социальные медиа и тизерки.

Про околонулевой сайт из-за некачественных ссылок

Веду сайт, он в Google был около нулевой. Через год с опытом установил ahrefs и оказалось, что есть у сайта блог! Про него мне ничего не говорили, его вел другой сеошник до меня. Этот блог был взломан и с него шла куча ссылок на порно и геймбл! После удаления ссылок и закрытия этого блога отослали уведомления в Yandex и Google. Через 10 месяцев пошел рост сайта в Google!!!

Как-то так после снятия ссылок запрещённых с блога🤷♂

Вот такие истории нам удалось собрать. Надеемся, они станут полезными уроками для SEO-практиков.

Делитесь в комментариях, что думаете про описаные ситуации? Попадали в похожие? Или у вас есть свой антикейс?

А мы вам желаем, чтобы следующие опросы про антикейсы и жизненные факапы вы заполняли только так:

Это реальный ответ одного из наших респондентов 😂