- Зачем анализировать поисковую выдачу в 2021 году

- На что смотреть при анализе SERP

- Инструменты для поиска конкурентов по семантике

- Сбор семантики и определение основных конкурентов в нише

- Анализ ниши: ключевые параметры

- Выбор конкурентов для анализа контента

-

Выбор конкурентов для анализа ссылок

- Выгрузка всех ссылок из разных источников

- Разрезы первичного анализа в порядке убывания

- Определяем страницы в индексе поисковой системы

- doFollow/noFollow

- Тематичные/околотематичные доноры

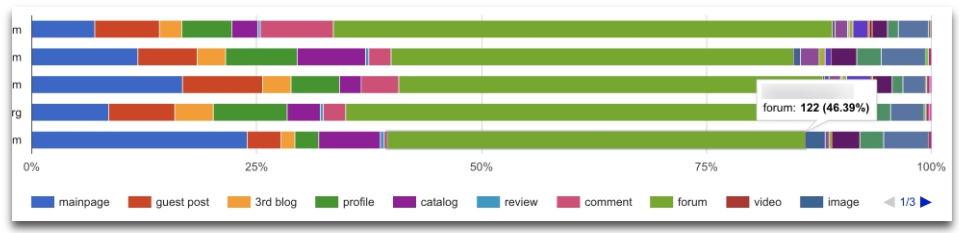

- Раздел сайта

- Типы ссылок

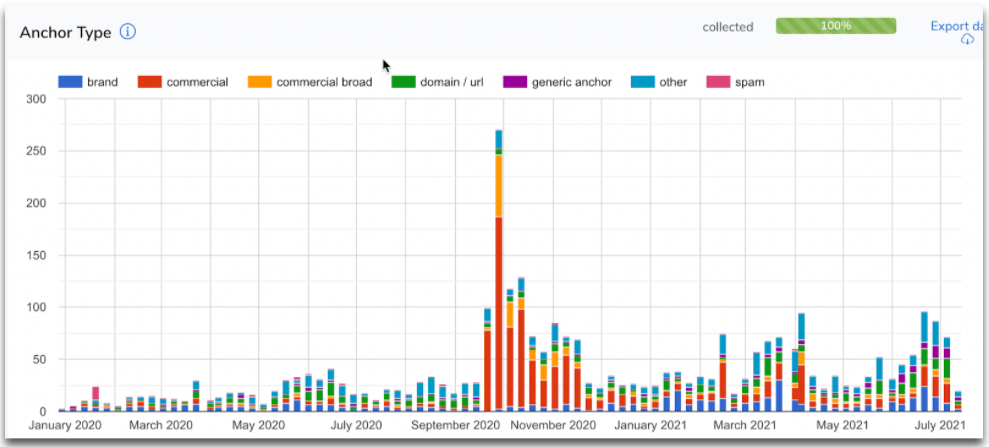

- Типы анкоров

- Качество площадок

- Комплексный подход при работе со ссылками

- Проверяем гипотезы на просевших конкурентах

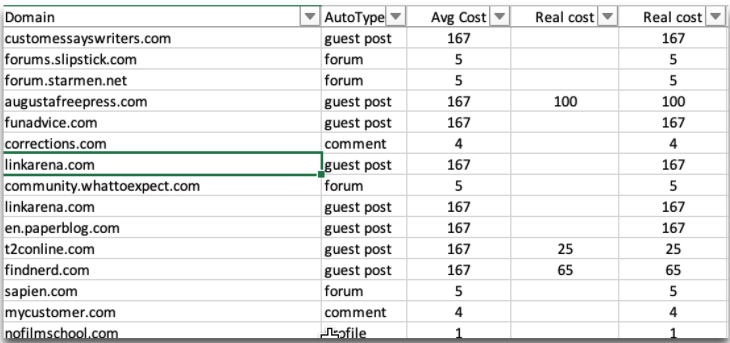

- Считаем ссылочный бюджет

- Сессия вопрос-ответ

Антон Рева — SEO-специалист с большим опытом, начинал свою деятельность на заре Интернета. За это время он работал с большим количеством клиентских сайтов. Сегодня основные его ниши — это Education и Affiliates sites, которые стремительно растут.

Зачем анализировать поисковую выдачу в 2021 году

На наших сайтах мы стабильно показываем динамику, позитивный рост. Одна из причин — постоянный анализ в условиях ограниченного бюджета. Не потому что денег нет, а потому что стремимся оптимизировать бюджеты свои и клиентов. Поэтому важно постоянно делать анализ поисковой выдачи.

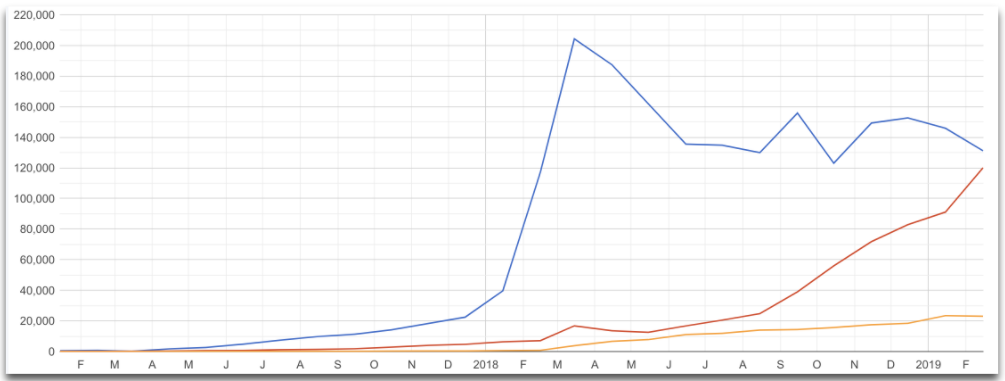

Ниже — стандартный скрин нашей работы. Красная линия — это один из Affiliates сайтов, который в конкурентной нише мы смогли продвинуть за минимальный бюджет благодаря анализу и различным подходам.

Перед любым анализом нужно четко понимать, зачем вы его делаете. Это понимание в дальнейшем дает вам возможность:

- фокусироваться на нужных конкурентах,

- выбирать нужные метрики,

- делать в итоге правильные и нужные выводы.

При заходе в нишу мы анализируем поисковую выдачу, нужные ресурсы, конкуренцию, сложность и т.д. Мы можем искать сайты с большой структурой и на основе ресурсов конкурентов дополнять нашу структуру. Это с точки зрения контента. Когда мы сделали сайт и нормально наполнили его контентом, то следующая задача уходит на продуктолога. Здесь мы должны привести сайт в один из лучших видов для того чтобы удовлетворить потребительский спрос. То есть смотрим фишки у конкурентов и т.д.

Последнее из главного это ссылки. Нужно для каждой ниши смотреть текущую ситуацию. И на основе этого адаптировать стратегию под эту нишу и под нюансы, которые в ней есть.

На что смотреть при анализе SERP

При анализе SERP в нише смотрим в первую очередь:

- Лидеров в каждом из разрезов.

- Схожие проекты.

- Растущие проекты, запущенные недавно.

- Проекты, которые просели.

При анализе лидеров желательно смотреть проекты, которые более-менее по параметрам схожи. Это может быть возраст, количество ссылок и под. Работающие на ваш взгляд фишки вы сможете внедрить на своем сайте.

Если мы берем контент, продуктовую историю или ссылки, то по классике при анализе поисковой выдачи желательно смотреть растущие сайты, которые недавно запущены.

Когда вы сделаете какие-то выводы на основе растущих сайтов и в целом по нише, нужно просмотреть те проекты, которые просели. Так идеи проверяются на работоспособность. Например, есть понимание, что крауда в этой нише не надо, а продвигаться нужно гостевыми постами, только хорошими ссылками. Вы смотрите проекты, которые просели, и видите, что тот же крауд в нише не работает. Соответственно те проекты, которые были на крауде, .улетели.

Инструменты для поиска конкурентов по семантике

Очевидный шаг — использование сервисов для поиска сайтов-конкурентов :

- Ahrefs,

- Semrush,

- Similarweb,

- Serpstat,

- SpyFu,

- QuickSprout,

- Alexa,

- Megaindex,

- Cognetive SEO,

- iSpionage.

Читайте гайд на Collaborator о том, как анализировать сайты конкурентов, какие сервисы использовать, как выстроить стратегию продвижения на основе полученных данных.

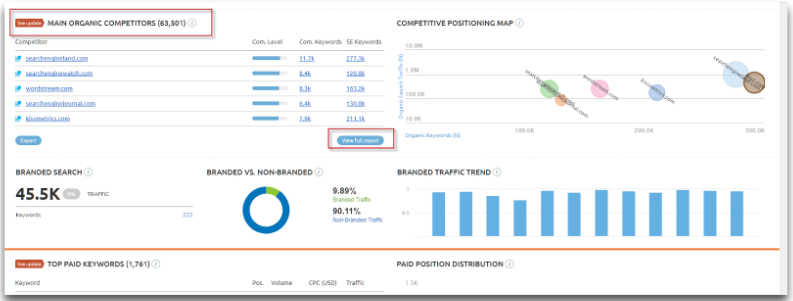

Мы в своей практике в основном пользуемся Ahrefs, Semrush, Similarweb. Это основа нашей работы. Периодически дополняем эти сервисы Serpstat для поиска дополнительных ключей.

Можно банально взять ключи, которые вам понятны (высоко-, средне-, низкочастотные), и собрать список конкурентов. Но такой список конкурентов будет недостаточно репрезентативным, и какие-то нюансы вы можете упустить.

Поэтому я всегда настаиваю на собственной семантике, которую можно достаточно быстро собрать (1-2 часа). Фактически это равнозначно тому, что вы будете руками вбивать в Google 20 запросов и смотреть. За это же время вы можете собрать огромное количество семантики, чуть-чуть почистить и получить почти максимальный срез по нише. Кроме этого, вы сможете сразу получить долю по конкурентам, если у вас есть своя семантика, а не какие-то общие данные по сервисам.

Почему собственная семантика лучше,чем собранная по сервисам:

- Максимально детальный анализ именно того, что нужно.

- Своя доля рынка по конкурентам, а не общие данные сервисов.

- В любом случае пригодится при создании лендинга.

Важно помнить, что коммерческая семантика приносит на порядок больше денег, чем информационная. Но по информационным запросам частота всегда значительно больше. Соответственно по ключам все сервисы трафика показывают больше.

Например, один конкурент может легко иметь кучу трафика по Ahrefs, а другой — в 5-10 раз меньше. Но в выдаче у него будет преобладать коммерческая семантика. Прогнозируемо, что во втором случае профит будет выше.

Это нужно понимать и с помощью своей семантики регулировать.

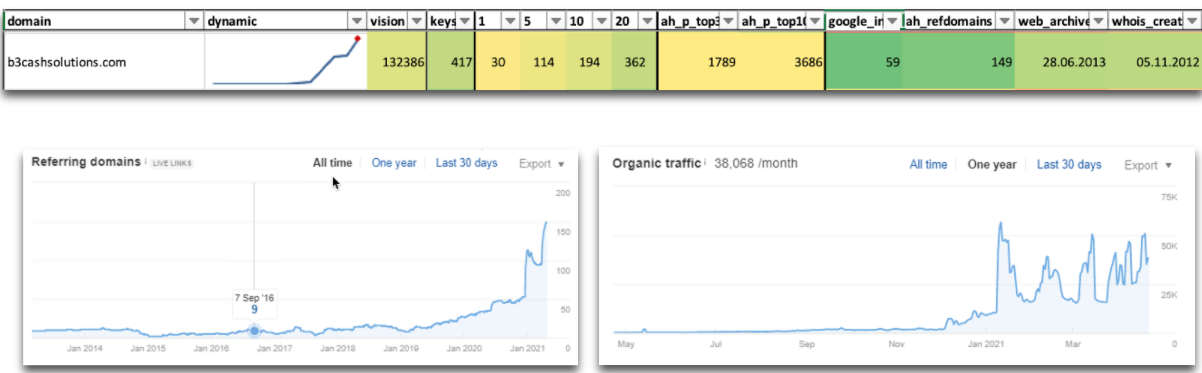

На скрине ниже — кейс, который показывает результат тщательного анализа ниши. Мы собрали семантику, все четко проанализировали. Этим проектом уже почти не занимаемся, но дохода на 1000+, вычитая затраты.

Сбор семантики и определение основных конкурентов в нише

Примерный алгоритм сбора семантики:

- просмотр выдачи и конкурентов по сервисам аналитики,

- определение высокочастотных, среднечастотных или низкочастотных запросов,

- с помощью Ahrefs выгрузка органических ключей. Желательно здесь выгружать не всю семантику, а топ-10 или топ-20 по выдаче. Так отсекается хвост не очень релевантных ключей, которые вам на текущем этапе не сильно нужны. Таким образом, если дальше вы возьмете 5-7-10 конкурентов по топ-10 или топ-20, то вы реально получите около 80% основной семантики,

- определение образующих слов,

- сбор статистики поисковых систем, поисковых подсказок, семантики из истории (Search Console, семантика конкурентов),

- группировка запросов,

- чистка и кластеризация запросов.

Инструменты сбора запросов:

- Поисковая статистика: Google Adwords, поисковые подсказки, похожие запросы.

- Внутренняя статистика сайта: Google Search Console, Google Analytics

- Поисковые запросы конкурентов. Тут интересен Ahrefs и SimilarWEB. SimilarWEB полезен, когда показывает низкочастотные запросы. Иногда он также сильно дополняет тот же Ahrefs. Если у вас абсолютно новая ниша и нет Search Console, то SimilarWEB показывает хорошие, «жирные» ключи.

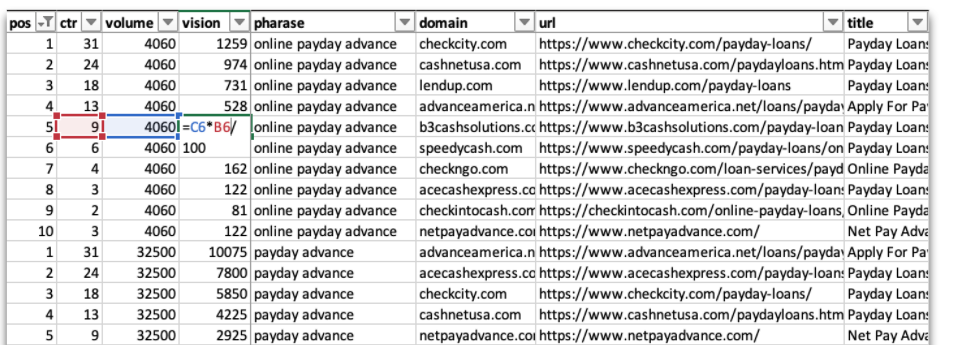

Дальше по всем ключам мы собираем топ 100. Берем частоту с того же Ahrefs, применяем средние данные по CTR, суммируем по всем фразам и получаем свою видимость в рамках своей ниши. Вот как это выглядит на практике.

Есть ключ, мы собрали по нему топ 10. Первая колонка – это позиции, вторая – CTR средней позиции, третья – Volume, четвертая – Vision, где мы перемножили вторую на третью и получили ориентировочное количество трафика в месяц на url. С url мы выделили домен, просуммировали и получили видимость по каждому домену.

Это долгий способ. Его реализация доступна только в больших командах с серьезными мощностями.

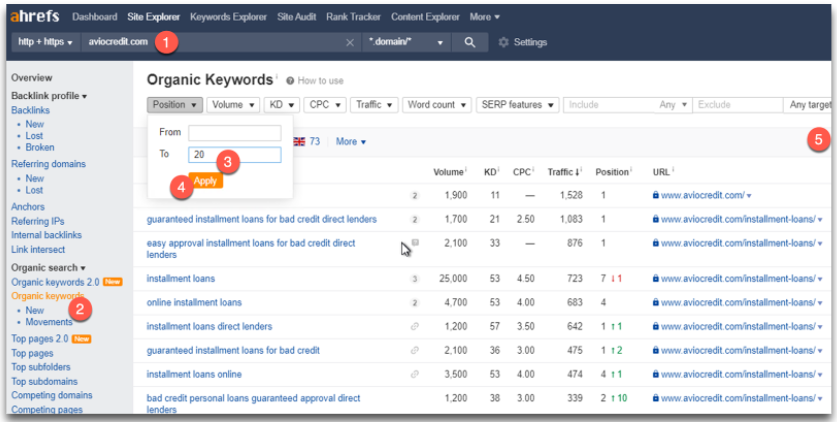

Ниже приводим способ, который может использовать каждый. Фактически делаете все тоже самое. Нашли хотя бы одного конкурента, как на предыдущем этапе. Дальше переходите в Competing domains, загружаете отсюда топ-20 и переносите в Keywords Explorer в Ahrefs.

Так практически сразу можно получить ту же видимость. Она плюс-минус коррелирует. Вот таким образом вы стремительно получаете сайты по нужным вам ключам.

Далее мы собираем параметры:

- Первый этап – получить видимость одним из доступных способов.

- Второй этап – собираем параметры доменов (по A-Parser или Netpeak Checker).

- Третий этап – динамика по трафику. Здесь пользуемся любым открытым источником, который вы можете спарсить, а полученные данные добавить потом себе в Excel.

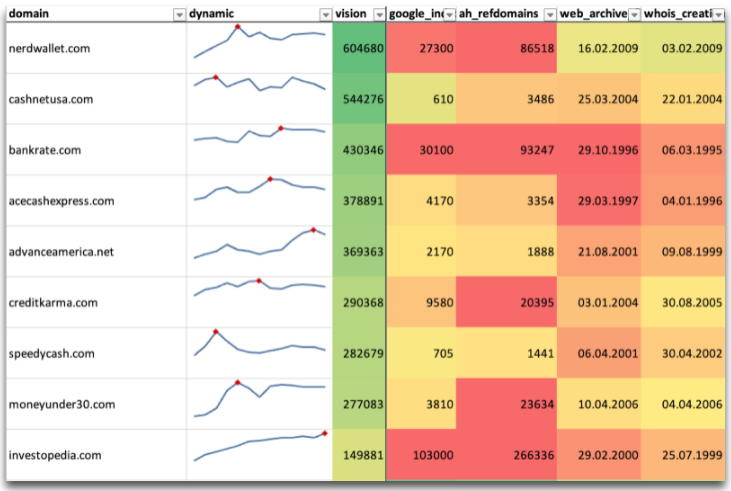

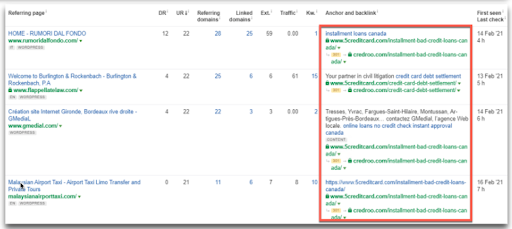

В итоге получаем вот такой огромный файл

Когда нужно посмотреть какого-то конкурента, можно в нем фильтровать информацию по нужным данным и сразу находить нужных конкурентов для анализа. Долго и нудно? Да, но оно того стоит.

Анализ ниши: ключевые параметры

В основном анализ мы делаем для того чтобы запустить какие-то сайты. В первую очередь мы смотрим:

- на возраст,

- на основные затратные моменты для обычного сайта (количество контента и ссылок),

- на динамику.

С помощью ранее составленного файла Excel мы достаточно быстро нашли очень сильного конкурента. В данном случае рассматриваем самого «молодого» из топовых, ему 10 лет. Это самый «молодой» сайт в этой таблице, он предпоследний. Быстро взлетел, небольшое количество ссылок и страниц. Вроде бы идеальный конкурент для анализа. Но в такой нише легко «зайти» — это очень подозрительно и здесь явно есть много подводных аспектов, которые через первичный анализ мы не увидим.

Получив такой файл, вы можете легко понять конкурентность в нише, сколько нужно ресурсов на контент, ссылки, какая динамика, есть ли новые сайты.

Если у вас уже есть сайт, то таким образом вы можете легко оценить, какую долю рынка на текущий момент вы занимаете, и какой потенциал роста у вас есть. Допустим, если вы занимаете 50-ое место по видимости и уже нормально зарабатываете, то вы четко понимаете, что вам есть куда дальше расти и можете более смело вкладывать деньги. Есть и аналогичная обратная ситуация: вы входите в какую-то нишу, зарабатываете немного денег, но обнаружили, что входите в топ 5. Соответственно стоит задуматься, а стоит ли вам здесь делать большие влияния или расширять свою нишу или перевести проект на поддержание.

Анализ ниши при запуске нового сайта

Новый сайт можно посмотреть по Whois Creation. Для этого фильтруем по дате регистрации доменов и смотрим, что Смогли выжать новые сайты из ниши. Это не всегда релевантно, потому что домен может быть давно зарегистрирован, а работу с ним могут вести недавно. Поэтому лучше смотреть по Web Archive. здесь больше данных для понимания. Например, первый сайт зарегистрирован в 2015 году, но первые данные по нему по Web Archive появились в 2020 году. То есть сайту не 7 лет, а всего лишь 2 года. Это уже более интересно для нас.

Нашли лучший из свежих, который имеет неплохую динамику.

С четвертой по седьмую колонку он 1-5-10-20. Есть коммерческие ключи в топе. Соответственно его записываем, это один из кандидатов на детальный анализ.

Всегда стоит быть аккуратным при анализе данных. На скрине ниже пример: вроде бы нашли 2021 год, вообще свежий сайт, пару месяцев ему всего. Но если мы посмотрим дальше в Ahrefs, то это подклеечка. Поэтому с таким нужно быть аккуратным, чтобы не сделать выводов по неправильным данным.

Общие итоги по запуску нового сайта и динамике новых сайтов в нише. Вы сразу понимаете, какую долю рынка могут занять ваши молодые сайты, количество таких сайтов, есть ли они вообще, какая вероятность попасть в топ, а также какие ресурсы и фишки используют молодые сайты.

Анализируем сайты из топ 1-3-5-10

Еще один интересный момент при анализе конкурентов — смотреть сайты, которым доверяет Google. Это распределение по топ-1, топ-3,топ-5 и топ-10. Важно делать анализ топ выдачи. Одно дело попасть в топ-10, другое — держаться в топ-1, потому что тут уже включаются дополнительные алгоритмы, фильтрация, поведенческие факторы и т.д. Очень большой комплекс. Те сайты, которые в топ 1 или в топ 3 — они очень хороши и в ссылках, и в контенте, и в продуктовой истории. Поэтому фокусироваться на таких сайтах тоже обязательно нужно. Просто подсчитываете.

У меня в нише 1800 сайтов, а в топ 1 всего лишь 50 сайтов, которые имеют больше одного ключа. В принципе здесь уже можно подключить продуктовую составляющую и посмотреть каждый такой сайт. Внимательно посмотреть, какой тип страниц у них занимает топы. У кого-то это может быть блог, тогда уделять внимание больше блогу. У кого-то — лендинги с каким-то специфическим контентом, ссылками или продуктовой добавочной стоимостью. Все это нужно смотреть.

Дальше при анализе топа выдачи вы можете фильтровать топ 10. Например, по Web Archive, поставить два фильтра и занести это в отдельную группу. Но Advance опять таки выскочит, поэтому смотрим под разными углами.

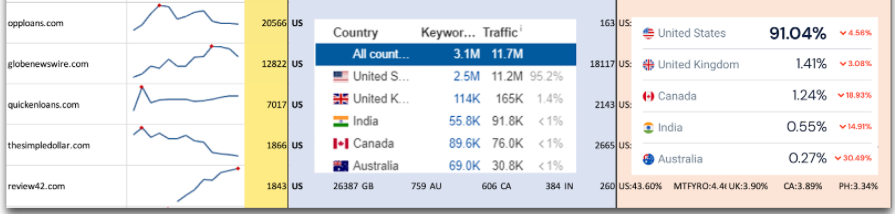

Региональность при анализе сайтов-конкурентов

Стоит также учитывать региональность и выкидывать из своего первичного анализа мировые сайты. Например, если мы говорим об англоязычных странах и оптимизируем под ту же Австралию, Канаду, то довольно часто в выдаче встречаются большие американские сайты или сайты, заточенные под весь мир. Изначально их лучше вообще исключать или ставить во вторую очередь для анализа. Но самое главное те ключи, по которым много мировых сайтов, первично не брать, потому что это достаточно подозрительно. Их нужно ставить где-то в отдельном месте. Также нужно периодически мониторить на предмет того, выбивается ли в топ региональная история. Желательно уходить в те ключи, где вы видите, что стоят региональные сайты.

Если мы видим, что сайты заточены под регион, то интересно находить сетки. Сегодня мы часто встречаем сетки с меньшим количеством внешних ссылок, но эти сетки залинкованы между собой в разных регионах. Соответственно получается, что достаточно качественные сайты на вас же ссылаются. Такая прокачка качественными тематическими сайтами друг друг сейчас довольно хорошо работает.

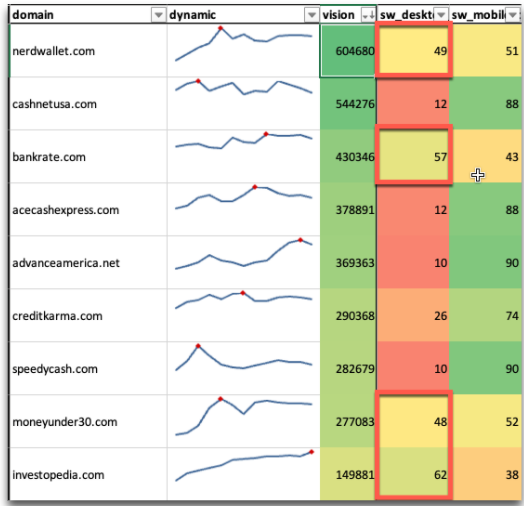

Анализ по типам устройств

С точки зрения продукта интересно посмотреть, какой тип устройств преобладает. Сейчас конечно 80% мобильного трафика. Если этот момент взять за основу и делать упор только на мобилки, то вы можете на старте сильно проиграть. И только потом поймете, что у вас лендинги не заточены под тот тип девайсов, который преобладает на рынке.

На скрине выше мы четко видим 4 из 9 сайтов имеют значительное количество еще и десктопа. В любом случае не стоит забывать, что в нише есть достаточно много десктопного трафика, соответственно не стоит забывать и про соответствующие лендинги.

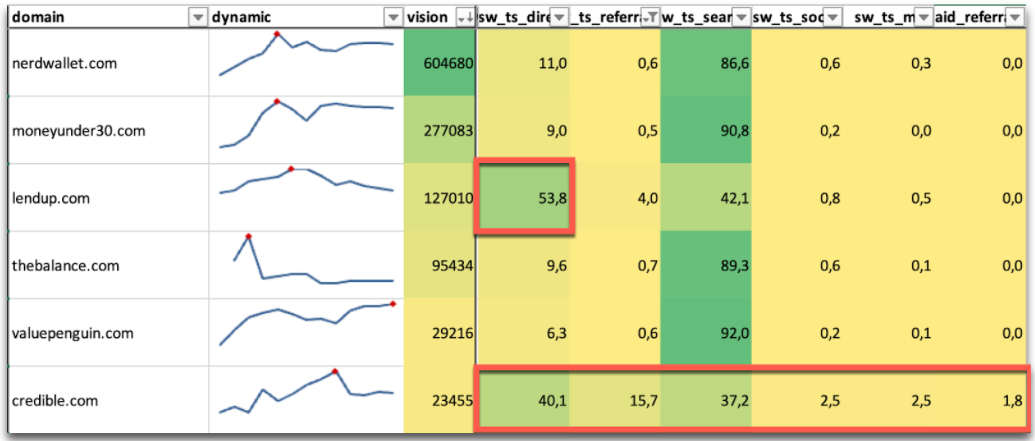

Анализ типа трафика по источнику

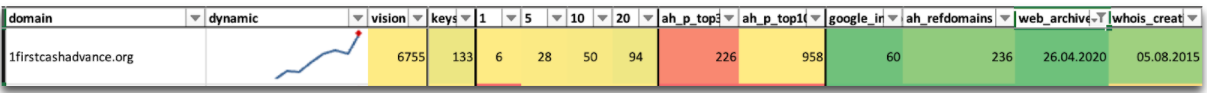

Следующий важные момент — распределение источников трафика. На скрине ниже видно, что credible.com (ревьюшник) — это продукт, соответственно у него много реферального, партнерского трафика, при этом доля поискового незначительна. С помощью такой таблицы вы сможете быстро понять, на каких сайтах стоит сфокусироваться, и посмотреть с каких сайтов этот трафик идет.

Стараемся понять распределение трафика по типу источника (с каких страниц), какая на этих сайтах аудитория и т.д. Это уже такая более маркетингово-продуктовая история, она уже выходит за рамки SEO, но достаточно важная.

Читайте материал, Как проверить посещаемость сайтов конкурентов, как посмотреть динамику трафика, источники, ГЕО и другие важные параметры конкурентов.

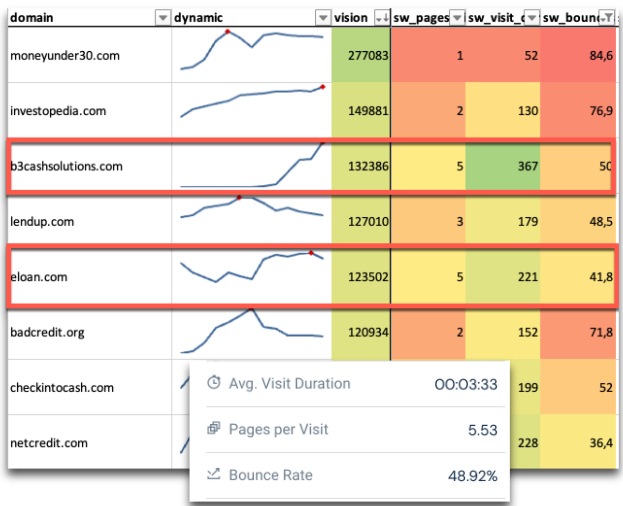

Анализ продуктовой составляющей

Вы можете посмотреть дополнительные параметры:

- сколько времени проводит посетитель на сайте,

- показатель отказов,

- длительность сессии и т.д.

Здесь важно разделить сайты по типам: продуктовый, ревьюшник, информационный. И анализировать каждый тип с точки зрения своего ресурса. Например, применение на ревьюшнике наработок информационного сайта (у которого больше трафик), может дать неплохой профит.

Выбор конкурентов для анализа контента

Алгоритм работы с контентом конкурентов:

- Разбить сайт-семантику на группы.

- В рамках каждой группы определить лидеров.

- Ресеч и анализ фишек в каждой группе

Для контента важно разбивать сайт-семантику на контентные группы: коммерческие ключи, блоговые, инструменты и разные разделы. Кто-то, например, плотно работает с блогом. Да, конверсия у него значительно меньше. Но, во-первых, он есть, а во-вторых, возможно они тратят значительно меньше ресурсов на те же ссылки и все равно получают профит. Я думаю, что с блога можно получать нормальный профит. Поэтому желательно разбить контент по типам, и на своем сайте реализовать все фишки в рамках каждой из такой группы.

Что смотреть при анализе контента конкурентов

- структура страницы. Я это называю подпиксельный анализ. Если вам сложно представить, как это делать, то просто распечатываете страницу и попиксельно каждую зону просматриваете, выписываете фишки. Анализируете так в каждом из больших кластеров.

- принципы формирования основных зон документа: title, description,header, sidebar, footer. Смотреть желательно отдельно на мобильных и на десктопе,

- тип используемого контента,

- перелинковка между страницами группами страниц,

- какие элементы контента дают возможность страницам расширять сниппет (таблицы, списки, разметка).

Выбор конкурентов для анализа ссылок

Выгрузка всех ссылок из разных источников

Для этого пользуемся стандартными сервисами

- Ahrefs,

- Majestic,

- Moz,

- Serpstat,

- PublicWWW,

- [email protected]. Он достаточно быстро краулит весь Интернет. Можете ему написать, он вам откроет неизведанный мир ссылочного. Судя по его аналитике, все больше проектов закрываются от Ahrefs, Majestic, т.е. от всех стандартных краулеров. Сергей нам позволяет видеть этот мир чуточку больше.

Читайте гайд на Коллабораторе, как проверить обратные ссылки на сайт, как посмотреть динамику ссылочного профиля, выгрузить все внешние ссылки на сайт.

Разрезы первичного анализа в порядке убывания

Основные параметры при анализе конкурентов по ссылкам:

- Индексация страниц ПС.

- doFollow/noFollow.

- Тематические / околотематические доноры.

- Раздел сайта.

- Тип ссылок.

- Тип анкора.

- Качество площадок.

Когда вы соберете все ссылки, важно понимать две взаимодополняющие вещи:

- то, что прокраулил Ahrefs, не значит, что Google видит также,

- не все то, что прокраулил Google, видит Ahrefs.

Далее мы все это детально посмотрим.

Определяем страницы в индексе поисковой системы

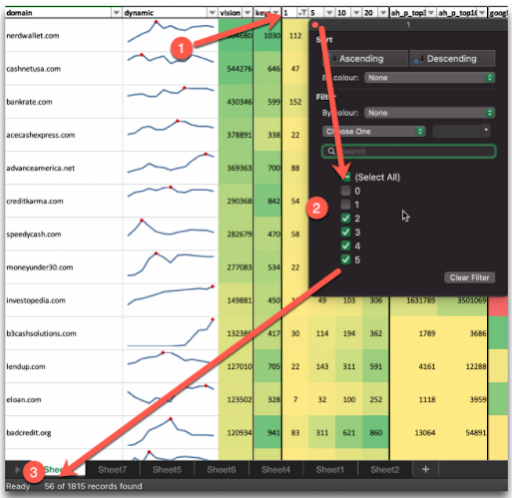

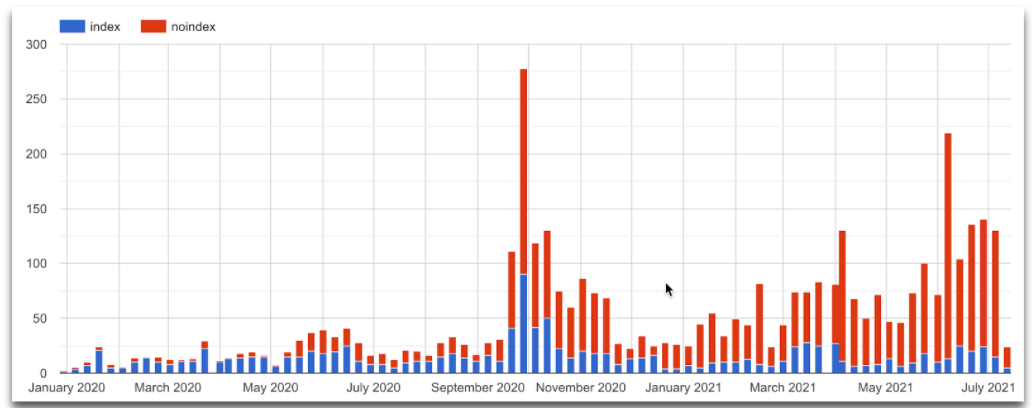

На скрине рабочий проект.

Вы видите топ ниши, какой процент ссылок по выгрузке с Ahrefs в индексе. Только у одного сайта больше 50, у всех остальных ниже. Мы видим, что только 50% ссылок проиндексированы. Это очень много. Так мы смотрим в разрезе ниши. Потом можно и нужно посмотреть в разрезе конкретного домена. По индексации это, наверное, не так интересно, но дальше мы поймем, почему так для этого проекта. Вначале все было хорошо с индексацией, но дальше количество ссылочной массы снижается, и соответственно снижается и индексация.

doFollow/noFollow

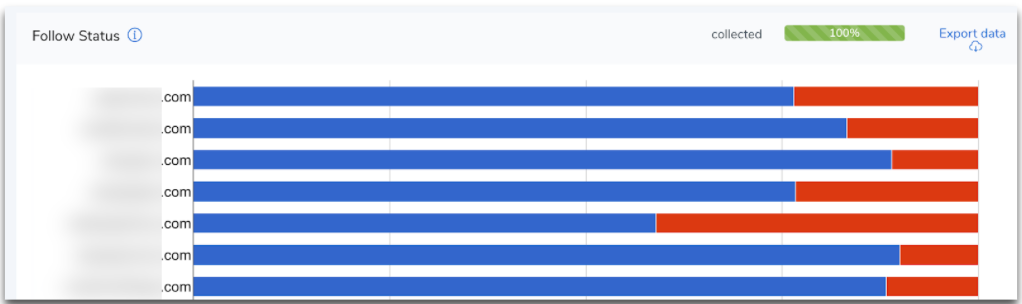

Тут уже не так все критично, около 75% doFollow ссылок. Здесь вы можете понять, какое распределение doFollow/noFollow в вашей нише. Возможно, в каких-то нишах показатель noFollow ссылок будет значительно выше или ниже. Вы это можете быстро посмотреть и принимать решение по планированию вашей ссылочной стратегии.

Тематичные/околотематичные доноры

Тематику можно посмотреть по SimilarWeb. Во многих нишах тематика сложна для получения, т.е. сложно получить тематические доноры. От ниши к нише все по-разному. Если в каких-то нишах вы найдете конкурентов, которые имеют большое количество тематических доменов, то стоит вот эти все синенькие (тематические домены) собрать в список.

В этом конкретном случае показано по данным SimilarWeb, мы еще по другим параметрам оцениваем тематику. Но если брать по категории SimilarWeb, то я бы собрал все эти синие в отдельный список и каждый домен просмотрел. А пото — сделал бы этот график для своего сайта с распределением максимально большим по сравнению с конкурентом.

Также стоит смотреть тематические страницы. Здесь вы можете банально взять базовые слова, которые генерируют основной кластер запросов. Если вы выгружаете с Ahrefs, то там есть сразу выгрузка по Title. В Excel вы можете сделать отдельную колонку «тематичные страницы», профильтровать по вхождениям в Title.

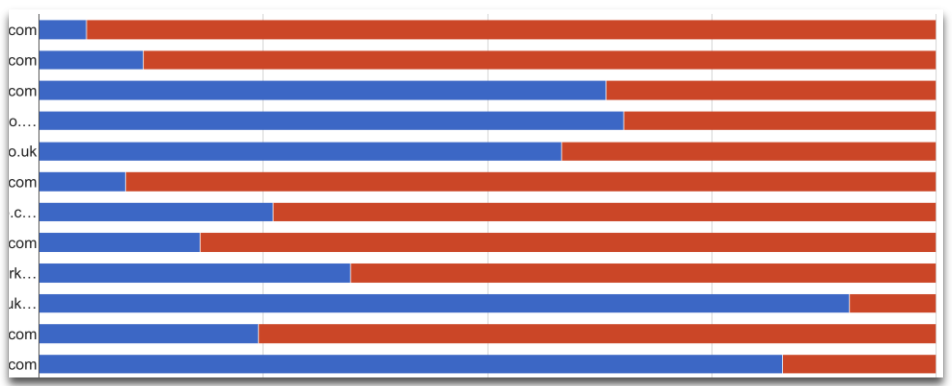

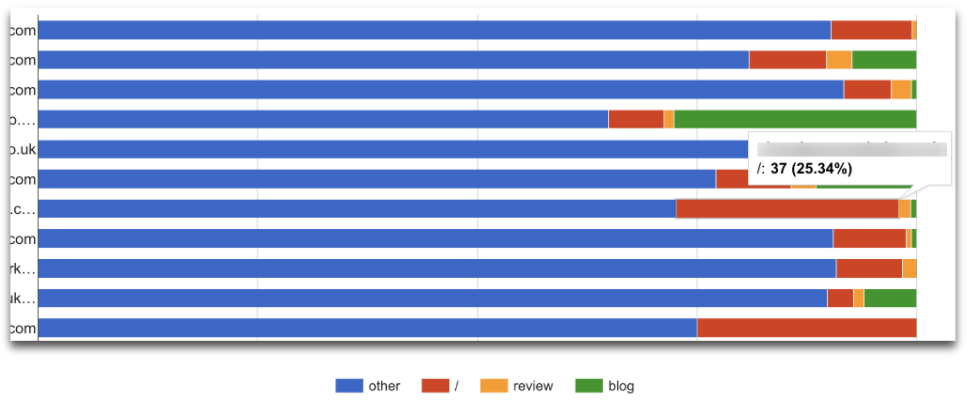

Раздел сайта

Нужно четко понимать, сколько ссылок ставить на главную, а сколько на внутреннюю страницу. Это первичный вопрос, который мне задают, наверное, 80% клиентов. На самом деле нужно углубляться (т.е. если внутренняя, то это блог).

На скрине видно, сколько ссылок размещено на внутренних страницах (синим), а красным показано, сколько на главной. На главную страницу здесь ставиться около 10%.

Типы ссылок

Желательно всю ссылочную массу классифицировать по типам ссылок. У нас где-то 20-25 основных типов, и мы всегда стараемся ссылочную массу классифицировать.

Зачем мы это делаем:

- для понимания того, как это сделано у конкурентов,

- для оценки стоимости продвижения, потому что каждый тип ссылок имеет свою стоимость,

- Для разработки своих ссылочных стратегий. Мы постоянно пополняем базу, у нас есть ссылочные стратегии в рамках месяца, квартала. Когда мы разбираем конкурентов в своих или околосмежных нишах, то такая классификация позволяет пополнять базу донора и проставляться на разных хороших типах.

На скрине ниже видно, что в нише преобладают ссылки с форумов. Тут 50% — это форумы, а значит, и бюджет в этой нише будет дешевле (раз в 20-30), чем в нише, где нужно больше guest posts.

Типы анкоров

Мы выделяем такие типы анкоров:

- коммерческие анкоры

- домен-урл,

- брендовые,

- спам и все остальные.

Нужно ли это делать? Точно нужно. Потом нужно смотреть на какие разделы это все «навалено». Любые данные, которые мы смотрим, нужно пересекать. И два, и три, и четыре разреза.

Проанализируем скрин выше. Что мы видим по типам анкоров. Сначала, с сентября 2020 года, стратегия достаточно сбалансированная. Коммерция не выделяется, используется домен-урл, брендовые. Но с конца сентября, почему-то начали «наваливать» коммерции. Включаем сразу критичное мышление: «навалили» коммерции и по трафику сразу улетели. Если сопоставить эти два пула данных, то можно сделать выводы, что лучше коммерцию не использовать. Но если копнуть глубже, то вся эта коммерция (красная), на самом деле, это конкуренты. Они просто взяли и «навалили» коммерцию с комментов. Вы берете данные по коммерции (красные) пересекаете с комментами (зелеными). Сразу же становиться видно нехороших конкурентов для этого сайта, которые просто взяли и «навалили». Причем довольно-таки грамотно это сделали. В результате сайт упал.

Важный нюанс: ваша ссылочная масса должна быть всегда максимально естественной. Нужно обязательно держаться в такой дельте естественности и не переходить ее, потому что любой апдейт может срезать естественные границы, и вы можете «улететь».

При этом у вас все будет идеально: хороший контент, хорошие доноры, ссылочная масса по типу прекрасная, а вот этот параметр плохой и сайт проведает в выдаче.

Качество площадок

У каждого свое понятие качества сайта. Вы можете по-разному оценивать его. Например, тем же Check Trust и т.д. Но лучше всего взять свою оценку разных разрезов анализа и посмотреть на паре ниш. Вы там начнете искать какую-то корреляцию.

Комплексный подход при работе со ссылками

При анализе ссылочной массы конкурентов важно помнить: нужно комбинировать или делать какую-то фильтрацию.

Например, взяли guest posts (тип ссылки) и смотрите другие метрики: на какой тип страниц ссылаются, какой тип анкоров. На коммерческие страницы будет идти больше коммерческих ключей. Например, на блог может идти больше азы (это большие длинные ключевики (пяти-восьмисловники), которые идут для прокачки блога).

Потом анализируем коммерческие анкоры (тип анкора). Смотрите, с каких типов сайтов идут ссылки, с каких типов доноров на какие типы страниц. Вот такие разрезы дают максимально глубокое понимание в анализе. В этом случае вы всю нишу видите досконально.

Проверяем гипотезы на просевших конкурентах

После проведенного анализа в статике и в динамике, желательно еще наложить свои гипотезы на тех конкурентов, которые выпали. Вы понимаете, что вам нужна качественная ссылочная масса. Вы посмотрели и увидели, что комменты и форумы не работают. Вы все это зафиксировали. Потом накладываете на просевшие ресурсы за последнее время, после чего находите или нет подтверждение своим гипотезам. Довольно часто идет попадание.

Считаем ссылочный бюджет

Есть реальные цены за размещение ссылок. В основном, это guest posts. Что вы дальше делаете. У вас есть типы, Average cost (3 колонка), куда вы подставляете среднюю стоимость по каждому типу ссылок. Потом Real cost и Final cost (последняя колонка) по каждому конкретному донору, если у вас раньше уже были наработки по тому же Аутричу. ТАк вы можете получить финальную цифру: сколько всего вложил конкурент конкретно в ссылочное продвижение. Сопоставьте ее со своими бюджетами, со своим видением бюджета на 1-2 года вперед — и вы сможете четко понять, нужно вам в эту нишу или нет.

Примечание от руководителя биржи прямой рекламы Коллаборатор по стоимости ссылок:

Как выгрузить площадки из Коллаборатора. Заходите в каталог, там есть кнопка «скачать», вы ее нажимаете и все цивильно выгружаете для разных форматов размещения с ценами и т.д. Единственное, эта фича пока только по запросу. Вы можете написать в Support, ребята вам сразу ее включат, и вы сможете ею пользоваться. Мы стараемся делать все достаточно просто.

Сессия вопрос-ответ

- Это отдельный доклад, на самом деле. Мы буквально за последний месяц вывели кучу индикаторов (штук 15-20). Хорошие ссылки. Давайте, наверное, по классике, Ahrefs Traffic. Позитивная динамика, мне нравиться метрика Google Trust, соотношение «плохих» и «хороших». Я здесь, к сожалению, кроме общей информации ничего не скажу. Это нужно делать отдельный доклад делать. То как мы это смотрим это просто отдельная вселенная.

- Это хорошая тема, обычно я ее не затрагиваю. «Старых» конкурентов анализировать прикольно тем, что на них ставятся какие-то хорошие новостники. Я этого не рассказываю, потому что порог работы, затраченное время и ресурсы очень большие. Если, например, там Forbes сослался (какой-то региональный Forbes) на вашего конкурента, то в принципе можно договориться с тем же Forbes. Но уровень материала, подготовки и вообще весь процесс может зашкаливать за тысячи долларов. Плюс по времени это может быть несколько месяцев.

Если мы говорим о «старых» проектах, то нужно смотреть за динамикой, по типу ссылочного профиля. Допустим, вы накопили какую-то процентовку, проходит апдейт. Именно в период апдейта это интересно смотреть. Если у вас какой-то тип перешкаливает (в процентах), то вы должны выделить те сайты, которые выросли, и те сайты, которые упали в апдейт. Желательно, чтобы у вас был отдельный tool, где мы четко видим пул сайтов, которые выпали после апдейта именно по нашей семантике. То есть моментально это видим, а не ждем Ahrefs. У вас уже будет четкое понимание того, как каждый конкурент продвигается.

Опять-таки, искать какие-то новые посадочные страницы, смотреть SimilarWeb у старых конкурентов. Наверное, работу всю ту же самую нужно проводить. Единственное, что стоит углубляться и не бояться пользоваться прикольными типами размещения ссылок. Плюс контент. Здесь нужно постоянное улучшение и повышение уровня мышления. И следить за динамикой по рынку по разным параметрам.

- Я же начинал с того, что я против ВЧ ключей. Конечно, смотрите СЧ и НЧ ключи. Я же прикладывал вам специальный кейс. Супер НЧ запрос – это пяти-семисловник. В нише понятно, что миллионы долларов крутятся, но нужно с чего-то начинать и с чего-то получать бюджеты. В любом случае есть какая-то ответственность перед инвесторами или в рамках компании или во внешних рамках. Поэтому сначала получайте деньги и трафик с НЧ и СЧ. Это классика. Если вопрос в том, нужно ли, то да, обязательно.

- Я об этом рассказывал. Просто ставьте на паузу то, что я рассказывал и выписывайте. Плюс посмотрите в Интернете, вбейте «анализ ниши». Я находил материалы, где эти чек-листы есть.

- Я бы смотрел на огромную семантику. Прайс-агрегаторы – стремно. Google сейчас, к сожалению, делает перекос. Как было раньше? Были большие сайты, потом умные сеошники начали делать мелкие сайты. Google нравились сугубо тематичные ресурсы, поэтому они начали вылазить в топ. Потом Google это перенравилось и он опять стал ставить большие сайты. Потому что большие сайты инвестируют деньги в контекстную рекламу, поэтому и маленьким сайтам тоже приходится инвестировать в рекламу.

Теперь ближе к вопросу. Я бы вообще посмотрел, есть ли те, кто смог побороть эти прайс-агрегаторы. Взять огромную семантику, даже десятки тысяч кластеров, и сделать анализ по топу, как я показывал. Вы берете, фильтруете, откидываете все агрегаторы и смотрите, какие сайты, лендинги вылезли в топ 1, топ 3, топ 5. За счет чего они это сделали, и уже дальше к себе все это применяете. Если вы не найдете такого, то это стремно. Но, я думаю, что найдете.

- Стремная история. Возможно, не получиться, но надо смотреть. Стеклянные двери в теории нормально. Я веду к тому, что это рунет, где не так все жестко. Здесь не надо конкурировать с Amazon, где миллионы ссылок на него. Вы должны понять вот эти процентовки по нише мебели. Вы можете общие характеристики всех проектов, всех ссылок выгрузить. Находите там качественные тематичные домены и дальше всю крутую ссылочную массу направляете по характеристикам, о которых я рассказывал, на свой сайт, только на «стеклянные двери». В теории это все должно зайти и вы должны обогнать конкурентов, поскольку у них вся ссылочная масса распределена по сайту, а у вас только на «стеклянные двери». Также пишите побольше блог, т.е. выпишите всю семантику. У вас должно быть все там. Соберите подсказки, вопросы. Все по классике.

- Я давал там ссылочку на Сергея. Для нас это самый верный вариант. Вы можете ему написать в паблик. Если нет доступа к Сергею, вы можете собрать семантику по длинным ключам, найти домены, которые содержат всю эту историю. Хотя, это подклейка, а это было больше про ссылки. Тогда только какими-то специальными историями.

- Думаю, нужно анализировать. Это единственный ответ. Я просто не понимаю, что значит, нет траста. Обычно таких сайтов нет. Я показывал, у меня в презентации был сайт, который вырос. К сожалению, я дальше не анализировал. Но это огромный сайт, у него явно огромные вложения. Просто смотрите. Они могли банально закупить медийную рекламу. По телевизору крутиться, а это огромнейший показатель брендовой истории. Просто так он там явно не может висеть, это раз. Второе, он может быть реально «старым», отвечать полностью интентам пользователя. Вот и все. Это знаете как в нише «Эссе» есть Essay Typer. Essay Typer – это, когда вы заходите, что-то там печатаете, и он вам пишет эссе. Он вообще с минимумом контента, но стоит в топе. Потому что люди туда заходят, «залипают» и все.

- Примечание Игоря Рудника: Частая причина того, что сайт в топе – это, как раз, наличие большого количества брендового трафика. Google любит брендовый трафик, и такие сайты часто ранжируются. И когда проверяешь именно долю брендового трафика и вообще этот бренд, то сразу понимаешь, почему сайт стоит в топе.

- А.Рева: Этот брендовый трафик не просто так появляется, он почему-то появляется. За брендовым трафиком что-то стоит и вы должны понять что. Возможно, это крутейший продукт, реклама. Вы должны докопаться до того, почему идет брендовый трафик.

Общие выводы по вебинару таковы.

Анализируете всех «основных представителей» ниши по разным разрезам. Самое главное — применять результаты и выводы. Если ваши файлы не будут применяться в реальной жизни и просто останутся в архивах, то это впустую потраченное время. Применять не стоит только в том случае, если вы видите, что там нужен реально большой бюджет, и вы не готовы рисковать пока деньгами.