Как сделать robots.txt для Wordpress

Файл robots.txt — важный инструмент SEO-оптимизации сайта. Файл robots.txt, по сути, это список правил для ботов поисковых систем. В его задачу входит налаживание контакта с ботами ПС и информирование их о том, в какие папки им нужно заглядывать для сканирования данных, а какие требуется обходить стороной.

Сразу следует сказать, что нет идеального файла robots.txt для WordPress, который подходил бы всем без исключения сайтам на этой CMS. Но есть базовые вещи, которые можно корректировать в зависимости от того, какие страницы сайта вы хотите открыть или закрыть для поисковых систем.

Что же необходимо указывать в robots.txt и как создать такой файл? Для начала следует понять, какие команды в нём содержаться и как вообще он «общается» с ботами поисковых систем.

Основными составными элементами файла robots для WordPress являются директивы и переменные данные, указывающие на файл (группу файлов).

Как сделать Robots.txt для Вордпресс: пошаговая инструкция

Если вы хотите указать разные условия для роботов Google и другой поисковой системы, тогда следует прописывать директивы с командами для каждого из этих поисковиков отдельно. Если же такую цель не преследуете, можете использовать общие правила, это означает, что в поле User-agent нужно указывать *.

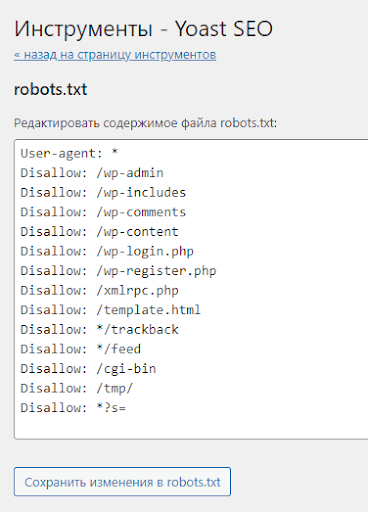

Пример составленного роботса:

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= Allow: /wp-content/uploads/ Allow: /*/*.js Allow: /*/*.css Sitemap: https://example.com/sitemap.xml

Алгоритм написания правильного документа для WordPress robots.txt

1. Указываем адресата команд (User-agent).

2. Закрываем от индексации (Disallow):

- файлы админки;

- личные кабинеты, формы регистрации и авторизации;

- инструменты работы с заказами (корзина, формы для заполнения данных и т. д.);

- подходы к интерактивным пользовательским интерфейсам;

- папку cgi;

- данные по функционалу поиска;

- служебные страницы;

- дублирующие страницы и разделы;

- данные о параметрах фильтрации, сравнения и правил сортировки;

- UTM-метки;

- плагины и графику тем оформления.

3. Открываем (Allow) те файлы и документы, индексация которых необходима, но они находятся внутри уже закрытых категорий, например, изображения и JavaScript.

4. Вводим данные карты сайта (Sitemap).

5. Если необходимо, прописываем Crawl-Delay.

6. Если необходимо, прописываем Clean-Param (учитывается только для ботов некоторых ПС).

7. Через сервисы Google и других поисковиков проверяем правильность заполнения robots.txt

Вроде бы ничего сложного нет, но достаточно часто возникает много вопросов относительно того, какие файлы и папки стоит закрывать от сканирования, а какие желательно индексировать.

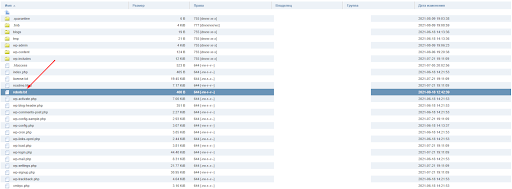

Как вылить robots.txt через FTP

Для написания robots.txt применим любой стандартный текстовый редактор, подойдёт тот же Блокнот. После того, как все данные будут внесены в документ, сохраняем его на компьютере под именем robots.txt. Осталось поместить его на сервер WordPress.

Заходим на FTP-сервер сайта (через хостинг, скачав плагин менеджер файлов WP или воспользовавшись таким ПО как FileZilla), находим папку главного каталога и перетаскиваем в нее свой файл robots.txt. Всё, поисковые боты видят рекомендации для индексации.

Какие плагины можно использовать для формирования robots.txt

Рассмотрим сразу два наиболее популярных плагина для WP.

Yoast SEO

После установки и активации плагина переходим в раздел Инструменты» вкладки «SEO» и выбираем «Редактор файлов», далее нажимаем «Создать файл robots.txt». На открывшейся странице можно составлять список команд для ботов поисковых систем или редактировать существующие данные. После проверки правильности заполнения сохраняем изменения.

Перейти на сайт плагина Yoast SEO →

All in One SEO Pack

По завершении установки плагина All in One для WordPress с целью создания файла robots.txt заходим в раздел «Управление модулями», выбираем иконку «robots.txt» и жмём «Activate». В открывшейся форме вводим дополнительные правила или удаляем (делаем неактивными) ранее добавленные команды. Редактор самостоятельно расставляет директории по местам, вводить название директорий не требуется.

Отличительная особенность All in One SEO Pack — настраиваемая блокировка вредоносных ботов, которые перегружают сайт, не принося вам никакой пользы.

Перейти на сайт плагина All in One SEO Pack →

Вне зависимости от выбранного способа создания файла robots.txt, если все директории и команды внесены корректно, поисковые боты будут видеть его и в большинстве случаев следовать указанным рекомендациям. После загрузки файла рекомендуем проверить его с помощью сервиса Google Search Console. Обратите внимание, при проверке в Google могут указываться ошибки в специфических командах для других систем, которые он не понимает.

Теперь вы знаете, как сделать файл robots.txt для WordPress и сможете направить стопы поисковых роботов в нужном вам направлении, облегчив нагрузку на сайт и оптимизировав процесс индексации данных на страницах вашего сайта.

Похожие вопросы

-

Google Search Console

Как работать в Google Search Console. Советы и рекомендации12 вопросов -

SEO пузомерки

Ключевые метрики SEO: где и как смотреть6 вопросов -

Линкбилдинг

Все про построение ссылочного профиля, крауд-маркетинг и аутрич10 вопросов -

Для опытных

Вопросы для продвинутых SEO-специалистов и новые подходы в SEO12 вопросов -

Аналитика

Вопросы по Google Tag Manager, Google Analytics6 вопросов -

Контент

Вопросы по SEO-копирайтингу. Какими должны быть SEO-тексты4 вопроса -

Другое

Общие вопросы по SEO. Все, что связано с поисковой оптимизацией1 вопрос