Битые ссылки на сайте – влияние на позиции, поиск и удаление

Попробуйте Collaborator.pro

Выберите из 36441 высококачественных веб-сайтов и 3414 Telegram каналов

ВперёдОдин из важных пунктов технического SEO — работа с битыми ссылками. Вебмастера и SEO-специалисты по-разному относятся к этой проблеме, но все знают, что большое количество 404 ошибок вредит сайту. В статье расскажем подробно:

- Чем опасны битые ссылки и как их обнаружить?

- Как влияет битая ссылка на сайт?

- Что делать с битыми ссылки?

- Как проверить нерабочие ссылки?

- Как избавиться от битых ссылок и нужно ли это делать?

А вы также посмотрите seo чеклист и проверьте, какие из пунктов технического SEO уже внедрили и что еще нужно проверить, кроме битых ссылок. А если только начинаете свой путь в SEO, пройдите бесплатные курсы по SEO для начинающих от Сергея Кокшарова.

Что значит битая ссылка сайте?

Битая ссылка — линк, который ведет на несуществующую страницу. Если перейти по такому адресу в браузере, отобразится ошибка «404 Not Found».

Внешний вид технической страницы зависит от заданных настроек. Пользователи увидят либо стандартный текст в духе «Такого адреса не существует», либо уникальный контент.

Тем, у кого мало опыта в SEO, может показаться, что битые ссылки на сайте — незначительные ошибки, которые не влияют на эффективность продвижения в поисковиках. Это действительно так, но только если битых ссылок мало. Когда их количество постоянно увеличивается, необходимо принять экстренные меры.

Поиск битых ссылок на сайте и борьба с их возникновением — стандартная задача технического SEO, которую опытные сеошники и вебмастера решают с помощью специализированных инструментов. Ее нужно делать вместе с другими техническими задачами: устранением дублей, оптимизацией скорости загрузки сайта и др.

Как влияют битые ссылки на продвижение сайтов

В среде оптимизаторов давно сложился стереотип, что битые ссылки выступают в роли «красной тряпки» для роботов поисковых систем. Якобы, если на сайте будет много 404 ошибок, позиции обязательно упадут.

На самом деле, ничего страшного в наличии битых ссылок нет. Если у сайта нет других критических недостатков, несколько 404 ошибок не повлияют на видимость в поисковых системах.

Но если битые ссылки будут расти в геометрической прогрессии и с ними никак не бороться, со временем проблема может стать заметной. К примеру, если на сайте 300 проиндексированных страниц, а 404 ошибок в панели для вебмастеров несколько тысяч — это тревожный сигнал для краулеров. В таком случае могут быть проблемы с индексацией новых страниц.

Битые ссылки опасны тем, что:

- Их сложно обнаружить. Когда на сайте несколько тысяч страниц, проверить каждый адрес вручную тяжело.

- Ухудшают поведенческие факторы. Большая часть пользователей, которые увидят «404 Not Found» вряд ли захотят искать контент вручную и закроют вкладку браузера.

- Нарушают распределение ссылочного веса. Если страница с высоким «авторитетом» внутри сайта ссылается на несуществующий адрес, ссылочный вес теряется и не уходит дальше по цепочке.

- Расходуют ресурсы поисковых роботов. Краулеры тратят время на обход несуществующих страниц, затем в Google Search Console появляются уведомления об ошибках.

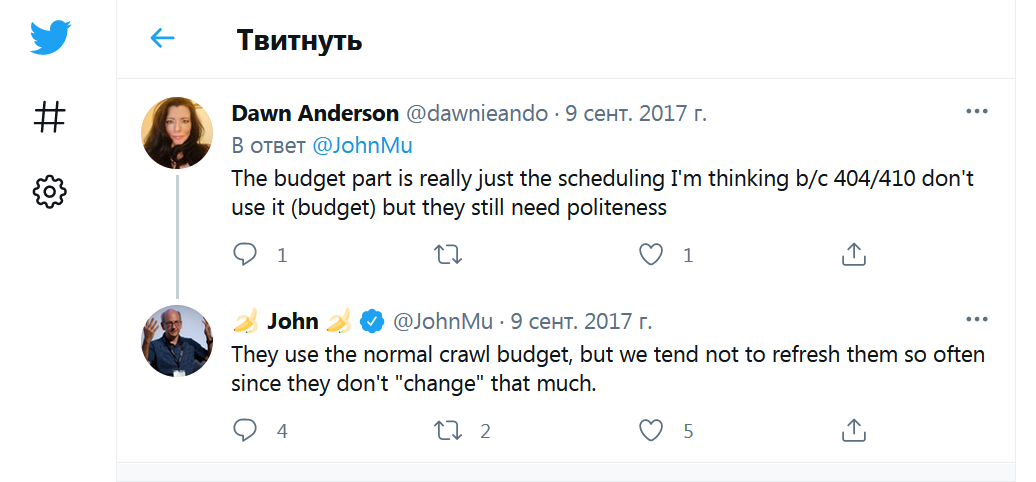

Вебмастера и SEO-специалисты боятся битых ссылок из-за распространенного мифа о том, что они расходуют краулинговый бюджет. Якобы если на сайте с несколькими тысячами страниц много 404 ошибок, то робот потратит ресурсы на обход несуществующих посадочных, а страницы с уникальным контентом не попадут в индекс.

Джон Мюллер, специалист отдела качества поиска по работе с вебмастерами Google, ещё в 2017 году развенчал этот миф. Он отметил, что страницы с 4xx ошибками не снижают краулинговый бюджет и не влияют на рейтинг остальных страниц.

Они используют обычный бюджет сканирования, но мы стараемся не обновлять их часто, поскольку они не так уж "меняются".

Будет справедливо отметить, что так называемые «SOFT 404» влияют на распределение краулингового бюджета. Это подтверждает статья в официальном блоге поисковой системы. «Мягкие 404» — несуществующие страницы, которые при обращении к серверу отдают код 200, а не 4xx.

Откуда берутся битые ссылки?

Битые ссылки не возникают сами по себе, они появляются из-за ошибок вебмастера, технических проблем на сайте или особенностей системы управления контентом. Проверка битых ссылок – стандартная процедура технического SEO, но не все владельцы веб-ресурсов уделяют ей достаточно внимания.

Анализ битых ссылок важен так же, как и проверка позиций сайта в поисковиках или мониторинг бэклинков. Если проверять наличие 404 ошибок раз в полгода, может оказаться, что за это время их количество сильно увеличилось.

Если хотите найти CMS с идеальной защитой от битых ссылок, то такой не существует. Даже в самых продвинутых системах управления контентом часто появляются программные ошибки, которые влияют в том числе и на формирование URL-адресов.

Изменения в структуре сайта

При глобальных изменениях в структуре почти всегда появляются 4xx ошибки. Например, если на этапе создания сайта выбрали неправильную структуру URL, а в процессе продвижения решили изменить её, появления битых ссылок не избежать.

В популярных системах управления контентом реализован автоматический редирект. Если изменить адрес страницы и попытаться перейти в браузере по старому URL, произойдет перенаправление. Посадочные, которые приносят трафик, лучше не трогать, но если пришлось изменить структуру, обязательно проверьте корректность настройки 301 редиректа.

В среде оптимизаторов есть хорошее правило: «Работает — не трогай» и оно напрямую касается структуры URL. Настраивать ЧПУ и решать другие задачи по оптимизации необходимо до старта активного продвижения сайта.

Удаление старых страниц и файлов

В процессе работы над проектом часто приходится удалять страницы и файлы. Ссылки на картинки или документы, которых нет на сервере тоже создают 404 ошибки. Пристально следите за ними и старайтесь не допускать лавинообразного увеличения битых ссылок.

Если продвигаете интернет-магазин с большим количеством товаров, и часто возникает необходимость избавляться от неактуальных страниц, можно не удалять их, а менять статус товара. Если его больше не производят, удалите страницу и обязательно проверьте, чтобы на неё не было внутренних ссылок.

Ошибки вебмастера

Даже опытные оптимизаторы могут пострадать от последствий банальных ошибок. Важно понять, что появление битых ссылок — неизбежный процесс, который нужно контролировать и стараться по максимуму предупреждать появление 404 ошибок.

Битые ссылки могут возникнуть даже если вебмастер не делает глобальных изменений в структуре сайта и не удаляет старые страницы. Например, при покупке ссылок на бирже оптимизатор указал правильный адрес, но позже его пришлось изменить. Если он забудет поставить редирект, а стандартный алгоритм CMS не сработает, появится внешняя битая ссылка.

Аналогичные проблемы возникают при переезде на другой домен или изменении CMS. Вебмастер или SEO-специалист составляет карту редиректов, добавляет правила в .htaccess и забывает защитить файл от изменений. После установки плагина технический файл перезаписывается и редиректы пропадают.

Битые ссылки как конкуренты по SEO, которые стараются обойти ваш сайт. Не хотелось бы, чтобы они существовали, но это неизбежно и приходится постоянно с ними бороться для сохранения высокого рейтинга.

Проверка битых ссылок на сайте

Поиск и удаление битых ссылок — рутинная задача, которая решается с помощью специализированных инструментов. Она сводится к двум шагам: обнаружение и уничтожение. Найти 404 ошибки несложно, а вот борьба с их повторным возникновением может затянуться надолго.

Если на сайте 5-10 страниц, SEO-инструменты не нужны, можно проверить все ссылки на каждой странице вручную. Когда посадочных сотни, а бэклинков тысячи, без автоматизации не обойтись.

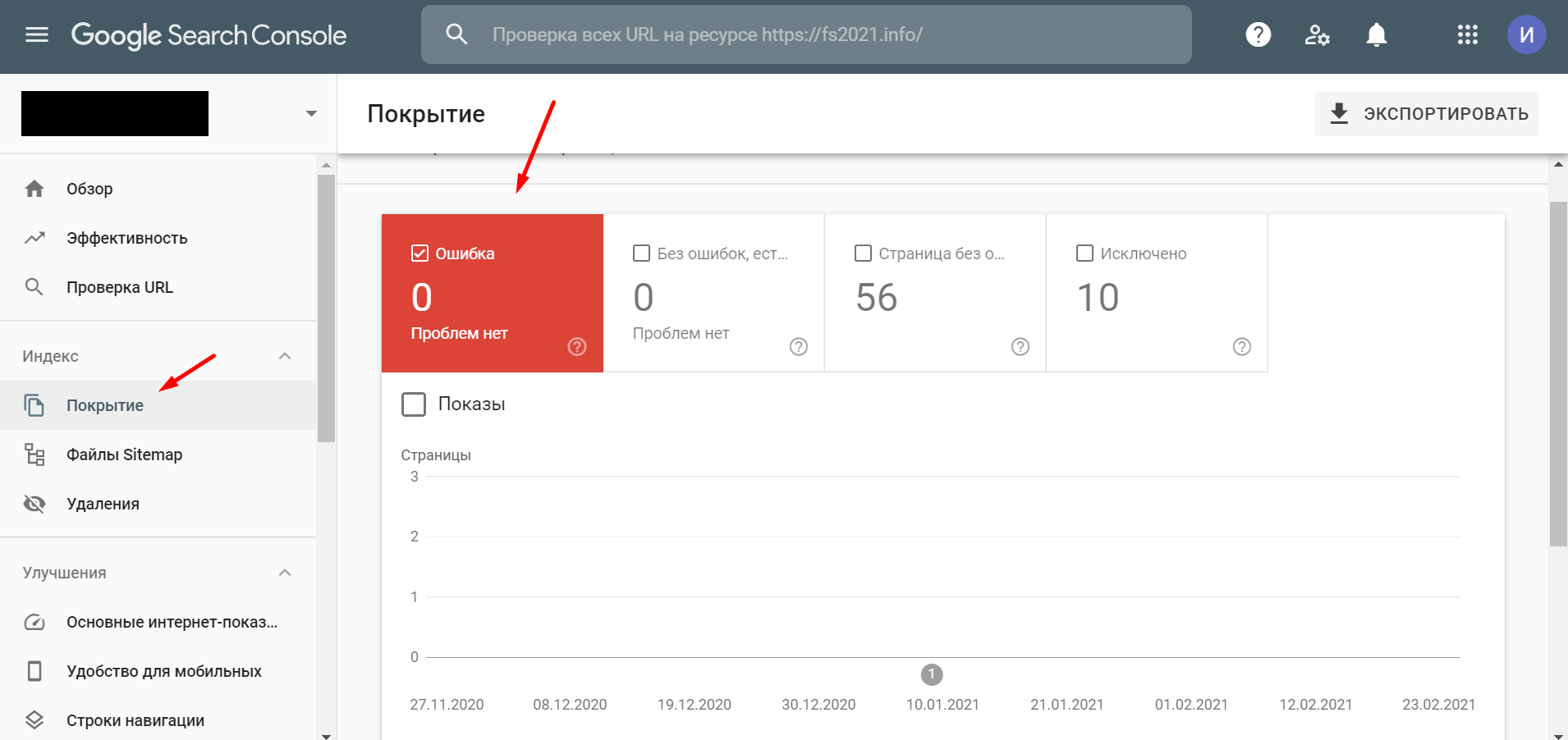

Google Search Console

Недавно Google обновил консоль для вебмастеров и теперь инструмент проверки 404 ошибок находится в разделе «Покрытие». В разделе показывается информация о статусе обработанных страниц.

Если в разделах «Ошибка» и «Исключено» нет проблем, значит с сайтом всё в порядке. Как только роботы Google обнаружат страницы, которые не могут обойти, в консоли появится уведомление.

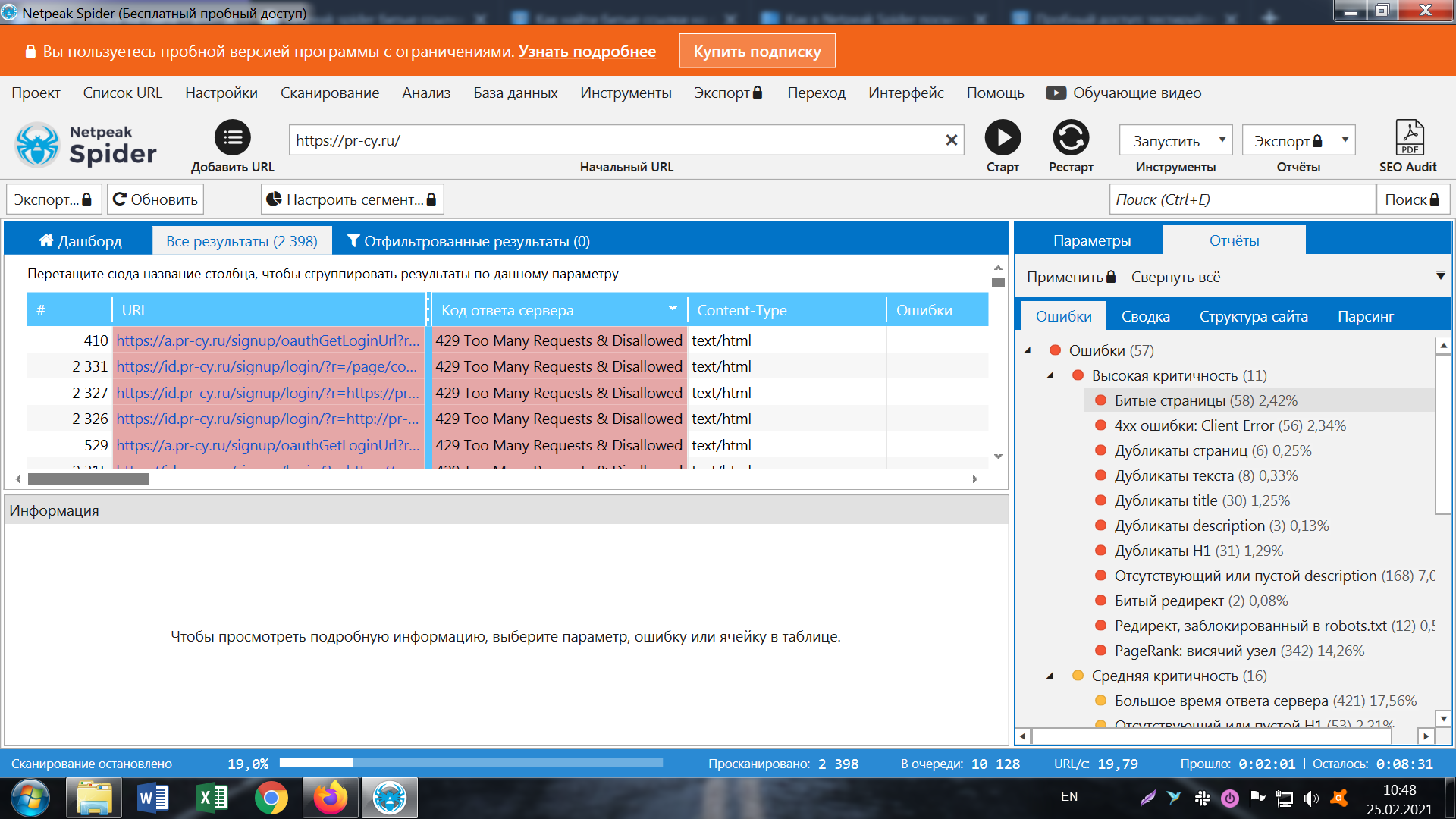

Netpeak Spider

Незаменимый инструмент для тех, кто работает с клиентскими сайтами на потоке или продвигает свои проекты с большим количеством страниц. Netpeak Spider проверяет сайт на 100+ ошибок по внутренней оптимизации и 70+ основных SEO-параметров. В числе возможностей и поиск битых ссылок.

Как запустить сканирование:

- Введите домен сайта в строку на главном экране.

- Дождитесь завершения сканирования.

- Информация о битых ссылках отображается в разделе «Отчёты» → «Ошибки» → «Высокая критичность».

- Если программа обнаружит 404 ошибки, в списке появится пункт «Битые ссылки». По клику отобразится таблица с перечнем страниц, на которых есть упоминания несуществующих страниц.

Главный недостаток софта в том, что в пробной версии нельзя получить доступ к отфильтрованным отчётам. Придется либо покупать платный тариф, либо вручную анализировать таблицу со списком всех URL и искать 4xx ошибки.

Чтобы ускорить процесс поиска, нажмите на пункт «Код ответ сервера» несколько раз, пока в верхней части списка не появятся страницы с нужным кодом ответа. Выгрузить данные в файл не получится, придется вручную проходить каждый проблемный URL.

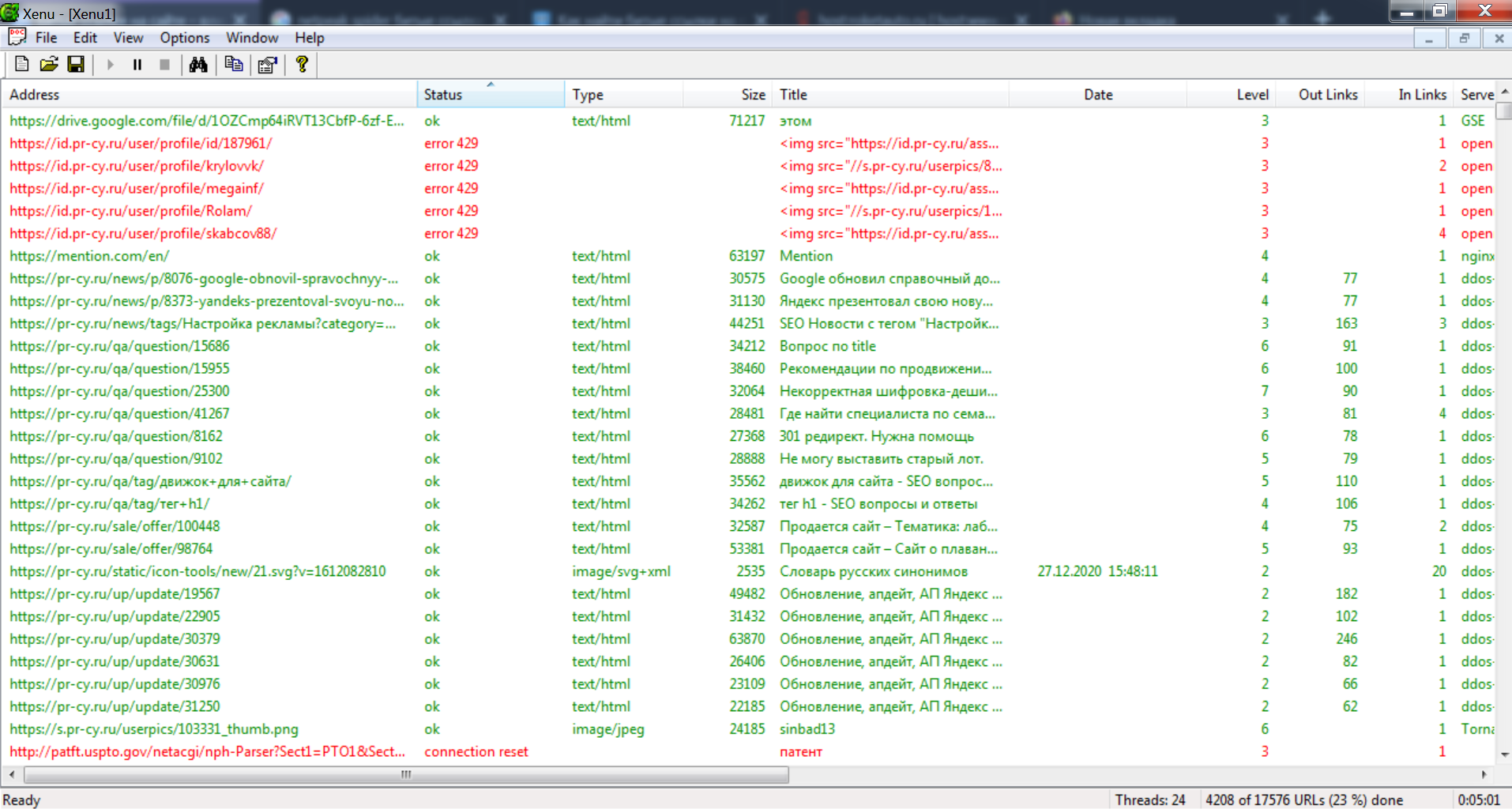

Xenu Link Sleuth

Популярный в среде оптимизаторов инструмент, который создавался для поиска битых ссылок. Программа давно не обновлялась, но и сейчас хорошо работает. Поиск осуществляется по стандартной схеме — после ввода домена запускается анализ структуры проекта.

После завершения сканирования все найденные URL окрасятся определенным цветом в зависимости от кода ответа сервера. Зеленый означает, что со страницей все в порядке. Нас интересуют элементы, которые подсвечены красным. Это страницы с 4xx ошибками.

Xenu Link Sleuth отлично справляется с поиском битых ссылок и работает довольно шустро, но для корректной работы необходимо изучить настройки. В стандартной конфигурации программа добавляет в таблицу много нерелевантных элементов: закодированные изображения, внешние ссылки и служебные URL.

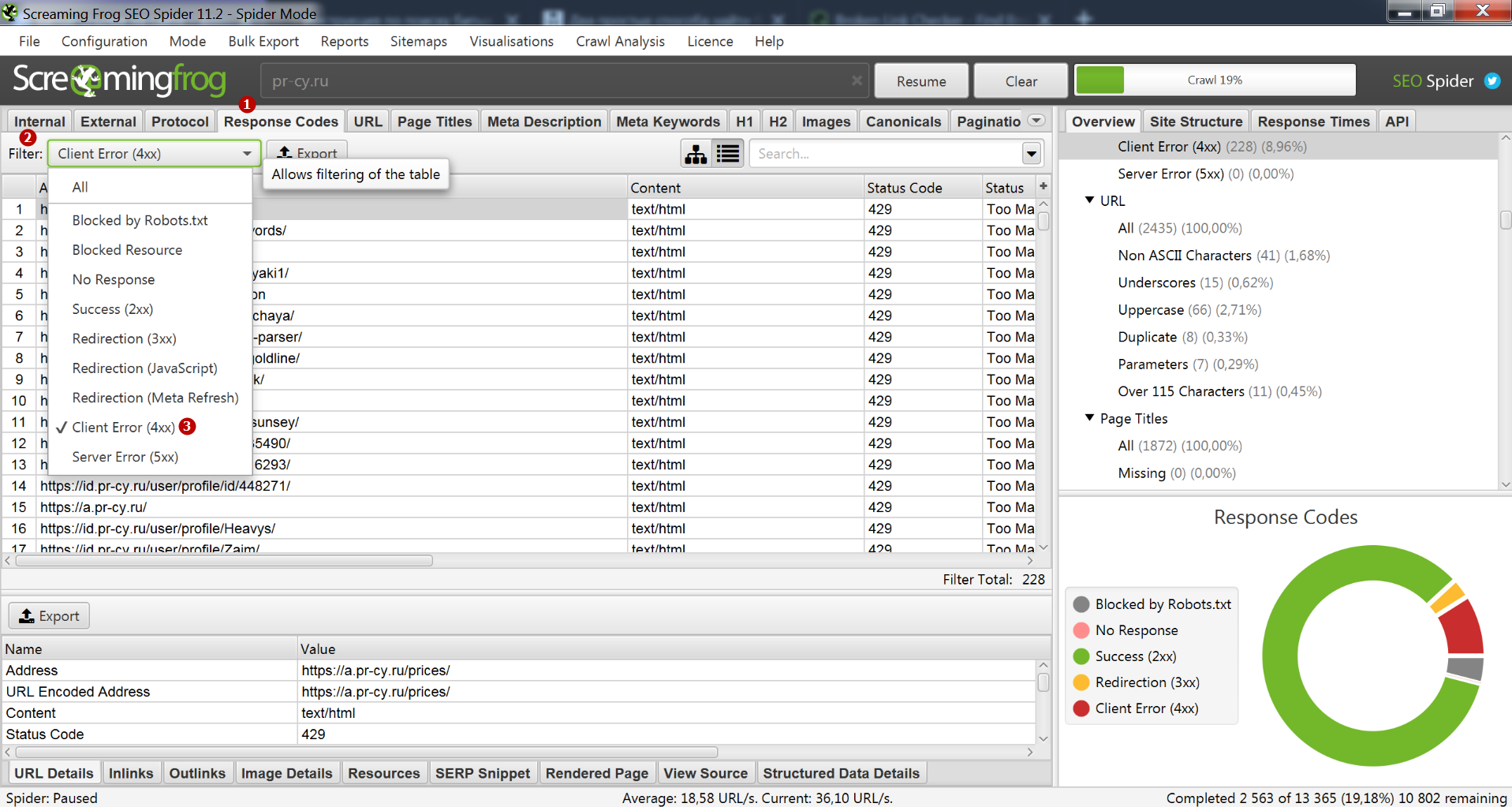

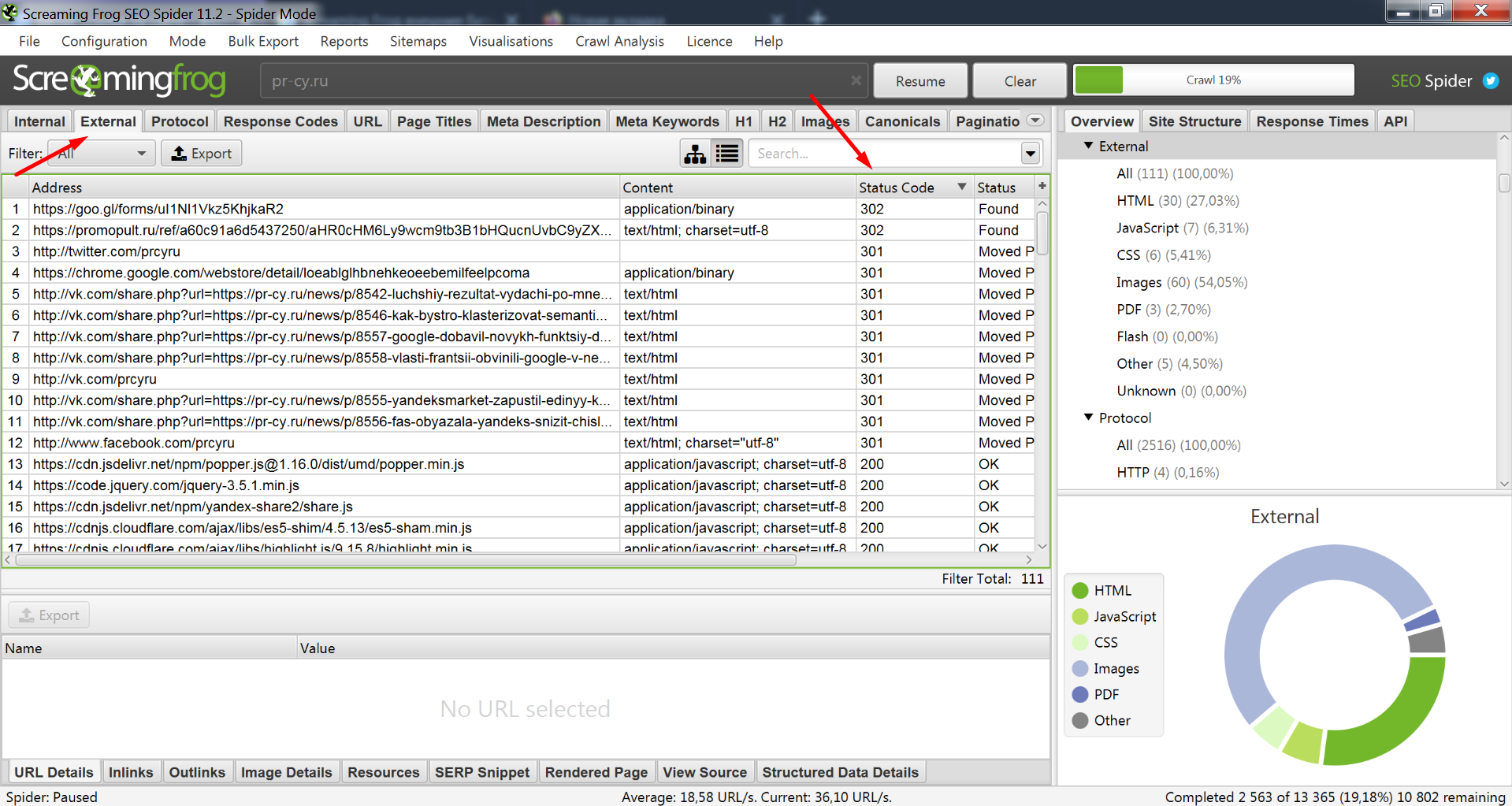

Screaming Frog SEO Spider

«Лягушка» сканирует сайт, формирует его структуру, показывает страницы с редиректами и ошибками, помогает решать задачи по техническому SEO. Она находит битые ссылки и в отличие от Netpeak Spider не накладывает ограничения на просмотр отчета по 4xx ошибкам и выгрузку данных в формат Excel.

Запустите сканирование сайта, дождитесь завершения обработки данных, перейдите во вкладку «Response Codes» → «Filter» → «Client Error 4xx». Кнопка экспорта отчета находится рядом с фильтром. В бесплатной версии программа обрабатывает не более 500 страниц сайта. Более подробно о возможностях и настройке Screaming Frog SEO Spider читайте в статье.

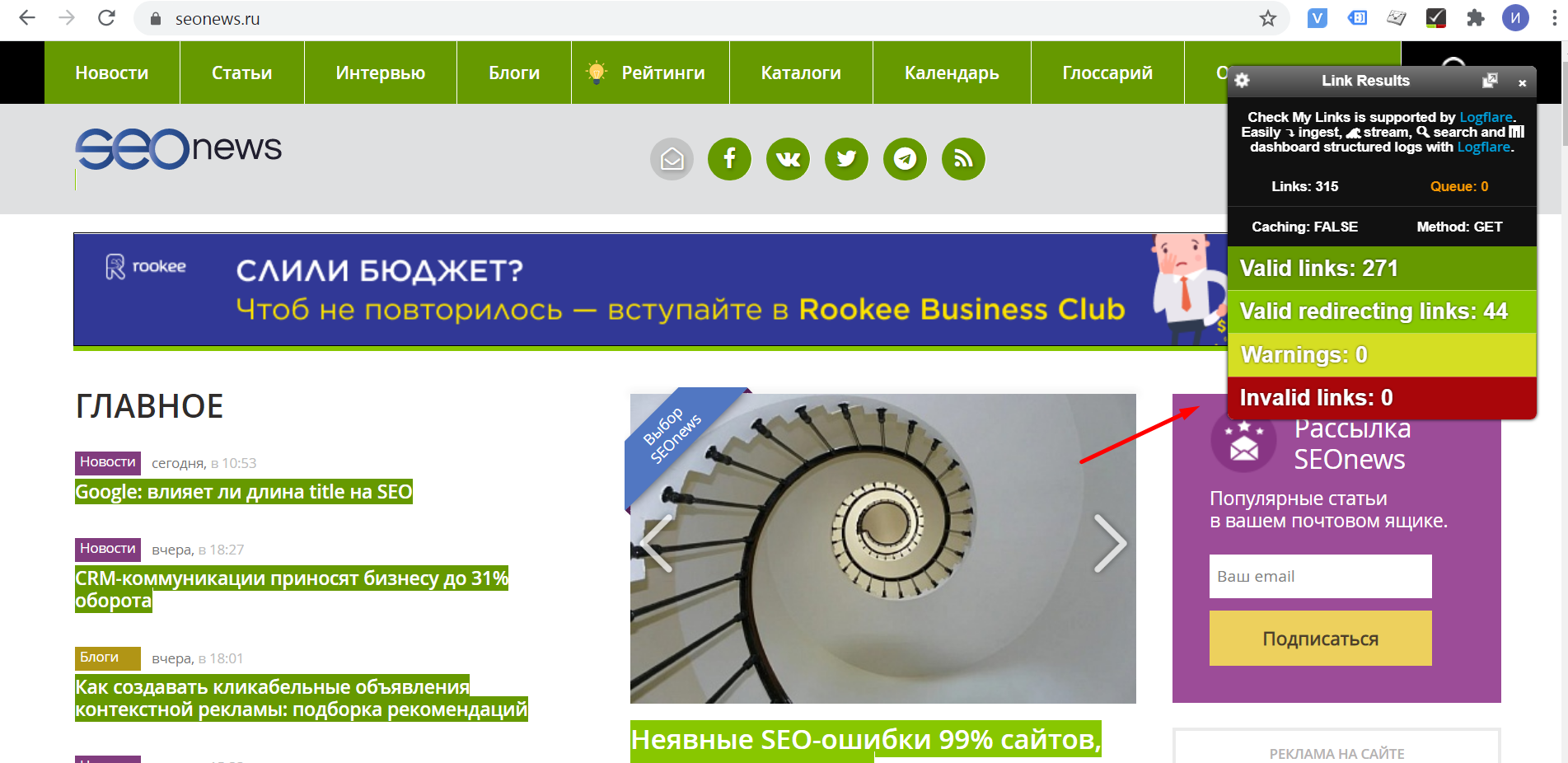

Check My Links

Бесплатный плагин для браузера Google Chrome, который находит битые ссылки. После установки откроется страница с настройками расширения. Здесь можно добавить домены для исключения, выбрать метод запроса и включить анализ ссылок с атрибутом nofollow.

Check My Links работает постранично. Откройте любую страницу, нажмите на иконку расширения в браузере и ознакомьтесь с результатами отчёта. Если в разделе «Invalid Links» пусто, значит на странице нет битых ссылок.

Поиск битых ссылок с помощью плагинов

Кроме десктопных программ и браузерных расширений можно проверить битые ссылки с помощью плагинов для CMS. Они уступают по возможностям мощным SEO-комбайнам вроде Netpeak Spider или Screaming Frog, но со своими задачами справляются.

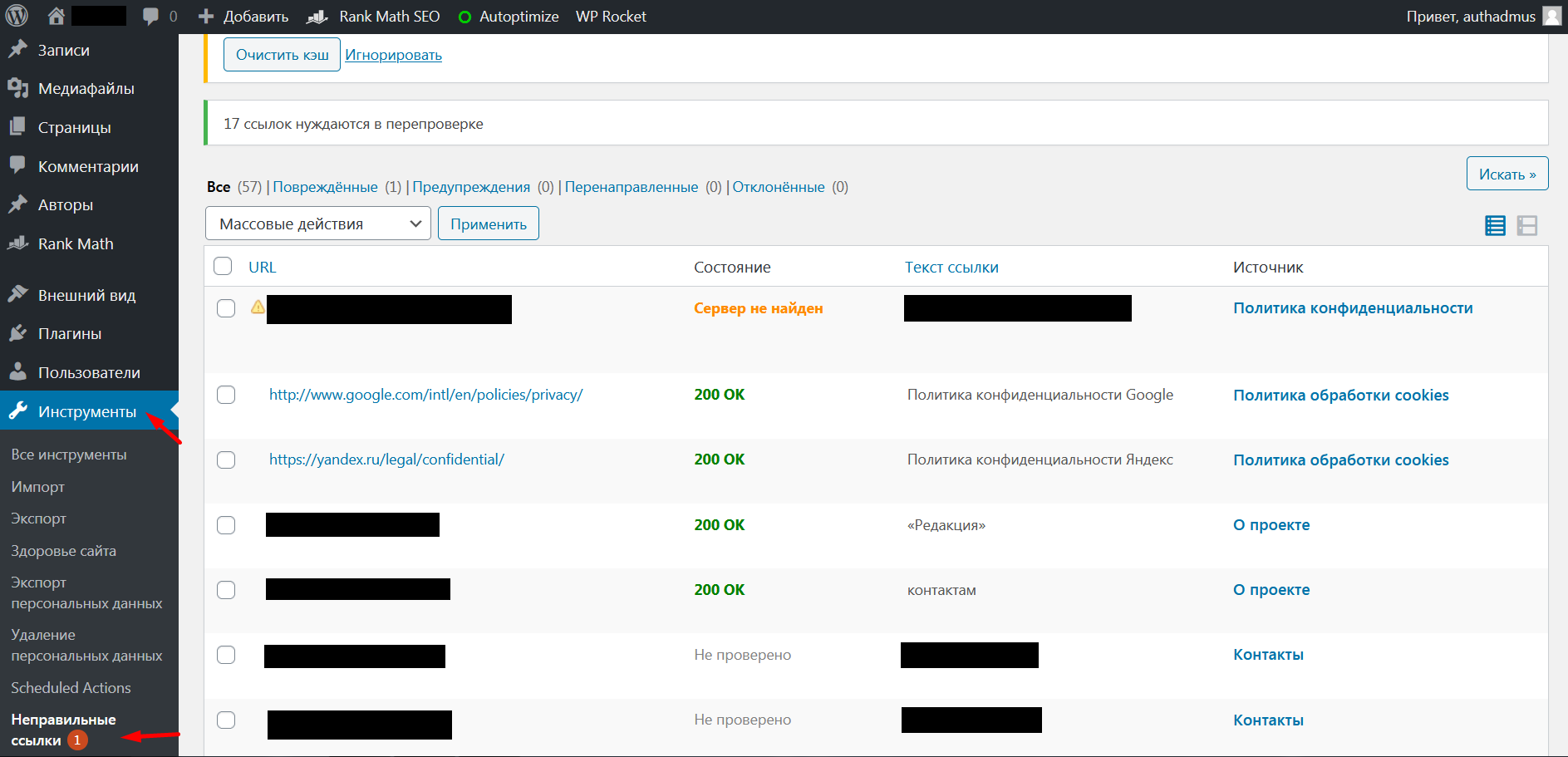

К примеру, для популярной CMS Wordpress есть плагин Broken Link Checker, который умеет находить внутренние и внешние битые ссылки в контенте. Он сканирует содержимое страниц и показывает проблемные ссылки с соответствующими статусами.

Информация о битых ссылках отображается в разделе «Инструменты» → «Неправильные ссылки». В настройках плагина можно настроить периодичность проверок и включить уведомления о проблемах по электронной почте.

Для других систем управления контентом существуют аналогичные плагины. Однозначно стоит воспользоваться ими, потому что даже самые популярные программы иногда не находят все битые ссылки. Аудит будет полезным только если пользоваться минимум двумя инструментами.

Как избавиться от битых ссылок

Найти и удалить битые ссылки иногда бывает сложно из-за ограничений систем управления контентом. Некоторые CMS генерируют несуществующие адреса и приходится ставить задачу программисту, потому что решить проблему штатными средствами не удаётся.

Если 404 ошибки появились из-за удаления страниц или технических проблем в плагинах для системы управления контентом, исправить битые ссылки не составит труда.

Самое главное — обнаружить все упоминания несуществующих страниц. В этом помогут инструменты из предыдущего раздела статьи. Лучше всего с задачей справляется Screaming Frog, поэтому если у вас небольшой сайт, можно остановиться на этой программе.

Внешняя битая ссылка

Не все вебмастера знают, что существуют внешние битые ссылки. Это не только упоминания сторонних сайтов в статьях, а и бэклинки с других ресурсов, ведущие на несуществующие страницы вашего проекта.

Они вредят сайту, потому что вес донора не передаётся акцептору. Если ссылка размещена на платной основе, а страница перестала открываться или переехала на другой адрес без редиректа, важно как можно быстрее исправить проблему.

Алгоритм действий для внешних битых ссылок:

- Определите источник размещения. Если покупали ссылку на бирже и не заметили, что вебмастер проставил неправильный адрес, необходимо связаться с ним.

- Попросите владельца проекта исправить URL.

- Если можно обойтись без участия оптимизатора, поставьте редирект с несуществующей страницы на актуальную.

Внешние битые ссылки в контенте вашего проекта тоже вредны. Пользователи могут кликнуть по адресу и при переходе на внешний ресурс увидят 404 ошибку. В итоге они потеряют доверие к сайту, который ввел их в заблуждение.

Screaming Frog и аналоги умеют находить внешние битые ссылки. Для этого необходимо воспользоваться соответствующими фильтрами и ознакомиться с результатами анализа.

Внутренняя битая ссылка

Удалить внутренние битые ссылки проще, чем бэклинки с внешних ресурсов, потому что есть доступ к административной панели сайта. Прежде чем избавляться от ссылок на несуществующие страницы, необходимо найти источник проблемы.

Варианты борьбы с битыми ссылками:

- Удаление линков. Откройте исходный код страницы, удалите элемент и сохраните изменения.

- Замена адресов. Если контент не удален, а просто переехал по другому адресу, измените URL на актуальный.

- Восстановление страниц. Если случайно отправили страницу в корзину, восстановите её, и битая ссылка исчезнет.

- Настройка редиректов. Когда нет доступа к исходному коду, можно настроить перенаправление через .htaccess или SEO-плагин.

Битые ссылки в малом количестве не влияют на рейтинг сайта в поисковых системах и позиции по конкретным запросам, но лучше если их не будет совсем. Проводите аудит сайта раз в месяц или чаще, чтобы вовремя заметить проблемы и оперативно от них избавиться.

Как удалить несуществующие страницы из индекса

Сейчас в Гугле нет глобальных проблем с индексированием контента, как 3-5 лет назад, когда апдейты происходили редко и несуществующие страницы могли долго присутствовать в выдаче. Но иногда поисковые системы добавляют в базу посадочные, которых на самом деле нет.

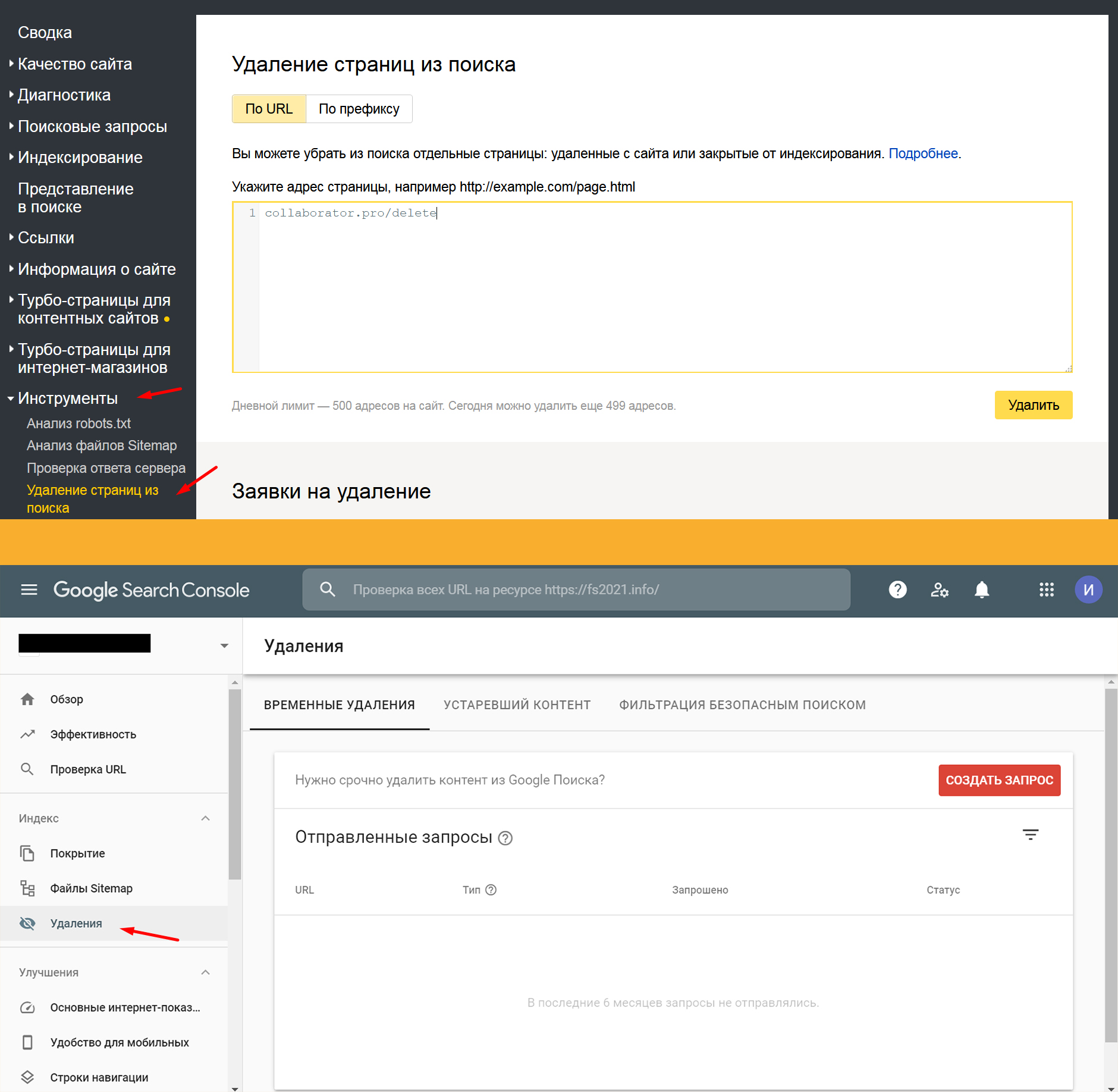

Удалить несуществующие страницы из поисковиков можно несколькими методами:

- закрыть страницы в robots.txt;

- использовать служебный тег <meta name="robots" content="noindex" /> для запрета индексирования;

- использовать инструменты для удаления страниц в консолях для вебмастеров.

Роботы поисковиков обычно не добавляют в индекс страницы, которые отдают 4xx ответ, но могут медленно удалять адреса, которые перестали быть актуальными и не подклеены к другим страницам. .

В этом случае им надо помочь — сделать запрос через соответствующие инструменты в Google Search Console. В Google за это отвечает вкладка «Удаления».

Оба инструмента работают примерно одинаково — можно удалить конкретный URL или адреса с префиксом. Если страница не закрыта от индексации или при обращении возвращает не 4xx ответ, страница может не пропасть из выдачи. Для проверки кода ответа сервера страницы или списка страниц можете воспользоваться нашим инструментом: Массовая проверка ответа сервера.

В статье мы разобрались, что значит битая ссылка, как проверить их на сайте и рассказали об эффективных методах борьбы с этим явлением. Используйте наши советы, чтобы решить стандартную задачу технического SEO.