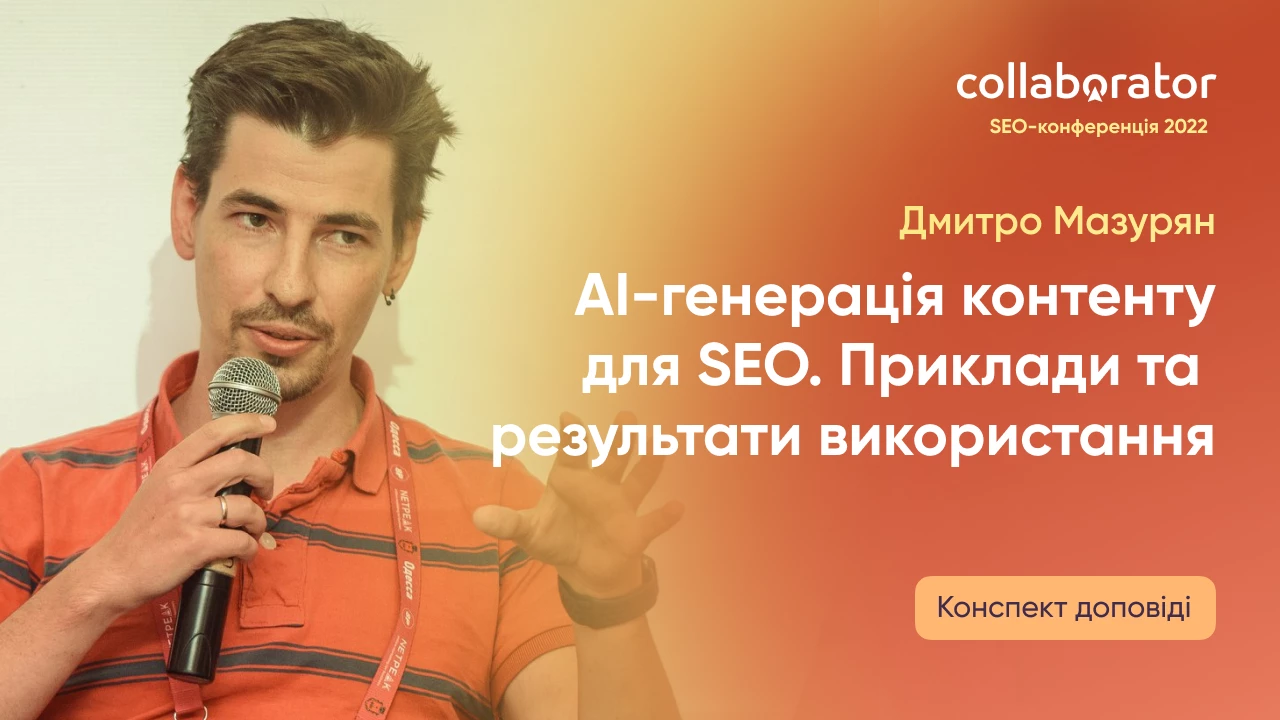

Дмитро Мазурян у доповіді на SEO-конференції Коллаборатора акцентував увагу на AI-генерації контенту. Вони в команді Tonti Laguna з 2020 року тестують цей спосіб створення текстів, тож спікер поділився досвідом з глядачами нашого заходу.

Так, Дмитро розповів про плюси і мінуси використання таких технологій, адже питання досі спірне. Швидкість чи якість? Для яких сторінок підходить такий текст? Чи треба допрацьовувати руками? І ще багато питань обговорюються у SEO-спільноті.

Звісно, доповідач зробив невеличкий огляд конкретних інструментів, якими користується його команда.

А ще: дав корисні поради для тих, хто вже практикує такий спосіб створення контенту чи тільки дивиться в його сторону.

Про спікера

Кілька показових та цікавих фактів про Дмитра Мазуряна:

- SEO займається з 2007 року;

- працює з інформаційними порталами, інтернет-магазинами та вузько-направленими сайтами під Україну та Захід;

- з 2016 року є частиною команди Tonti Laguna в Netpeak Group;

- з 2021 року керує проектом 42n в Tonti Laguna, що займається створенням та просуванням сайтів.

- любить автоматизацію, ресерчі та різні API.

Далі — доповідь зі слів Дмитра👇

Як працює AI-генерація текстів: трохи історії та теорії

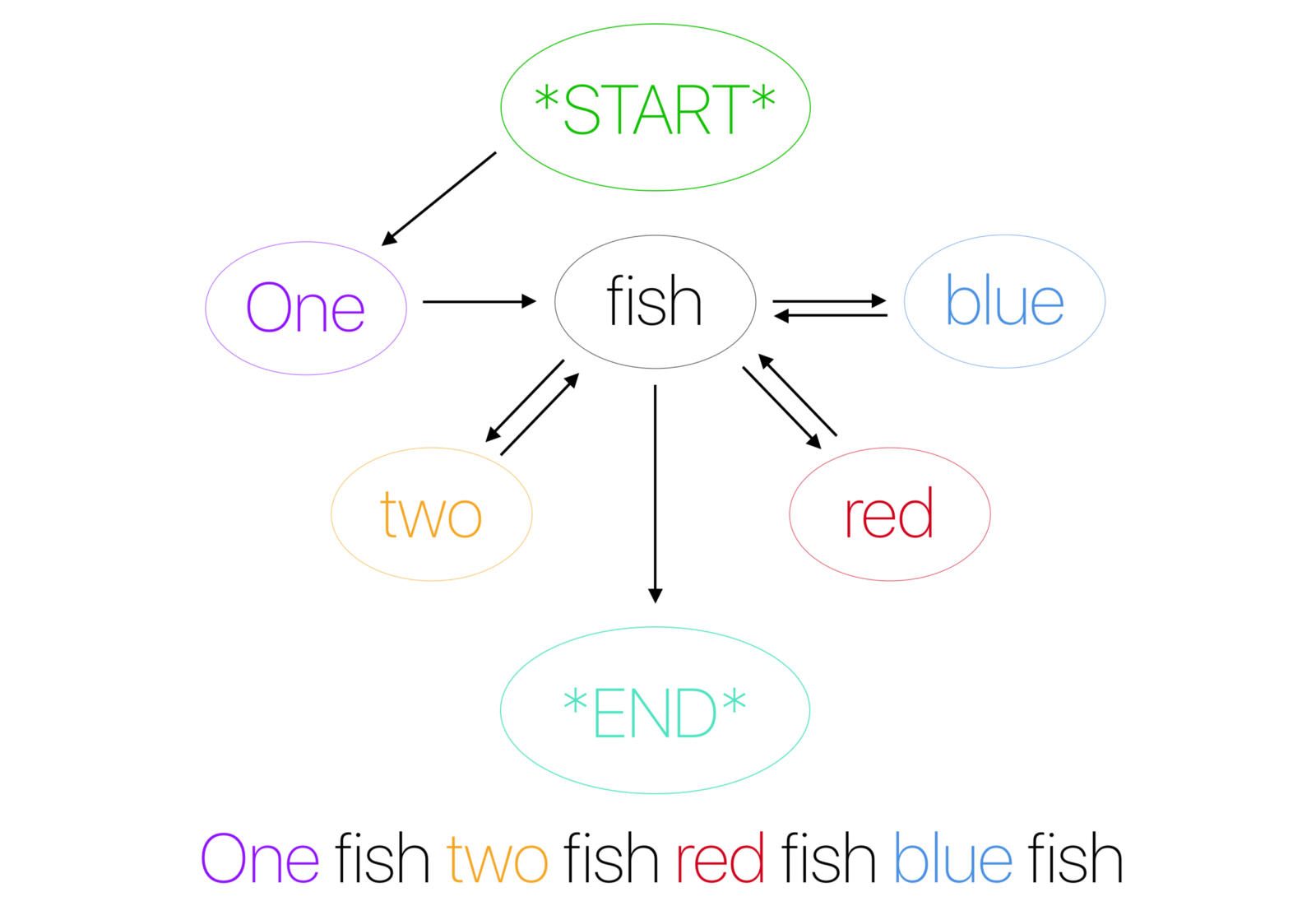

SEO-генерація текстів існує дуже давно. Ще в 2010 році існував інструмент Red.Button.Transformer, який генерував дорвеї. І там була функція генерації текстів за допомогою ланцюгів Маркова. Цей алгоритм вважає кожне слово за окремий об’ект, і враховує ймовірність, що після цього слова буде якесь інше. Наприклад, якщо в нас слово «будь», то скоріш за все наступне буде «ласка». Для слова «добрий» наступним буде або «ранок» / «день» / «вечір», або «дядя».

Справжній прорив зробила модель Generative Pre-trained Transformer (GPT), яка також передбачає наступне слово. Але, на відмну від ланцюгів Маркова, вона за основу бере весь текст.

Тобто вона передбачила якесь слово, і для передбачення наступного слова система використовує вже весь текст разом з минулим словом. І таким чином текст, що генерується, завжди тематичний, завжди в контексті того, що було раніше. І це і є та крута фіча, яка дозволяє GPT генерувати тексти, що можна читати і які відповідають вимогам до тематичності.

Вся модель не дуже і нова, було декілька поколінь:

|

Model |

Parameters |

Context Token Size |

Dataset Size |

|

GPT |

117M |

512 |

|

|

GPT-2 |

1.5B |

1024 |

40 GB |

|

OpenAI GPT-3 (ada-001) |

2.7B |

2048 |

570 GB |

|

OpenAI GPT-3 (babbage-001) |

6.7B |

2048 |

570 GB |

|

OpenAI GPT-3 (curie-001) |

13B |

2048 |

570 GB |

|

OpenAI GPT-3 (davinci-002) |

175B |

4096 |

570 GB |

|

GTP-J |

6B |

2048 |

Pile (800 GB) |

|

GPT-NeoX-20B |

20B |

2048 |

Pile (800 GB, newer) |

|

AI21 Jurassic-1 Large |

7.5B |

2048 |

Pile (800 GB) |

|

AI21 Jurassic-1 Jumbo |

178B |

2048 |

Pile (800 GB) |

Вона еволюціонувала від того, що просто ставала складнішою. Якщо в першій моделі було 118 мільйонів параметрів, то в останій — 175 млрд. І датасети, тобто той текст, на якому вона «тренувалася», ставав все більший і більший. У сучасних моделях цей датасет важить 800 ГБ.

При цьому він має свої недоліки:

- Різні мови та стилі мовлення. В датасетах зустрічаються як тексти класичної літератури, так і якийсь сленг с сайтів, форумів, які спарсились. Це може бути неякісна література, неякісні тексти, які зустрічаються в субтитрах. У Вікіпедії також немає контролю за якістю англійської чи якоїсь локальної мови. Усе це впливає на результат.

- Багато застарілих даних та текстів з різних епох. Наприклад, всі ці моделі не знають про смерть Єлізавети ІІ чи про початок повномасштабного вторгнення російської федерації на терени української землі. А на запит «ремонт човна» може згенеруватися інформація з даних з минулого століття (якщо, приміром, були відскановані історичні книги)

Попри ці недоліки такі системи створюють тексти, які ми використовуємо в SEO.

Плюси і мінуси AI-генерації контенту для SEO

Узагальнено переваги та недоліки такого методу контентмейкінгу можна представити так:

|

Переваги |

Недоліки |

|

+ Це супер швидко |

— Зазвичай якість текстів «не дуже» |

|

+ Сильно дешевше «ручної праці» |

— Тексти треба рерайтити / доробляти руками |

|

+ Є можливості автоматизації |

— Треба інженери / програмісти при масштабуванні |

|

+ Формується новий ринок |

— Багато «підводного каміння» |

|

|

— SEO додається руками |

|

|

— Погані результати для більшості мов |

Також можемо виділити типи матеріалів, для яких AI може написати текст, а для яких — ні.

|

Підходить |

НЕ підходить |

|

+ Простенькі FAQ та списки |

— Повноцінні великі статті з різноманітною структурою |

|

+ Парафразінг шматками |

— Корисний YMYL-контент |

|

+ Водянисті статті «про все і ні про що» |

— Одразу оптимізовані тексти |

|

+ Шаблонні тексти (опис товару, policy texts, about us) |

|

|

+ Фейкові діалоги та комментарі |

Що каже Google

Коротко скажемо про політику пошукових систем з щодо генерованого контенту. На прикладі Google бачимо, що вони активно працюють над виявленням автоматично згенерованих текстів. Ось кілька тез із політики антиспаму:

- Текст, який не має сенсу для читача, але містить ключові слова пошуку

- Текст, перекладений автоматизованим інструментом без перевірки персоналом або рерайтом перед публікацією

- Текст, створений за допомогою автоматизованих процесів без урахування якості чи взаємодії з користувачем (наприклад, Ланцюгами Маркова)

- Текст, створений за допомогою автоматизованих методів синонімізації, перефразування або обфускації

- Текст, створений із копіювання каналів або результатів пошуку

- З’єднання або об’єднання вмісту з різних веб-сторінок без додавання достатньої цінності

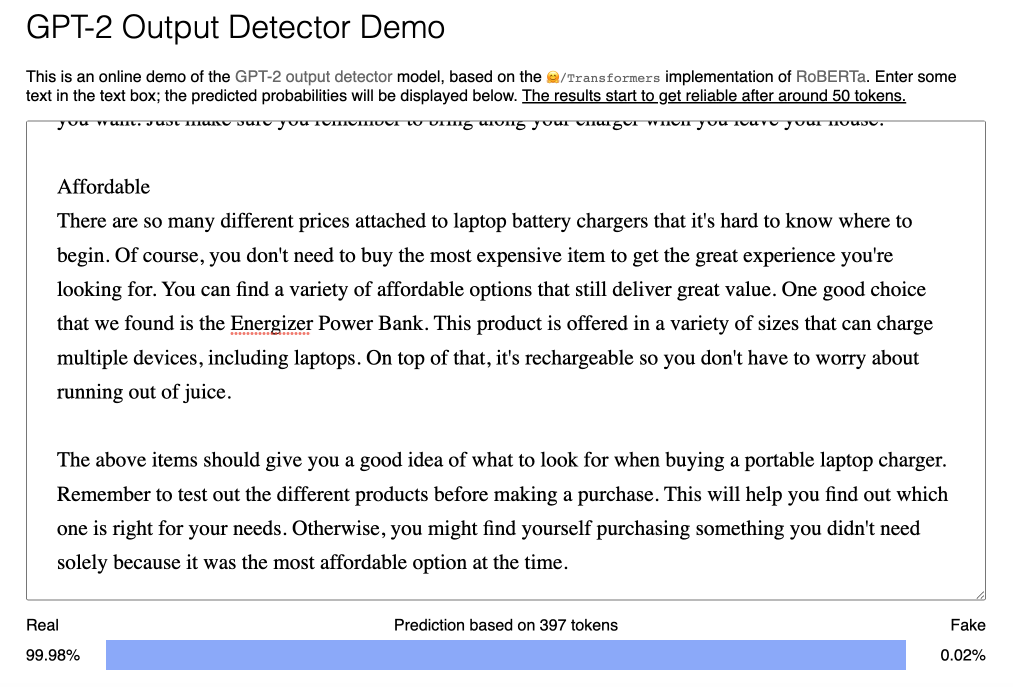

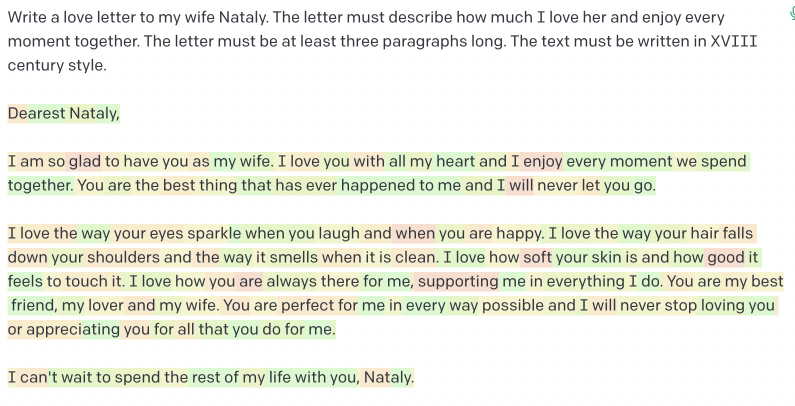

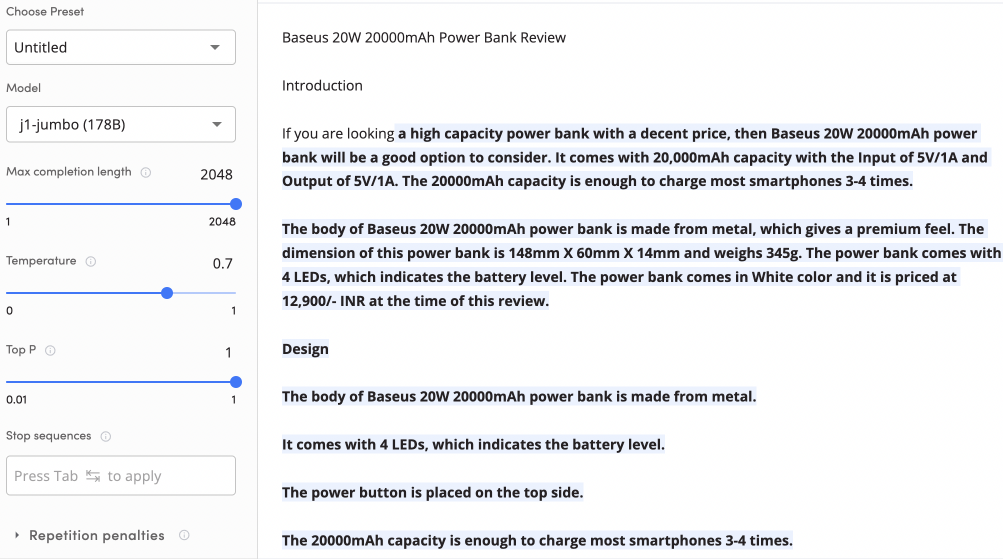

При цьому використання таких моделей як GTP3 дозволяє готувати тексти, які доволі складно відризнити від натурального. В інтернеті існує багато всяких інструментів, які наче можуть знаходити такі тексти. Але наші тести показують, що не завжди вдається. Нижче на скріні інструмент показує, що цей текст 100% реальний, хоча насправді він був сгенерований.

Ми думаємо, що й Google так само важко на 100% відрізняти штучні тексти від реалістичних. Тому і генеруємо.

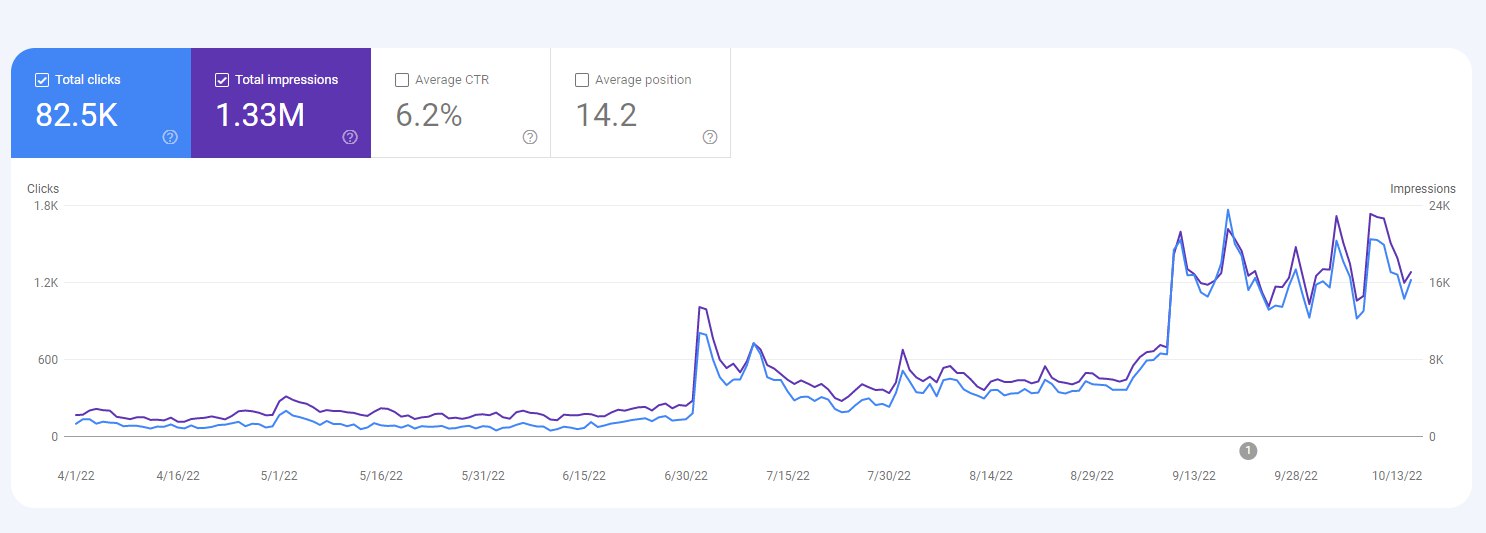

Покажемо пару результатів

- приклад статистики одного з експериментальних сайтів, де просто весь контент генерований, запощений на сайт без ніякого рерайту.

- Приклад статистики прибуткового сайту, де також все сгенероване, проте з незначним рерайтом

Може скластися почуття, що все — треба генерувати, що це є та кнопка БАБЛО, яку всі SEO-вці шукають вже років 20

Але насправді все не зовсім так. І ситуація реальна відображена в таблиці з плюсами та мінусами штучного генерування контенту👆

Інструменти для штучної генерації контенту

При зверненні до цього методу створення контенту треба шукати варіанти, які підходять саме вашим проєктам. Ми такі рішення знайшли, і я розкажу, що ми використовуємо для того, щоб роботизовано створювати тексти для наших сайтів. Ми це вже робимо давно і багато, тому я розкажу про ті інструменти, які реально використовуємо в роботі.

OpenAI

Ми одні з перших почали тестувати. Уже два роки користуємося цим інструментом. Було багато випробовувань, очікувань, були і фейли. Але з тих часів ми лише більше і більше використовуємо всі ці інструменти, що надає нам OpenAI.

Що використовуємо

Конкретно юзаємо модель davinci-002, яка як раз прогнозує наступні слова. Тобто ви задаєте початок, якусь фразу або речення, і алгоритм його продовжує. У нас заготовлених промптів (підказок, початку), вже більше сотні. За допомогою них ми готуємо різні тексти для різних сайтів.

Переваги:

+ Великий текст на виході (найбільший в порівнянні з іншими моделями)

+ Найкраща якість текстів

+ є API

Недоліки:

— Треба продумувати початок текстів

— Не найшвидша модель

— Не найдешевша модель

Ще одна модель — davinci-instruct-beta. Тут заготовлених промптів близько сорока. Тексти генеруються за ТЗ, і результат схожий на очікування. Серед недоліків: все таки не найкраща якість текстів, швидкість та ціна.

Переваги та недоліки OpenAI

На даний момент ми більше 60% текстів генеруємо завдяки OpenAI.

Головне правило при роботі зі штучним алгоритмом, як у в справжньому житті: чим краще ви створили ТЗ, тим краще буде результат.

Узагальнено плюси та мінуси OpenAI можна представити так:

|

Плюси |

Мінуси |

|

Швидка генерація текстів |

Тексти треба рерайтити |

|

Не погана якість текстів |

Складно виконувати SEOшні вимоги |

|

Ціна. В середньому $0.67 за текст в 5 тис. слів |

Ліміт витрат на місяц - $120 |

|

davinci-instruct-beta |

|

|

Можливість тюнувати під себе (обмежено) |

|

|

Наявність зручного API |

Serpstat

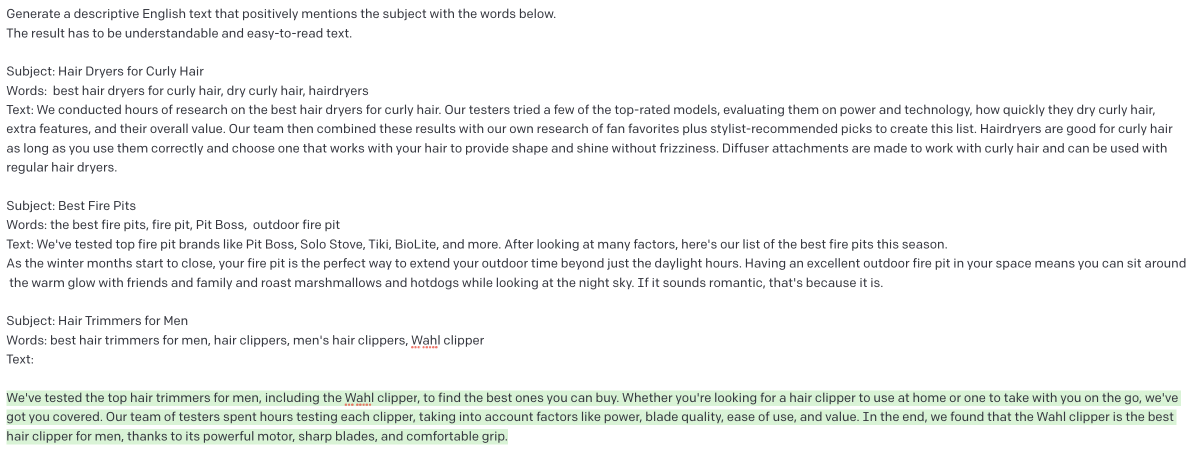

Інструменти Serpstat Article Generation, та Article Builder та Paraphrasing — це інструменти, який ми використовуємо в роботі для генерації текстів. Це тестові тули від Serpstat із розділу ТестЛаб.

Що використовуємо

Article Generation генерує статті за назвою.

Тобто на вході ви даєте назву статті, яку хочете отримати, і от алгоритм видає текст. Якщо чесно, я був здивований, яку гарну якість текстів інструмент дає на виході. Я говорю про різноманіття унікальних слів, складність речень, водність, повтори. Краще порівняно з OpenAI.

При цьому ви обмежені в тому, як пояснити системі, про що ви хочете отримати текст, який він повинен бути за структурою і таке інше. Це дуже великий недолік. І генерація значно повільніша, ніж те, що робить OpenAI.

Article Builder — дуже крута штука. Тут ви на вході задаєте семантику, набір ключових слів, і алгоритм далі пропонує назву, структуру, і за цією структурою генерує по розділу текст. Але генерує його не сам по собі, а також орієнтуючись на те, що було вже сгенеровано до цього. Алгоритм також намагається вставляти ключові слова з тієї семантики, яку ви використовували на початку.

Таким чином ви отримуєте прикольний текст зі своєю структурою, і вам для роботи треба мати лише ключі. Виходить дуже класно, і я думаю, що це один з варіантів того, як будуть для сеошників розвиватися подібні інструменти.

З недоліків: порівняно повільно + немає АPI.

Paraphrasing. З допомогою інструменту можна робити рерайтинг, перенаписання тексту або його шматочку.

Якість текстів на виході гарна, але ви обмежені тим, що маєте на вході лише 750 символів тексту, що значно обмежує роботу з текстом.

Переваги та недоліки Serpstat

Десь третину наших текстів або генеруємо, або оброблюємо за допомогою інструментарію від Serpstat, бо якість текстів тут гарна. У таблиці — основні плюси та мінуси.

|

Плюси |

Мінуси |

|

Чудова якість текстів |

Доволі довга генерація |

|

Article Builder |

Обмеження в налаштуваннях |

|

Входить в вартість тарифу Serpstat |

Складно виконувати SEOшні вимоги |

|

Регулярна поява нових функцій |

|

|

API |

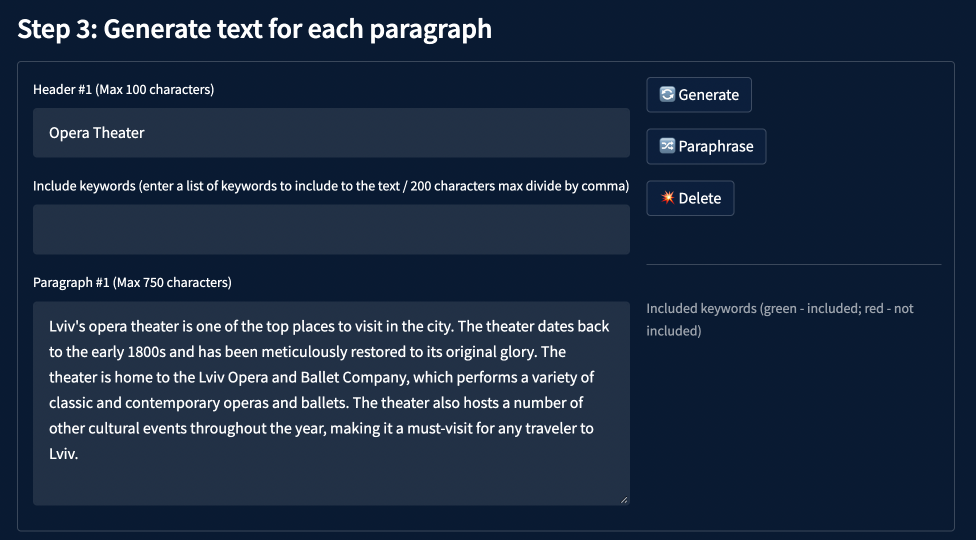

AI21

Ми почали використовувати AI21 як альтернативу OpenAI.

Що використовуємо

Модель j1-jumbo (178B). Тут інтерфейс та функціонал майже такий самий. Система генерує більш-менш нормальні тексти, які можна потім рерайтити, і використовувати реально. Але все одно, якість поступається тому, що є в OpenAI, і чесно кажучи, значно дорожче. На перших порах ми були впевнені, що вони просто використовують АПІ Опен АІ, але порівнюючи результати, зрозуміли, що ні, що в них все своє.

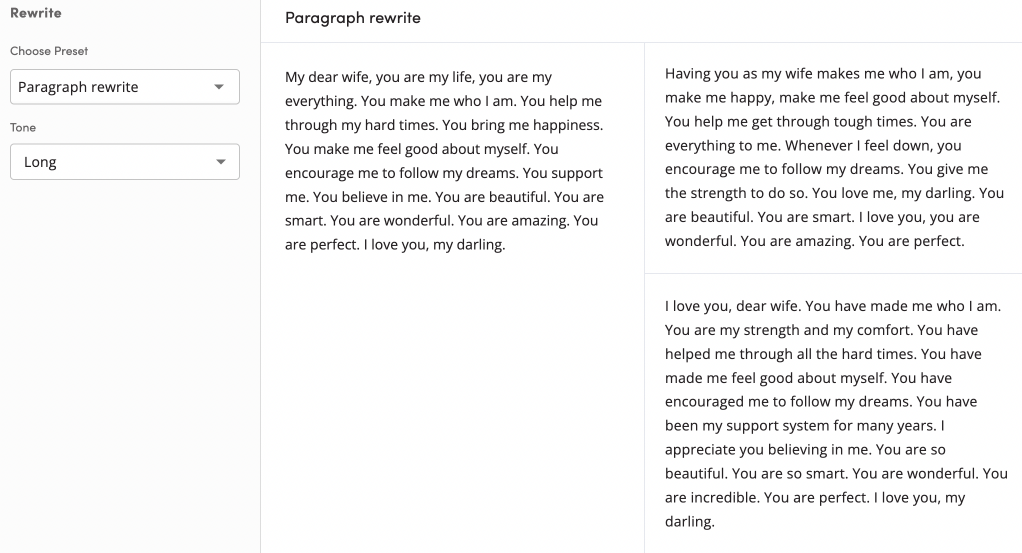

Друга модель, яку ми використовуємо, це Rewrite. Вона прикольна тим, що значно дешевша. Вона оброблює наші проблемні абзаци, переписує їх якось інакше, і дає одразу декілька результатів. Близько 5% текстів ми генеруємо тут.

Переваги та недоліки AI21

Основні моменти представлені тут

|

Плюси |

Мінуси |

|

Інтерфейс як у OpenAI |

Доволі довга генерація |

|

Є безкоштовний тріал |

Тексти точно треба рерайтити |

|

Датасет новіший, ніж в OpenAI |

Дорого |

|

Є своя instruct-модель. Хоч і не вогонь |

Нестабільна робота сервісу |

|

API |

Складно виконувати SEOшні вимоги |

Саме цими трьома сервісами переважно користуємося для генерації текстів. А також юзаємо додаткові інструменти для точкових задач із зображеннями:

- OpenAI DALL-E 2

- Midjourney 4

Практичні напрацювання та поради

На основі нашого досвіду вивели кілька порад та рекомендацій, які можуть допомогти вам ефективно налагодити процес AI-генерації контенту:

Користуйтеся відкритими джерелами

В ютубі зараз найбільше корисної інформації про генерацію: від просто статей з поясненями до форумів, підкастів тощо, більш живих та актуальних форматів.

Відпрацьовуйте промпти

Адже хороша заготовка значно збільшує якість результату. Якщо ви хочете отримувати тексти бажаної якості, треба дуже багато відпрацьовувати ці вхідні заготовки.

Лайфхак: якщо треба зробити статтю про щось нове (про те, чого ще не було, коли створювався датасет), то ви можете на початок просто закинути сторінку з Вікіпедії. Наприклад, якщо треба сгенерувати текст про iPhone 14, то ви можете просто взяти декілька оглядів (лише кінцеву частину, де висновки) і поставити на початок. Система вже знає, які були відмінності у минулих моделей, і зробить вам нормальний текст про 14ту версію.

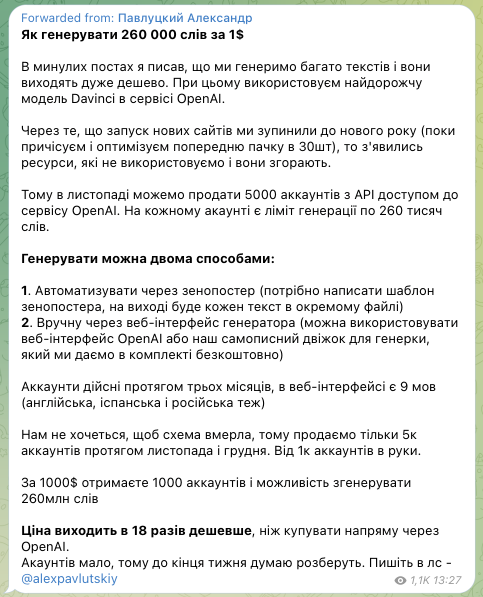

Заводьте більше аккаунтів OpenAI

Можна реєструвати нові акки (на молдавські номери нормально працює), а можна купляти. Про це говорив Олександр Павлуцький в пості Телеграм.

Автоматизуйте та комбінуйте

Складні програмні комплекси дозволяють значно поліпшити результати. Використовуйте парафразінг, синонімізацію, стилізацію, генерацію частинами. Кожне наступне допрацювання тексту можна робити за допомогою тих самих інструментів, тільки інших їх функцій.

Тестуйте різні інструменти

Скористайтеся, наприклад, нашим безкоштовним інструментом Simple Text Validator. Він знаходить дублі речень та дублі слів в одному речені, нормалізує спамність та дозволяє аналізувати текст по абзацах. І це дуже пришвидшує процес рерайтингу, пошуку проблемних моментів.

Не забувайте про ризики

Постійно дбайте про перевірку якості сгенерованого контенту перед публікацією. Адже алгоритми вдосконалюються і згодом зможуть з більшою ймовірністю виявляти текст, не людиною створений.

Питання — Відповідь

А чому Вас тривожать 301? Пошукова система ж не зовсім дурна. Вона може первірити ці URL декілька разів, а потім не звертати на них уваги (частіше всього. Якщо, наприклад, на цей 301 не зʼявляється купа зовнішніх посилань чи щось аналогічне). Можна перевірити через логи сервера.

Дивлячись у яку компанію (чим вона займається та в якій країні зараз знаходиться). Наскільки я знаю, то зараз у багатьох компаніях рецесія та пауза на набір. Окрім тих, що працюють на досить сталі ринки, як США.

З мого досвіду скажу, що зараз прям НАЙВАЖЛИВІШЕ не стільки SEO, скільки

а) знати мову. Наприклад, англійську як стандарт, а краще ще одну якусь.

б) вміння працювати асинхронно, а отже вміти самоорганізовуватися, вміти писати документації, оформлювати задачі, висловлювати думки.

в) SEO — це практика, а тому дуже круто, коли ви вмієте записати гіпотезу (наприклад, зміна цього title дасть нам такий-то результат) і потім підбити підсумки тесту і таким чином зібрати «бібліотеку» змін.

А так вистачить знань, наприклад, з курсу Артема Пилипця на Youtube + практики десь на фрілансі чи з проектом своїх родичів.

Якщо вийде, то непогано джуну піти в агенство. Там часто можна швидко отримати досвід.

Якщо правильно реалізувати мультимовність, то буде і так «органічна» перелінковка. Нагадаю, що для мультимовності потрібно звʼязати мовні версії використовуючи тег link alternate hreflang. Як це зробити

Можна використати http header link hreflang (але потрібно вміти за цим слідкувати) і круто було б використати sitemap xml. І не забувайте про двосторонність звʼязку.

АЛЕ. Ми ж окрім цих правил забуваємо ще про те, що бажано б було використати у перемикачі мовних версій a href посилання (ваша випадайка чи прапорці через які ви вибираєте мову). Таким чином вийде «органічна» перелінковка один до одного.

Спеціально ставити посилання, наприклад, з тексту української версії на англійську версію немає ніякого сенсу. Ні для користувача, ні для пошукової системи. І того стандарту, що виписав вище, вистачить.