SEO для iGaming: стратегії просування онлайн гемблінг-ресурсів від Алекса Топала

Спробуйте Collaborator.pro

Виберіть із 36199 високоякісних веб-сайтів і 3412 Telegram каналів

ВпередIGaming — сфера досить динамічна та популярна, однак просування сайтів у цій ніші має специфічні особливості. У доповіді на вебінарі 16 липня 2024 Алекс (Олександр) Топал розповів чимало цікавого: і про апдейти, що сколихнули видачу Гугла за останній період, і про їх наслідки на прикладах різних проєктів, і про Google Leaks та що корисного можна з цього почерпнути. Доповідь вдалась настільки потужною та пізнавальною, що її називають справжнім відкриттям вебінарів Collaborator.

Відео та презентацію спікера знайдете в архіві вебінарів👈

Ми ж підготували корисний конспект із розгорнутими відповідями по тезах доповіді.

Про спікера

Кілька цікавих фактів про Олександра:

- Працює в SEO з 2012 року, має 12+ років досвіду успішної розробки та реалізації SEO/SEA стратегій, кампаній в США, ЄС, Канаді, Латинській Америці, Азії та країнах СНД.

- Експерт у нішах Enterprise SEO, e-commerce, телемедицини, iGaming та Crypto, фінтех, локального бізнесу, Saas та кібербезпеки.

- З 2018 працює на Західні ринки.

- Офіційний спікер Kyiv iGaming Affiliate Conference, World Affiliate Show 2021 та ZM CONF 4.

Офіційні сторінки спікера:

Далі — конспект доповіді зі слів спікера👇

Що відбувається у сфері iGaming: апдейти в дії

За останні шість місяців волатильність пошукової видачі була настільки динамічною, а зміни відбувалися настільки часто, що складно пригадати щось подібне загалом за останні 12 років. Раніше Google анонсував лише один-два апдейти на рік, а зараз — водночас і кілька значних Core, Spam та інших апдейтів.

Усе почалось іще восени минулого року з оновлення корисного контенту — Helpful Content Update (HCU), а також Reviews Update. Вони сильно вплинули на позиції багатьох сайтів. В результаті ми бачили, як численні ресурси втрачали місця та вилітали за топ 30 та навіть за топ 100 видачі.

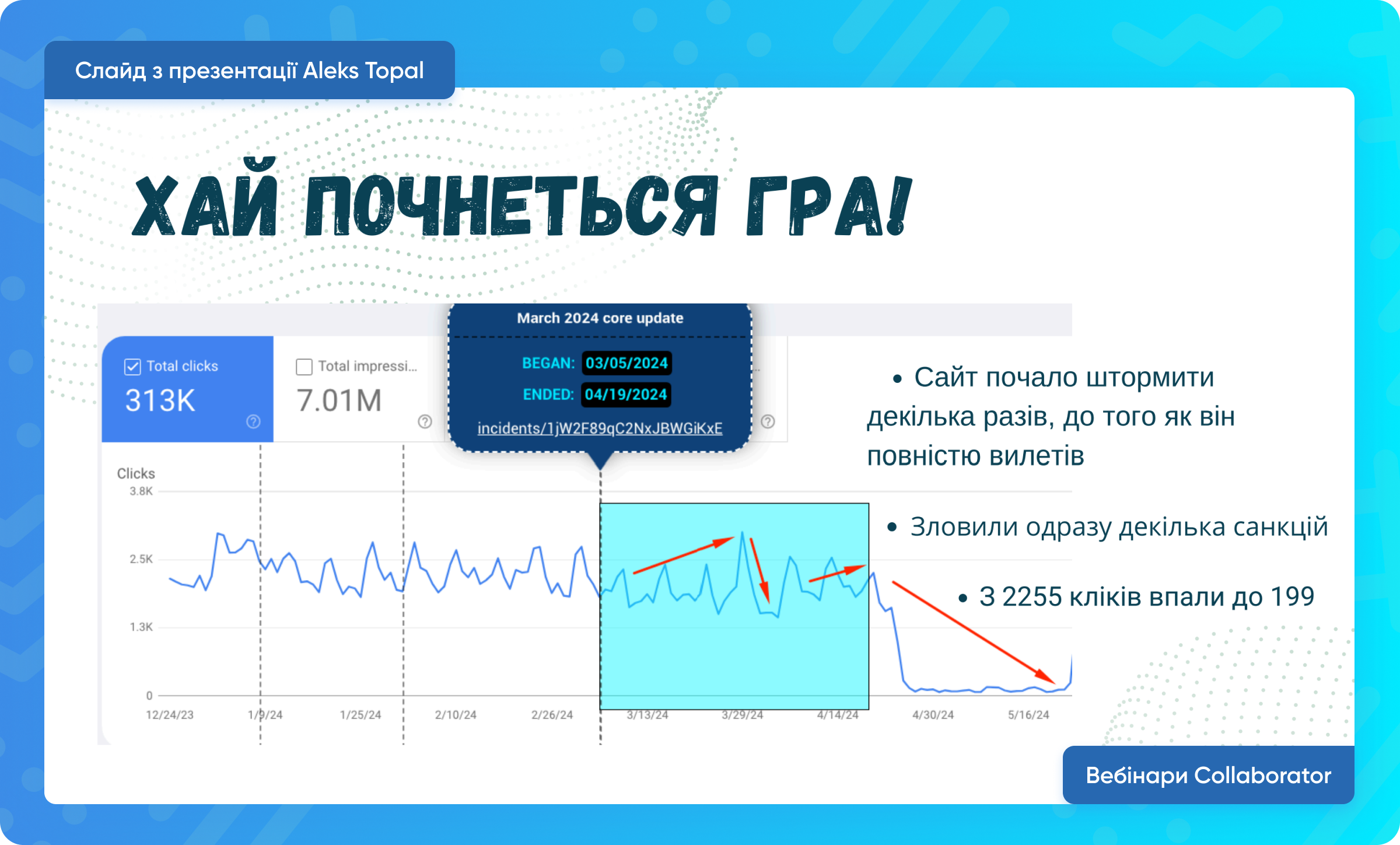

В одному з наших проєктів ми теж помітили такі зміни. Восени 2023 року зафіксували певне падіння трафіку, але загальна тенденція залишалася стабільною. Ми отримували близько 2 тисяч кліків на день для сайту, що працює на кілька країн.

У березні з початком Core та Spam апдейтів ситуація різко змінилася. Сайт почало «штормити», декілька разів він виходив, а потім взагалі випав з пошукової видачі. З 60-70 тисяч трафіку ми почали отримувати 100-200 кліків на день

У березні з початком Core та Spam апдейтів ситуація різко змінилася. Сайт почало «штормити», декілька разів він виходив, а потім взагалі випав з пошукової видачі. З 60-70 тисяч трафіку ми почали отримувати 100-200 кліків на день

Що з цим робити, розповім детальніше згодом. А зараз трохи про те, як апдейти імплементувались в пошукову систему і що з цього вийшло.

Еволюція ранжування

Почнемо з Helpful Content Update (HCU). З оновленням ядра в березні 2024 року Google вбудував систему корисного контенту у свою основну систему ранжування. Це означає, що старого класифікатора HCU більше немає і більше не буде оновлень корисного контенту. Це викликало велику плутанину серед власників сайтів, на яких вплинув вересневий HCU у 2023 році, коли багато сайтів почали втрачати позиції або взагалі випали з пошукової видачі. Значна кількість вебресурсів замаркувались.

Окрім цього, викотили Spam апдейт, що був націлений на виявлення:

- Зловживання простроченими доменами. Багато стратегій, особливо в секторі iGaming, будувались на використанні прострочених доменів з хорошим пошуковим профілем, таких як .gov, .edu або регіональні сайти. Мати такий домен означало 50-60% успіху на початку. Достатньо було лише створити гарну структуру, додати контент і трохи попрацювати над лінкбілдингом.

- Масштабного зловживання контентом, особливо згенерованим AI, для маніпулювання рейтингом. В цьому випадку стратегії були такі: взяти фронт, нагенерувати довжелезний текст, викатити — і цього було достатньо, щоб отримувати хороші позиції або для оновлення кількості сторінок в індексі.

- Зловживання репутацією сайту. Йдеться про паразитне SEO, де новинні сайти просто давали підпапки для розміщення статей, що дозволяло швидко заходити в топ без дропів завдяки авторитетності та трасту домену.

Я проаналізував понад 100 сайтів і взяв вибірку основних ресурсів, які постраждали.

Ці сайти маркувалися з вересня 2023 го року, і коли викатився HCU — це був перший крок до того, що після наступного апдейту вони підуть в нікуди

Ці сайти маркувалися з вересня 2023 го року, і коли викатився HCU — це був перший крок до того, що після наступного апдейту вони підуть в нікуди

Ситуація на ринках Америки та Європи підтверджує це: 80-90% сайтів, які просіли, так і не змогли відновитися. Причина в тому, що їхня стратегія була спрямована на заробіток, а не на створення корисного контенту для користувачів.

Так, є сайти, які дійсно створювали якісний контент і теж постраждали, але мова йде про тих, хто маніпулював видачею. Google активно працює над тим, щоб «вибити» таких гравців з ринку, і це стосується не лише локальних iGaming структур, але й фінтеху та криптовалют. Водночас Google підтримує брендові та e-commerce сайти. Їх практично не зачепило і навіть більше — деякі зросли в рейтингах. Отже, важливо розуміти логіку: чому це відбулось, які висновки ми можемо зробити і як рухатись далі.

Ось, наприклад, на скриншоті з Ahrefs видно, як сайт з 80к кліків знизився до 10-15к:

Ми зловили одразу декілька фільтрів і санкцій, при тому, що це дуже великий рев'ю сайт, в індексі якого більше 10к сторінок, сам домен досить авторитетний — з 2000-х знайомий Гуглу, і займав до випаду дуже гарні позиції по тисячах запитів

Ми зловили одразу декілька фільтрів і санкцій, при тому, що це дуже великий рев'ю сайт, в індексі якого більше 10к сторінок, сам домен досить авторитетний — з 2000-х знайомий Гуглу, і займав до випаду дуже гарні позиції по тисячах запитів

Це той випадок, де ми реально бачимо, як працює Гугл. Навіть такі сайти, в які вкладається дуже багато ресурсів, контенту, лінкбілдингу, не застраховані ні від чого.

Фактично з початку березня і всю весну я займався пошуком різних методів, як з цього виходити. Що у нас вдалось, читайте далі.

Gambling Road Map

Загальна стратегія роботи з такими випадками, про які говорили вище, представлена у такій собі Road Map — Дорожній карті. Вона містить основні вектори руху, які допоможуть збільшити конверсії, час перебування на сайті тощо.

Серед основних напрямків — аналіз ринку та конкурентів, лінкбілдинг, створення контенту, технічка. Кожен із них містить детальні кроки для впровадження

Серед основних напрямків — аналіз ринку та конкурентів, лінкбілдинг, створення контенту, технічка. Кожен із них містить детальні кроки для впровадження

У кожному напрямку потрібно визначити, що вже зроблено, а що потребує допрацювання. Сюди входять різні завдання:

- аналіз конкурентів;

- створення технічних завдань на імплементацію різних блоків, сайдбарів, фільтрів, CTA тощо;

- технічка — за допомогою кроулів, Ahrefs, Screaming Frog, Search Console фіксуємо всі проблеми, індексація старих і нових сторінок має працювати коректно, а сайт завантажуватись максимально швидко;

- робота над контентом — написання статей, що чітко відповідають на інтент користувача.

Лінкбілдінг стає ефективнішим, коли внутрішня оптимізація на високому рівні і ми розуміємо наші процеси. При цьому важливо використовувати білі стратегії просування, такі як гест постинг, аутріч, крауд-маркетинг тощо. На додачу скажу, що фрі посилання та TIER2 стратегії вже відходять. Але це гарно працює на аутрічі для підвищення їх трастовості та покращення видимості для Google.

У сфері iGaming популярною стратегією є використання дроп доменів та створення сіток сайтів, які будуть допомагати основним флагманам, неважливо, чи це монобренди, чи великі рев'ю сайти. Все залежить від реальних цілей, бюджетів, вектору руху компанії та перспектив на пів року, рік і так далі.

Пам'ятайте, що ключовою є адаптивність. Щось може не спрацювати, тому дуже важливо перевіряти ефективність кожного блоку, виявляти, де і що не працює, як це можна зробити по-іншому та адаптувати свою стратегію для отримання реальних результатів, а не просто зливу бюджету намарно.

Пошук і аналіз дропа

Стратегії пошуку та аналізу дропів:

1. За входженням імені/ключа в домен. Можу порекомендувати DomCop, Seo.domains, SpamZilla, Bluechip Backlinks. Більше корисних сервісів шукайте в презентації.

2. За посиланнями:

- Сайти з топу з посиланням на дроп. Ця стратегія включає збір та аналіз посилань конкурентів за допомогою парсера. Вивантажуйте всі отримані дані і слідкуєте за тим, які дропи взагалі є, коли вони будуть вільні, і робите собі сповіщення в Google-календар. Таким чином, ви вже на майбутнє розумієте що у вас є можливість «урвати» цікавіший дроп.

- Дропи, які посилаються на конкурента (lost domains in Ahrefs). Їх теж можна експортувати та перевірити на Whois — як варіант дуже цікаво.

- Конкуренти, які посилаються на дроп. Парсимо видачу на зовнішню кількість посилань конкурентів або близько тематичних сайтів. Можна навіть брати новинні сайти і парсити їх, ну, наприклад, Вікіпедію по конкретному ключу. За допомогою, до прикладу, Netpeak Spider, Scrapebox або Bluechip Backlinks перевіряємо вільність домену.

- Збір кластерів цікавих доменів і відстеження їхнього можливого дропу. Для цього беремо ключові слова, аналізуємо пошукову видачу та зберігаємо результати перших 30 сайтів впродовж пів року або року. Достатньо скласти топ 20-30 результатів і зберігати їх для подальшого аналізу. Перевіряти можна через Netpeak Spider чи SemRush. За допомогою такого нестандартного підходу я знайшов дуже багато класних новинних сайтів.

3. Аукціони. Окрім відомого GoDaddy, є DropCatch, Flippa та багато інших. Усі лінки знайдете у презентації.

Перевірка перед купівлею включає наступні елементи:

- Реф домени не менш ніж 100, (важливо, щоб не було посилань з коментів і різких падінь). Раніше я використовував від 20-30-50. Наразі, коли дуже велика конкуренція, — не менш ніж 100 без різких падінь. Тобто має бути стала динаміка приросту, ключі хоча б у топ 50 — це гарний показник того, що домен може спрацювати.

- Кількість ключів у топі, яка була історично у цього домену (Ahrefs).

- CF, TF по Majestic менше ніж 8, а їх співвідношення (від 0,6 до 1,5-1,8). Зараз використовую навіть 1,2, а ближче до одиниці — ідеал.

- Cпамні анкори з китайськими символами абощо — погана ознака, таке не використовуємо.

- Чек у вебархіві на наявність збереженої версії.

- Сторінки в індексі.

- Зміни Name Server (NS). Загальна допустима кількість — 2 рази. Перевірити можна зробити за допомогою CompleteDNS або інших тулзів.

Кейс: як вийти з просадки

Отож, яка робота була зроблена, щоб вийти з просадки на сайті, про який говорили раніше — де з 80к ми отримали 15к:

1. On Page:

- Переробили hreflang, alternate & x-default.

- Протестували різний контент, метатеги, h1. Завдяки цьому зрозуміли, що для нас працює краще: яка має бути величина контенту, яка кількість ключів і т.д.

- Змінили логіку у внутрішній перелінковці.

- Покращили Core Web Vitals та рендерінг сторінок.

- Оновили E-E-A-T фактори та Clear Main Content.

- Оновили Robots та відправили на переіндексацію.

- Sitemaps через Серч АПІ.

2. Off Page:

- Передивились весь профіль та відмовились від токсичних посилань, спам-профілів, незрозумілого крауду, спам-анкорки. Все це прибрали через Disavow.

- Прибрали неканонічні URL, пов’язані з http:// та www.

- Налаштували детальний фільтр для пошуку нових аутріч доменів та дропів.

Окремої уваги потребує робота над контентом: ми співпрацювали з копірайтерами-нейтівами, а також використовували якісні промпти для генерації текстів. Це були дуже детальні запити з низкою вимог до LLM (чи то ChatGPT, чи Lama), адже дуже важливо, з якою вхідною інформацією ви починаєте, щоб мати розуміння, що ви хочете отримати на виході.

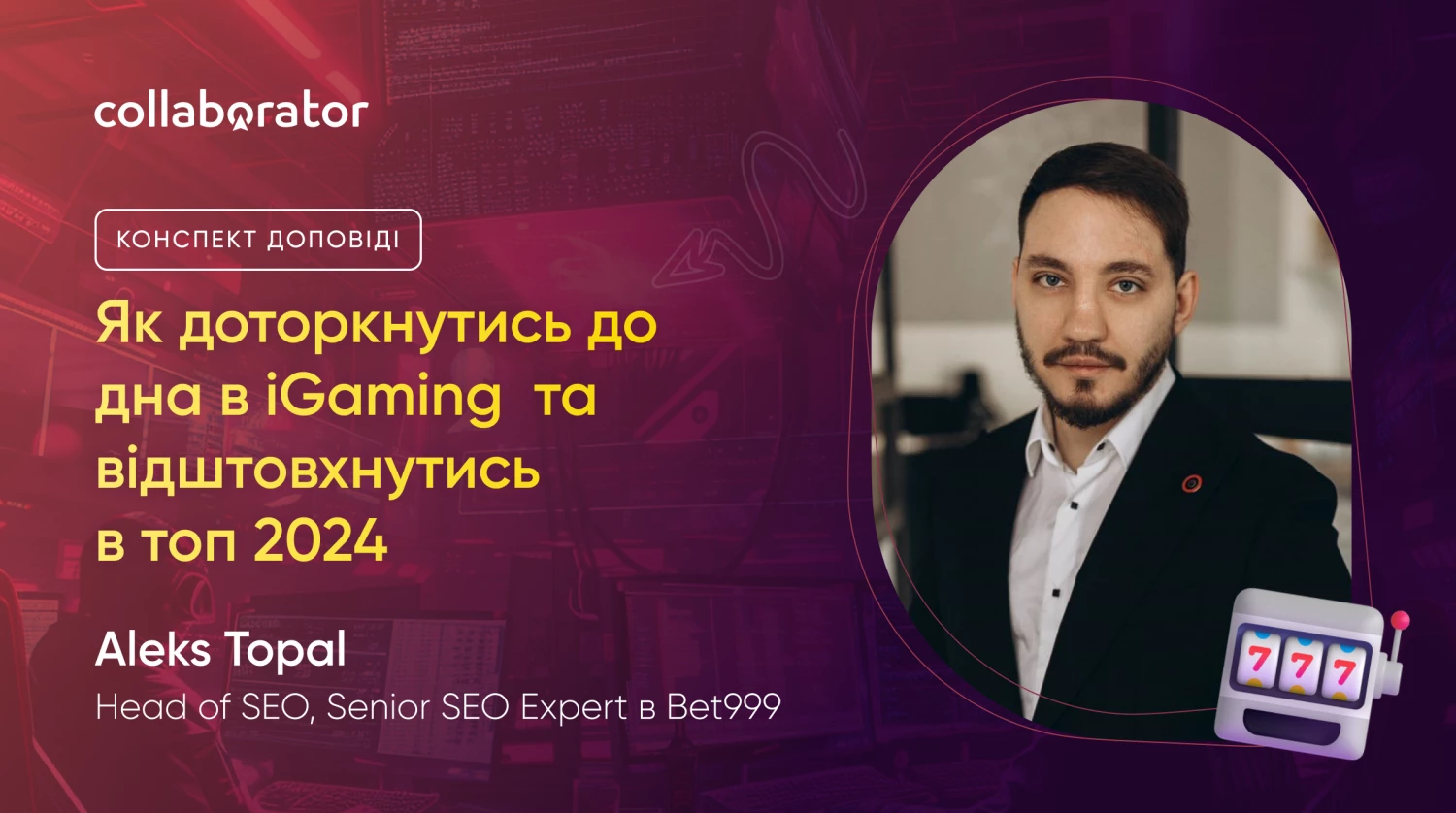

Так ми розробили чекліст правил, який використовуємо у створенні контенту:

- Включати ключові слова в метатеги та в H1.

- Заголовок H1 повинен складатись з 5-7 слів, не більше.

- LSI та другорядні запити використовувати в H2-H3, розбиваючи по всій структурі тексту.

- Головний ключ повинен бути використаний в першому абзаці.

- Довжина абзацу — 100-150 слів.

- Використовувати таблиці, списки, зображення та інші інтерактивні елементи, які розбавляють текст.

- В англійській мові допускається до 10% речень у пасивному стані.

- Не спамити ключами.

Я підготував детальний документ з прикладами промптів та детальними вимогами до тексту.

Це працювало до вересня 2023 року, але з початком HCU перестало приносити такі плоди.

Ми зрозуміли, що копірайтери, з якими співпрацюємо (як штатні, так і зовнішні), віддавали нам неякісні тексти. Ми перевіряли їх через Originality та Copyleaks і виявляли багато недоліків

Ми зрозуміли, що копірайтери, з якими співпрацюємо (як штатні, так і зовнішні), віддавали нам неякісні тексти. Ми перевіряли їх через Originality та Copyleaks і виявляли багато недоліків

Основний висновок: ні копірайтери, ні AI-контент без належного менеджменту вже не працюють ефективно. І користувачі, і тим паче Google легко помічають стандартні AI-паттерни. Тому ми розробили новий процес, який дозволяє створювати контент задовільної якості:

Новий підхід полягав у наступному: ми генерували 2-3 структури тексту, передавали їх копірайтеру для рерайтингу, потім створювали декілька варіантів тексту у ChatGPT, які передавали райтеру-нейтіву для фінальної обробки. Далі тексти могли розбивати на кластери для внутрішньої перелінковки, додавали зображення.

Окремо скажу про зображення у форматі WebP. Є невеличкий корисний лайфхак — це імплементування EXIF-даних. Тобто ви можете вказати автора, дату створення картинки та інші деталі. Це дозволяє Google краще розуміти контент і надає перевагу у ранжуванні.

З цим підходом нам вдалось вийти на новий рівень:

Результати оптимізації — покращення CTR та відновлення позицій

Результати оптимізації — покращення CTR та відновлення позицій

Ми проводили детальний аналіз кожної сторінки. Спочатку наш CTR був на рівні 2,5%, але після впровадження нової стратегії він зріс до 3-4%. Це довело, що наш контент дійсно адаптований для користувачів, а не просто наповнює блог чи сайт — такий підхід більше не працює.

Після технічної оптимізації, роботи з посиланнями, видалення сторінок з низькоякісним контентом та виконання багатьох інших задач упродовж 4 тижнів ми відновилися повністю. На кінець червня ми досягли майже тих же результатів, що й до проблем з апдейтами і санкціями Spam та HCU.

Зростання трафіку прослідковується і надалі завдяки впровадженню правильної стратегії

Зростання трафіку прослідковується і надалі завдяки впровадженню правильної стратегії

Правильні дії дають нам чіткий результат. Ми вже не граємо в морський бій: спочатку ми випробовували одну стратегію, яка не принесла очікуваних результатів, але пройшовши через всі етапи оптимізації, ми досягли того, що маємо зараз. Це надзвичайно важливо, адже багато сайтів взагалі не відновились після змін.

Наступний кейс — проєкт під ЛатАм, в якому ми зробили ставку на бренд:

Станом на середину липня у нас було вже більше 80к трафіку.

Ми знали, що є дуже гарні запити на монобренди в цій ніші та в цьому гео. По суті ми викатили сайт, умовно 15 сторінок, і буквально за 2-3 тижні отримали нереальні результати. Google віддав нам все, що можливо: і основні запити, і приставки типу логін, апки, слоти і тому подібне. Ми дуже гарно себе почували в перші місяці запуску, а потім почали додавати посилань і трохи розібралися по контенту.

На цьому прикладі ви можете побачити кореляцію, чому Гугл віддає перевагу. Як я вже зазначав на початку, що дуже багато рев'ю сайтів відійшли. А все тому, що, наприклад, у ніші холодильників дуже і дуже багато оглядів нових моделей з акцентом на купівлі, а юзерам часто це не релевантно, тому що в них вже є холодильник. А от що реально цікаво, то це розуміти, як його обслуговувати. І тут вже я не знаходжу жодної статті на рев'ю сайті. За такою логікою зрозуміло, чому ці вони відпадають наразі.

Black Hat SEO

Ми вже проговорили з вами детально і про апдейти, і про кейси, і як це впливало між собою. Але не на цьому не все, тому що є інші моменти, які я бачив в пошуковій видачі і які просто збивали з пантелику.

Були сайти, які з'являлись у видачі якраз після апдейту. А все тому, що вони зробили SQL-ін'єкції або зайшли через інші рівні безпеки на вже існуючі сайти, переважно e-commerce, і туди навантажили десятки тисяч кластерів.

Такі сайти у своєму рідному гео продовжують показувати стандартний контент, але в іншому гео з'являються у топі пошукової видачі з безліччю різних запитів і кластерів. Звичайний користувач або власник сайту може не помітити цих змін, адже на поверхні все виглядає нормально. Але такими сайтами «кишів» SERP приблизно 2-3 тижні мінімум.

Стратегія полягає в наступному:

- Збір ключів через Ahrefs/Semrush або парсинг метатегів та H1 інших дорів (великих конкурентів) за допомогою Screaming Frog

- Вибір ГЕО (tier 2/3), де простіше тестити вхід

- Парсинг контенту за допомогою Content Box & A-parser/X-parser або підказок Youtube

- Перехоплення дропів, що скоро звільняються, за допомогою Whik PRO, FreshDrop (або написання свого скрипта) + з Expireddomains, Аукціони (Godaddy)

- Заходити максимально швидко у видачу якраз після чергового апдейту, поки вона чиста, щоб легше було вибити

- Генерувати десятками тисяч сторінок і великими сітками = кілька сотень тис. трафіку, поки не відлетять LTV ~ 1 - 3 тижні.

Архітектура Google: NavBoost, санкції, витік Google

Google використовує складну архітектуру для організації свого індексу, розділяючи контент на кілька рівнів. Найважливіший контент, як-от статті Forbes та новинні сайти, зберігається на флеш-накопичувачах і регулярно оновлюється. Цей контент належить до першого ешелону. Менш важливий контент зберігається на портативних накопичувачах і включає великі та середні сайти з пріоритетом 2-3 рівня. Це вимірюється за допомогою PageRank NS та золотого документу. Найменш важливий контент, який рідко оновлюється або тільки що з’явився, зберігається на жорстких дисках (HDD) і має найнижчий пріоритет.

З цього можна зробити висновок: нерегулярно оновлюваний контент має найнижчий пріоритет зберігання для Google. Тому, щоб ваш контент мав вищий рейтинг, він має бути максимально свіжий, для цього додавайте унікальну інформацію, нові зображення, відеоматеріали та інші елементи.

Процес індексації починається з системи Александрії, яка збирає інформацію. Після цього SegIndexer розміщує документи за рівнями. TeraGoogle повторно сканує документи, що довго зберігаються, а Keto Score допомагає Google швидко ранжувати нові сторінки, надаючи їм тимчасове ранжування до остаточної оцінки.

Після індексації вступають в дію системи ранжування. Архітектура рейтингових систем Google має наступний вигляд:

- Mustang — основна система підрахунку очок, ранжування та обслуговування.

- Ascorer — основний алгоритм ранжування, який ранжує сторінки перед будь-якими коригуваннями повторного ранжування.

- Twiddlers — функції переранжування, які виконуються після основного алгоритму пошуку Ascorer.

- NavBoost — система повторного ранжування на основі журналів кліків про поведінку користувачів. Оцінює запити за намірами користувачів, коригуючи результати пошуку залежно від залученості користувачів у відео, зображення та інші типи контенту. Це один із найважливіших елементів систем ранжування Google, що підкреслює важливість створення контенту, який резонує з конкретними аудиторіями

- FreshnessTwiddler — система зміни рейтингу документів на основі свіжості.

- WebChooserScorer — визначає імена функцій, що використовуються під час оцінювання фрагментів.

Найважливішими компонентами по системі ранжування наразі є NavBoost, NSR і ChardScores:

- NSR (Normalized Site Rank) — це рейтинг сайту, що обчислюється для фрагментів сайту на рівні хосту. Він порівнює продуктивність кліків та залученість користувачів.

- ChardScores пов'язаний з поведінкою користувача і взаємодіями в браузері. Всі кліки та інші метрики, які використовуються користувачами, фіксуються через Chrome.

Далі ж детально поговоримо про NavBoost.

Що таке NavBoost?

NavBoost — це система повторного ранжування на основі даних про поведінку користувачів, зібраних через браузер Chrome. Вона оцінює запити за наміром користувача, коригуючи результати пошуку залежно від взаємодії користувачів з інтерактивними елементами на сторінці, такими як відео, зображення та CTA. Це підкреслює важливість створення контенту, що резонує з конкретними аудиторіями на самому сайті.

NavBoost використовує історичні дані про взаємодії юзерів для ухвалення рішень щодо ранжування. Система відстежує кліки на конкретні сайти, сайт-лінки та різні пошукові фічі, включаючи наведення миші або скролінг. Ці дані зберігаються і аналізуються для поліпшення майбутніх результатів пошукової видачі. Ці взаємодії зберігаються у вигляді різних атрибутів, таких як покази, кліки (хороші, погані, унікальні).

Які висновки можемо зробити з цього?

Пріоритет у ранжуванні віддається сайтам з кращим користувацьким досвідом (UX) та інтерфейсом (UI). Це означає, що дизайн, структура сайту, бренд та клікабельність є важливими факторами. Google надає перевагу сайтам, за якими стоїть реальний локальний бізнес.

Щоб оптимізувати сайт під NavBoost, слід:

- Визначити сторінки, які мають співвідношення 1:1 з високочастотними пошуковими запитами та іншими низькочастотними (НЧ) запитами.

- Відстежувати показники клікабельності, метрики взаємодії, баунсрейту (показник відмов) та кількість сторінок за сеанс (Session Pages).

- Постійно покращувати дизайн і контент, щоб вони відповідали потребам та інтентам вашої цільової аудиторії.

Панда: що це і як це працює

Алгоритм Панда був створений для покарання сайтів із поганим користувацьким досвідом (UX). Він оцінює взаємодію користувачів із сайтом, використовуючи певні сигнали для визначення його якості. Система генерує коефіцієнт модифікації для групи ресурсів на основі кількості незалежних посилань і кількості посилальних запитів. Тут важливо зрозуміти, що посилальні запити є запитами з NavBoost.

Панда не лише карає сайти з поганим UX, але й дає змогу вийти в ТОП завдяки якісному дизайну та контенту. Алгоритм працює на те, щоб відділити високоякісний контент від низькоякісного або створеного для машин.

Оновлення алгоритму, відоме як Baby Panda, застосовується поверх основного алгоритму Панда. Це означає, що навіть після накладення санкцій на сайт, як це було у вересні 2023 року, сайт може бути повторно просканований і знову покараний.

Санкції та сигнали спаму

Окрім Панди, є ще й інші санкції, які можуть бути застосовані:

- Penguin (Пінгвін) — за надмірне повторення анкорних текстів та спамних посилань (спаму в анкорах)

- Дропи — за рахунок спам апдейту.

Причини для песимізації можуть бути наступні:

- невідповідність прив'язки (нерелевантність посилання цільовому сайту);

- зниження результатів видачі через високий bounce rate (напр., швидкі виходи із сайту через поганий користувацький досвід, незрозумілий інтерфейс тощо);

- зниження рівня навігації;

- зниження рівня доменів із точною відповідністю (Exact Match Domains) через маніпуляції з ключовими словами;

- зниження рівня огляду продукту (сайти, які підпадають під цю категорію, — рев'юшники);

- зниження місця розташування;

- зниження порно — це досить очевидно.

Сигнали спаму:

- PhraseAnchorSpamPenalty — комбінований штраф за зниження анкора;

- SpamRank — вимірює ймовірність того, що документ посилається на відомих спамерів;

- KeywordStuffingScore — вимірює ступінь наповнення ключовими словами, що карається;

- SpambrainTotalDocSpamScore — використовує ШІ для оцінки рівня спаму в документі;

- Spamrank — оцінює ймовірність того, що документ посилається на відомих спамерів;

- GibberishScore — виявляє безглуздий контент;

- Spam tokens content score — ідентифікує спамні слова;

- TrendspamScore — відстежує трендові теми спаму.

Є ознаки того, що глобальні сторінки можуть бути знижені у видачі. Це свідчить про те, що Google віддає перевагу не агрегаторам, а навпаки — сайтам, які будують кращий контент і будують його локально. Тому, якщо у видачі присутні великі агрегатори, не варто перейматись: є шанс зробити сторінку конкретно під штат/місто і просунути їх у топ. Наприклад, у мене були бізнеси, в яких CEO сам створював чи редагував тексти, і це працювало нереально круто.

Щодо спамності: дуже багато було про неї у витоку — і з точки зору анкорів, і з точки зору інших величин. Google має активний захист від спаму, який активізується при виявленні атаки на сайт: якщо аномальна кількість посилань починає одномоментно вказувати на певну сторінку, вона тимчасово одразу знижується в ранжуванні. Після завершення атаки Гугл аналізує анкори, і «early trusted anchors» допомагають відділити атаку від наявних нормальних посилань. Атака зі спамними анкорами видаляється Гуглом.

Embeddings

Ембедінги відіграють центральну роль у розумінні контенту Google-ом. Важливими поняттями в цьому контексті є Site Score, Site Focus та Site Radius.

Google оцінює сайт за певною темою і порівнює цю тему з внутрішніми сторінками, щоб визначити, наскільки релевантність спрямована з внутрішніх сторінок на головну. Це основне, що потрібно розуміти про embeddings.

Ембедінги представляють окремі сторінки у вигляді щільних векторів у високорозмірному просторі та відображають семантичне значення і релевантність змісту сторінки. Вони використовуються для вимірювання подібності, кластеризації сторінок, оцінки їх якості, тематичності, спаму і контролю версій (зокрема, чи видалявся текст повністю або частково).

Оскільки ембедінги використовуються на кожній сторінці та на всьому сайті, важливо оптимізувати заголовки за запитами та забезпечити, щоб абзаци під заголовками чітко та стисло відповідали на них. Це допоможе забезпечити релевантність тематичних статей.

Авторство, JSON

Авторство — це сигнал ранжування. Google зберігає авторів у вигляді текстового рядка або намагається виокремити авторів з об'єктів на сторінці.

Удосконалюйте мікророзмітку, прописуйте авторів максимально повно.

Про авторство та EEAT є в самій документації Google. Окрім того, що у вас повинен бути відповідальний копірайтер/Head of Content, який вказаний на сайті з посиланням на соціальні мережі (LinkedIn), сторінка має мати мікророзмітку: такий сигнал допоможе гуглу краще розуміти, про що ваш сайт. Нема 100%, що він буде ранжувати його вище, але це вже буде невелика перевага.

Google зберігає те, що проіндексував, назавжди та використовує тільки останні 20 змін для даної URL-адреси під час аналізу посилань. Це має дати вам уявлення про те, скільки разів вам потрібно міняти сторінки та індексувати їх, щоб отримати «чистий аркуш». При цьому, зміни стосуються не 2-3 слів, потрібно змінити хоча б 2-3 абзаци, видалити текст або змінити структуру сторінки.

Формула по факторах, що витекли

Повна формула має наступний вигляд:

R=((w1)+v3⋅ShoppingScore+v4⋅PageEmbedding+v5⋅SiteEmbedding+v6⋅SiteRadius+v7⋅

⋅SiteFocus+v8⋅TextConfidence+v9⋅EffortScore)+(x1⋅TrustedAnchors+x2 ⋅SiteLinkIn+x3⋅PageRank))×(TopicEmbedding+QnA+STS+SAS+EFTS+FS)+(y1⋅CDS+y2⋅SDS+y3⋅EQSS)

Звісно, вона дуже відносна, і узагальнено можна її пояснити таким чином:

R = UIS (Оцінки взаємодії з користувачем + CQS (Оцінки якості контенту) + LS (Оцінки посилань) x (RB (Підвищення релевантності) + QB (Підвищення якості)) + CSA (коригування оцінок, специфічних для контенту)] - (Сукупний показник зниження)

Тепер детально про її компоненти:

1. UIS — оцінка взаємодії з користувачем, що включає:

- UgcScore, який відповідає за оцінку на основі взаємодії з контентом, до залученості користувачів.

- TitleMatchScore — відповідає за оцінку релевантності самого заголовка і відповідності запиту.

- ChromeInTotal — загальна кількість взаємодій, яка відстежується за допомогою хром.

- TopClicks — рейтинг кліків для тематичних сторінок тощо.

2. CQS — сигнали якості контенту, зокрема, зображень, відео, кліків по них та їх переглядів.

3. LS оцінка посилань:

- TrustedAnchors — якість і надійність вхідних посилань.

- SiteLinkIn — середнє значення вхідних посилань.

- PageRank з урахуванням різних факторів (NR, різних рівнів від 0 до 2 ToolBar і т.д).

4. RB — підвищення релевантності.

5. QB — підвищення якості.

6. CSA — розуміння контенту:

- PageEmbedding.

- SiteEmbedding.

- SiteRadius.

- SiteFocus.

- TextConfidence.

- EffortScore.

В кінці віднімається сукупний показник зниження, тобто всі ці фільтри.

Практичні рекомендації з Google Data Leak

Поради з використання анкорів:

- Контент вихідної сторінки має бути релевантний цільовій сторінці. В іншому випадку посилання може бути проігноровано. Тобто якщо тема різна між донором і акцептором, гугл може на це посилання просто «забити».

- Посилання, що використовує брендовий анкор-текст або оточений текстом, що визначає бренд, має більше вагу, ніж без такого контекстного визначення.

- Наявність релевантних посилань з тієї ж країни може позитивно впливати на ранжування в пошуку. Тобто пріоритет — регіон, і вже тільки потім тематика.

- Early Trusted Anchors (ранні довірені анкори). Сторінка може бути «захищена» ранніми довіреними текстами анкорів від негативних SEO-атак.

Поради щодо правильного використання посилань:

- Якість посилань набагато важливіша за їхню кількість. Це означає, що посилання з авторитетних сайтів (новинних сайтів або сайтів типу .gov, .edu) — це пріоритет.

- Nofollow посилання з, наприклад, Форбс, безсумнівно буде передавати більше ваги, ніж Dofollow посилання з локальних, регіональних новинних сайтів.

- Сторінки, які вважаються свіжими, також визначаються якісними. Тому важливо, щоб посилання, які ви будуєте, надходили з максимально нових сторінок або тих, які знаходяться на найвищому рівні вкладеності. Це частково пояснює, чому утримання топу на сторінках з високим рейтингом і на новинних сторінках дає вищі показники самому сайту.

- Зворотні посилання від бренду, від реальних компаній, у яких є блог, це теж один із найпотужніших факторів. Вам потрібно отримувати більше успішних кліків, використовуючи широкий набір запитів, щоб отримати більше різноманітності посилань. Якщо ви хочете й надалі бути краще, ніж ваші конкуренти, посилання з нерелевантного контенту або з інших країн можуть бути менш цінними.

Поради по контенту для кращого ранжування:

- Найважливішу інформацію розміщуємо вгорі, тобто на першому екрані до лінії згину: ключі в першому абзаці, відповідь на інтент користувача має бути максимально містка і стисла.

- Якщо сам контент надмірно короткий, то включається додаткова оцінка його оригінальності, яка називається Original Content Score, що може підвищити або знизити його рейтинг.

- Тестуйте скорочення контенту, який не буде націлений на ваші Money Pages — сторінки, що прямо генерують вам трафік. Спробуйте йти від малого до великого і дивитись, які будуть результати. Якщо все ок, ви можете те ж саме в принципі робити на головних сторінках.

- По об'єму контенту Google не дає конкретної інформації, але орієнтуйтесь на не менш ніж на 5 тисяч символів, золота середина — 1000 слів.

- Google розрізняє незначні та значні оновлення самого контенту, підкреслюючи важливість свіжого контенту.

- У самому витоку є інформація про важливість сторінок, які називаються референтними, тобто додатковими (по типу глосарія із Вікіпедії). Тому включення термінів із цих довідкових сторінок може підвищувати релевантність.

- Головне позначати дату як і на самому контенті, так і в сайтмапі, в інакшому випадку чекайте песимізації.

Питання-Відповідь

Які були ваші подальші дії з дропами після падіння трафіку? Ви їх відклеювали? Якщо так, то як ви обрали, які саме потрібно відклеїти?

Усе залежало від того, яка стратегія у нас була. Були моменти, коли було дуже багато дропів в одній країні, тому ми відклеювали їх. Було таке, що навпаки брали EMD, клеїли все це туди і тестували, наскільки це ефективно.

Бувало таке, що не залітає дроп, ми просто всю цю масу редиректили на інше. Бувало, що просто відклеювали. Дуже багато просто лежить, тому що ще волатильність не закінчилась, тому поки чекаємо.

Ви казали відмовитись від токсичних посилань. Як саме потрібно відмовитись? У вас був тільки файл Disavow? Бо є сумніви чи він працює.

Ми використовували файл Disavow, але основну увагу приділяли релевантності. Переглядали профілі, крауди, директорії, каталоги, і якщо вони не мали актуальності, відмовлялися від них у 2-3 етапи, щоб Google не почав песимізувати нас, коли почнемо віддавати йому реальні показники.

Релевантні та цінні посилання залишалися, що дало позитивний результат. Це стосується WhiteHat проєктів, для тестування дропів можна використовувати будь-які методи — і ломи, і не тільки. Отож, все залежить від цілей.

Тобто взагалі Disavow можна використовувати? Він може дати якийсь результат?

Він дає результат. Тут дуже залежить від того, що ви туди «напхали». Я вам не буду давати жодних гарантій, що все буде круто, адже все залежить від практики.

Чи велась якась посилена робота з соціальними мережами та трафіком звідти для виходу з-під санкцій?

Взагалі із витоку по гуглу зрозуміло, що ПФ (поведінкові фактори) дуже сильно корелюють. Але проблема в тім, що є сервіси, які накручують ці ПФ із соцмереж і не тільки. Гуглу ця база знайома, вона дуже мала і щільна. Тому від цього ми відмовлялись або просто вели свої соцмережі, де була можливість їх вести, де був ресурс на це. Пропрацьовували контент-план, підтримували динаміку. Якщо ви 1-2 пости викладете, результату не буде, це теж потрібно розуміти.

Як краще викатувати великий сайт: частинами чи краще весь одразу?

Якщо технічний стан сайту в порядку, я б викатував одразу все. Потім треба проіндексуватись, і зможемо побачити одразу результати. Все одно сторінки будуть додаватись, адже це не константа.

Як показує практика, якщо щось тримати в беклозі, буде менше результатів, менше кліків. Це логічно, просто по факту видимості самого сайту. І до того ж ніхто не відміняв сендбокс.

Яким чином шукаєте ідеї для нових сайтів? З наловлених дропів, з видачі, з Ahrefs чи є якісь інші способи?

Є різні способи, як можна їх шукати. Але взагалі усе є у видачі. За останні 3-4 роки я нічого нового не побачив.

Ось тому дуже важливо дивитись на якомога більше факторів і зібрати якомога більше даних про ваших конкурентів: яка кількість посилань, яка динаміка, яка структура контенту, скільки слів, скільки сторінок в індексі, якого року домен і так далі.

Як сайти агрегатори себе почувають після останніх апдейтів?

Є моменти, де просідають. Наприклад, Гугл віддає перевагу регіональним сайтам. Але я точно не можу вам сказати про всі, тому що агрегатори — це трошки не про iGaming.

Те, що я бачив, особливо на американському пошуку, це взагалі хаос. Що зробив Гугл? Він зробив партнерку з Reddit і почалось дуже багато запитів, навіть медичних і не тільки, агрегуватись з самого Reddit.

Є просадка — не настільки, щоб стати мертвими, але дуже відчутна.

Чи можна десь подивитись саммарі важливих думок із Google Data Leaks?

Я бачив, релізнули таблицю прямо з факторами, де вже все поділено. SEO-оптимізатори на буржі це все відправили в чат і потім ще самі проробили. 3-4 місяці можна це вивчати.

У мене є сторінка різних матеріалів. Тому кому цікаво я просто можу поділитись цим без проблем.

Від усієї команди Collaborator та слухачів вебінару дякуємо Алексу за насичену корисними рекомендаціями та змістовну доповідь🦾 Щиро зичимо Успіхів, ТОПів у пошуковій видачі та стійкості під час майбутніх апдейтів🙂